Что такое парсинг данных в машинном обучении

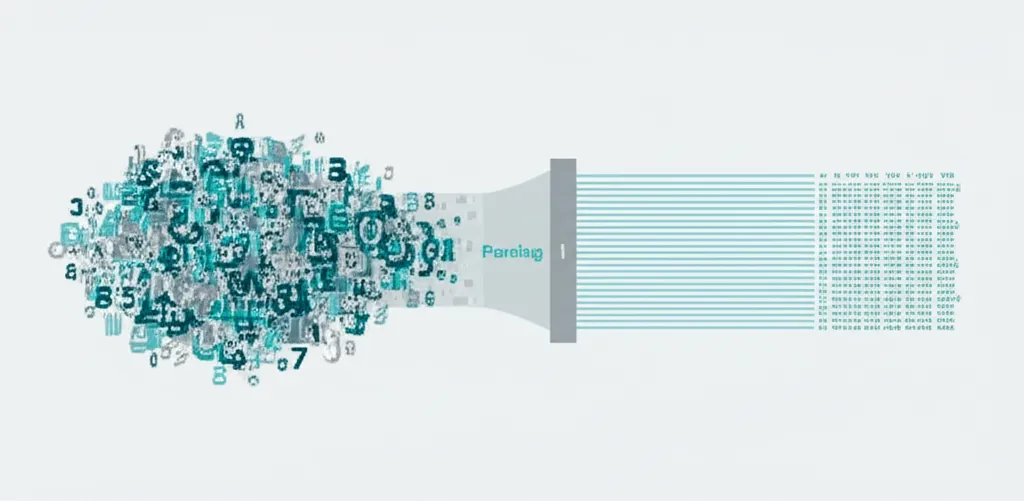

Что такое парсинг данных в машинном обучении? Если говорить просто, это процесс преобразования информации из одного формата, часто неудобного и хаотичного, в другой — структурированный и понятный для алгоритмов. Представьте, что вы получили дневник путешественника, написанный от руки, с заметками на полях, вклеенными билетами и рисунками. Чтобы проанализировать его маршрут, вам нужно аккуратно извлечь даты, названия городов, виды транспорта и расходы, а затем записать всё это в аккуратную таблицу. Этот процесс и есть аналог парсинга. В мире ML исходные «дневники» — это веб-страницы, текстовые файлы, логи серверов или PDF-документы. Алгоритмы не могут работать с таким хаосом напрямую. Парсинг выступает в роли переводчика и организатора, который готовит «пищу» для моделей искусственного интеллекта.

Зачем нужен парсинг: от хаоса к структуре

Основная цель этого процесса — сделать сведения пригодными для анализа и дальнейшего использования в моделях. Исходные материалы, с которыми сталкиваются специалисты, редко бывают идеально организованными. Они могут быть представлены в виде:

- HTML-кода веб-страниц: Информация о товарах, статьи, отзывы пользователей и контактные сведения «спрятаны» внутри тегов разметки.

- JSON или XML файлов: Хотя они и являются полуструктурированными, для конкретной задачи часто требуется извлечь лишь определённые поля и вложенные элементы.

- Текстовых документов: Научные статьи, юридические контракты, новостные ленты, где ключевая информация разбросана по всему тексту.

- Логов приложений: Записи о действиях пользователей, системных ошибках и событиях, которые нужно систематизировать для выявления аномалий.

Без предварительного анализа и структурирования все эти сведения представляют собой «цифровой шум». Модель, обученная на необработанных материалах, не сможет выявить закономерности и будет выдавать неточные или бессмысленные результаты. Парсинг позволяет извлечь ценные сущности — имена, цены, даты, геолокации, характеристики — и поместить их в предсказуемый формат, например, в строки и столбцы таблицы CSV или базы сведений.

Ключевые этапы процесса извлечения

Процедура структурирования информации не является монолитной. Её можно разбить на несколько логических шагов, которые выполняются последовательно для достижения конечного результата. Хотя конкретная реализация зависит от задачи и источника, общая схема выглядит следующим образом:

- Получение исходного материала. Первый шаг — это доступ к источнику. Это может быть загрузка HTML-кода страницы с помощью HTTP-запроса, открытие локального файла или подключение к API для получения ответа в формате JSON.

- Лексический анализ (токенизация). На этом этапе сплошной поток символов разбивается на минимальные логические единицы — токены. Для текста это могут быть слова, знаки препинания, числа. Для кода — ключевые слова, операторы, идентификаторы. Цель — получить набор «кирпичиков» для дальнейшего анализа.

- Синтаксический анализ. После токенизации система анализирует, как эти «кирпичики» связаны друг с другом. Она строит иерархическую структуру, часто в виде дерева (например, DOM-дерево для HTML). Это позволяет понять вложенность элементов и их взаимосвязи, как в предложении мы понимаем, где подлежащее, а где сказуемое.

- Извлечение и преобразование. Имея синтаксическую структуру, можно целенаправленно извлекать нужные сведения. Например, найти все теги

<h2>с классом 'product-title' и забрать из них текст. На этом же этапе происходит очистка и нормализация: удаление лишних пробелов, приведение дат к единому формату, конвертация цен в числовой тип. - Сохранение результата. Финальный шаг — сохранение извлечённой и очищенной информации в удобном для дальнейшей работы виде. Чаще всего это файлы CSV, таблицы в базе сведений, объекты JSON или структуры данных вроде Pandas DataFrame в Python.

Качество входных сведений напрямую определяет качество работы любой ML-модели. Принцип «мусор на входе — мусор на выходе» (Garbage In, Garbage Out) здесь актуален как никогда, и парсинг — это первый и важнейший фильтр, который отделяет ценную информацию от шума.

Инструменты и технологии для парсинга

Для выполнения задач по извлечению информации существует множество готовых инструментов и библиотек, которые значительно упрощают работу специалиста. Выбор зависит от источника и сложности задачи.

- Для веб-страниц (веб-скрапинг): Python-библиотеки, такие как Beautiful Soup, отлично подходят для разбора HTML и XML документов. Для более сложных сайтов с динамическим контентом, который подгружается с помощью JavaScript, используют инструменты вроде Selenium или Playwright, имитирующие действия пользователя в браузере. Фреймворк Scrapy предлагает комплексное решение для создания быстрых и масштабируемых «пауков» для обхода сайтов.

- Для текста и регулярных выражений: Модуль re в Python является мощнейшим инструментом для поиска и извлечения информации по шаблонам (регулярным выражениям). Он незаменим, когда нужно найти все email-адреса, номера телефонов или даты в определённом формате внутри большого текстового массива.

- Для структурированных форматов: Для работы с JSON и XML существуют встроенные в большинство языков программирования библиотеки. Они позволяют легко преобразовывать строки в объекты и словари и получать доступ к нужным полям по ключам.

Практические примеры применения в Machine Learning

Парсинг — это не абстрактная концепция, а основа для решения множества реальных задач в области машинного обучения и анализа сведений.

Анализ тональности отзывов. Компании собирают отзывы о своих продуктах с маркетплейсов и социальных сетей. С помощью парсинга извлекается текст отзыва, имя автора, дата и оценка. Затем эти структурированные тексты передаются NLP-модели, которая определяет эмоциональную окраску (позитивная, негативная, нейтральная). Это помогает быстро реагировать на проблемы и понимать настроения клиентов.

Создание датасетов для обучения. Для обучения моделей распознавания образов нужны тысячи размеченных изображений. Парсеры могут автоматически обходить сайты-фотостоки, скачивать картинки по определённым запросам и извлекать их описания или теги, формируя готовый набор для тренировки нейронной сети.

Динамическое ценообразование. Интернет-магазины используют парсинг для мониторинга цен конкурентов. Специальные скрипты регулярно обходят сайты-конкуренты, извлекают информацию о ценах на аналогичные товары. Эти сведения поступают в модель, которая рекомендует оптимальную цену для собственного товара, чтобы оставаться конкурентоспособным.

Роль парсинга в жизненном цикле ML-модели

В общем конвейере создания продукта на основе машинного обучения (ML pipeline), парсинг занимает одно из первых и самых ответственных мест. Он является ядром этапа сбора и предобработки сведений. Без качественного извлечения и структурирования весь последующий процесс — разведочный анализ, создание признаков (feature engineering), обучение и оценка модели — теряет смысл. Ошибки, допущенные на этом шаге, будут каскадом распространяться дальше и приведут к созданию неэффективной или неработающей модели. Таким образом, парсинг — это фундаментальный навык для любого специалиста по сведениям, который превращает сырую, разрозненную информацию в топливо для алгоритмов искусственного интеллекта.