Что значит парсинг в программировании

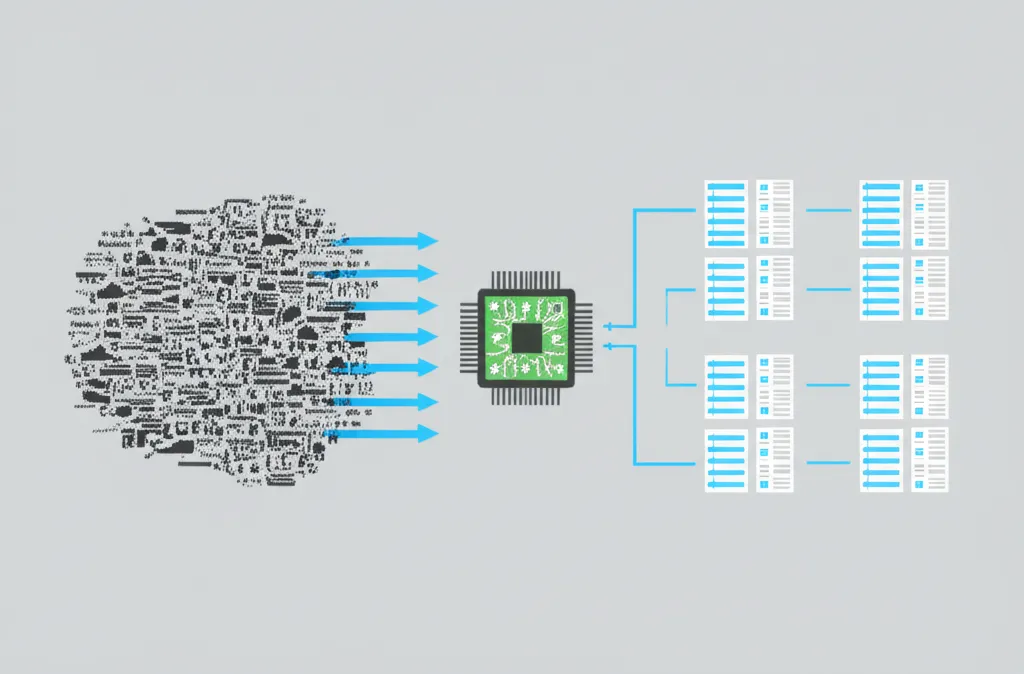

Что значит парсинг в программировании — это процесс автоматического анализа данных и их преобразования из одного формата в другой, более структурированный и удобный для машинной обработки. Представьте, что у вас есть огромный неструктурированный текст, например, веб-страница или лог-файл сервера. Человеку сложно быстро найти в нем нужную информацию. Парсер — это специальная программа или компонент, который «читает» эти данные, разбирает их на составные части по определенным правилам и представляет в виде удобной структуры, например, таблицы, списка или дерева объектов. Этот процесс является фундаментальным для множества IT-задач, от создания компиляторов языков до сбора информации в интернете.

Основная цель синтаксического анализа — превратить хаотичный поток символов в упорядоченный набор элементов, с которыми может работать другая программа. Аналогию можно провести с изучением иностранного языка: сначала вы видите незнакомые буквы (символы), затем учитесь складывать их в слова (токены), а после этого — строить из слов осмысленные предложения (синтаксическая структура). Парсер выполняет похожую работу, но для машин. Он следует заранее определенной грамматике — набору правил, описывающих структуру входных данных.

Ключевые этапы синтаксического анализа

Процесс разбора данных редко бывает монолитным. Обычно его можно разделить на два основных этапа, которые выполняются последовательно для достижения конечного результата. Понимание этой механики помогает глубже осознать, как работает извлечение информации.

- Лексический анализ (токенизация). На этой стадии исходная строка или файл разбивается на мельчайшие значимые единицы — «токены». Токен — это элементарная часть грамматики, например, число, ключевое слово, оператор или знак препинания. Например, строка

price = 150;будет разбита лексическим анализатором на токены: «price» (идентификатор), «=» (оператор присваивания), «150» (число) и «;» (конец выражения). Этот этап упрощает дальнейшую работу, так как синтаксическому анализатору уже не нужно оперировать отдельными символами. - Синтаксический анализ (непосредственно парсинг). Получив на вход последовательность токенов, синтаксический анализатор проверяет, соответствует ли она правилам заданной грамматики. Он выстраивает из токенов иерархическую структуру, чаще всего — синтаксическое дерево (Abstract Syntax Tree, AST). Это дерево наглядно представляет логические связи между элементами. Если последовательность токенов нарушает правила грамматики, анализатор сообщает об ошибке.

Где применяется разбор данных на практике?

Области применения этой технологии чрезвычайно широки. Она лежит в основе многих привычных нам цифровых инструментов и сервисов. Вот лишь несколько примеров, где синтаксический анализ играет ключевую роль:

- Веб-скрейпинг. Это, пожалуй, самый известный пример. С помощью парсеров компании собирают информацию с веб-сайтов: цены на товары в интернет-магазинах, новостные статьи, контактные данные, отзывы пользователей. Это позволяет проводить мониторинг конкурентов, анализировать рынок и агрегировать контент.

- Компиляторы и интерпретаторы. Когда вы пишете код на языке вроде Python или Java, специальная программа (компилятор или интерпретатор) сначала парсит ваш код. Она проверяет его на синтаксические ошибки и преобразует в понятный для компьютера формат. Без этого механизма программирование было бы невозможным.

- Работа с форматами данных. Программы постоянно обмениваются информацией в форматах JSON, XML, CSV. Чтобы приложение могло прочитать и использовать сведения из такого файла, оно должно сначала его распарсить, то есть преобразовать текстовое представление в объекты и структуры данных внутри программы.

- Анализ лог-файлов. Системные администраторы и DevOps-инженеры анализируют гигабайты логов для поиска ошибок и аномалий в работе систем. Специальные инструменты используют парсеры для извлечения из текстовых логов структурированной информации: времени события, уровня ошибки, IP-адреса и сообщения.

Разновидности парсеров и их логика работы

Существует множество подходов к построению анализаторов. Глобально их можно разделить на две большие категории в зависимости от стратегии построения синтаксического дерева. Выбор конкретного типа зависит от сложности грамматики, требований к производительности и простоты реализации.

Нисходящий и восходящий анализ

Нисходящие парсеры (Top-Down) начинают разбор с самого верхнего уровня — стартового символа грамматики — и пытаются последовательно применить правила, чтобы получить исходную последовательность токенов. Это похоже на то, как человек пытается угадать структуру предложения, начиная с общей идеи. Одним из самых популярных методов является рекурсивный спуск, который относительно прост для ручной реализации.

Восходящие парсеры (Bottom-Up), наоборот, начинают с «земли» — с последовательности токенов. Они постепенно группируют токены в более крупные грамматические конструкции, «сворачивая» их, пока не дойдут до стартового символа. Этот подход сложнее в реализации вручную, но часто бывает более мощным и эффективным. Он лежит в основе многих генераторов парсеров, таких как YACC или Bison.

Выбор метода синтаксического анализа — это компромисс между сложностью грамматики, которую он может обработать, скоростью работы и объемом кода, который придется написать и поддерживать. Для простых задач часто достаточно нисходящего подхода, тогда как для сложных языков требуются более мощные восходящие анализаторы.

Юридические и этические аспекты сбора информации

Когда речь заходит о сборе сведений с веб-сайтов (веб-скрейпинге), важно помнить о правовой и этической стороне вопроса. Неконтролируемый сбор информации может нанести вред владельцам ресурсов и нарушить законодательство.

- Файл `robots.txt`. Прежде чем запускать скрейпер на сайт, проверьте этот файл. В нем владельцы ресурса указывают, какие разделы сайта можно сканировать автоматическим программам, а какие — нельзя. Игнорирование этих правил является дурным тоном.

- Нагрузка на сервер. Слишком частые и агрессивные запросы могут создать чрезмерную нагрузку на сервер сайта, замедлив его работу для обычных пользователей или даже вызвав отказ в обслуживании. Всегда используйте задержки между запросами.

- API в приоритете. Если у сайта есть официальный API (программный интерфейс приложения), всегда используйте его. Это легальный, надежный и наиболее эффективный способ получения данных, предусмотренный разработчиками.

- Персональные данные. Сбор и обработка персональных сведений (имена, телефоны, email) регулируются законами, такими как GDPR в Европе. Убедитесь, что ваши действия не нарушают правил конфиденциальности.

Популярные инструменты и библиотеки

Сегодня не нужно писать парсер с нуля для каждой задачи. Существует множество готовых библиотек и фреймворков, которые значительно упрощают процесс извлечения и обработки контента. Выбор инструмента зависит от языка программирования и специфики задачи.

В экосистеме Python самыми популярными являются:

- BeautifulSoup: Идеальна для разбора HTML и XML файлов. Позволяет легко перемещаться по дереву документа, искать теги по различным атрибутам и извлекать их содержимое.

- Scrapy: Полноценный фреймворк для веб-скрейпинга. Он включает не только инструменты для парсинга, но и механизмы для асинхронной отправки запросов, управления сессиями и сохранения результатов.

- LXML: Очень быстрая и мощная библиотека для работы с XML и HTML, написанная на C.

Для JavaScript (Node.js) часто используют:

- Cheerio: Быстрый и гибкий инструмент, реализующий подмножество jQuery для работы на сервере. Отлично подходит для манипуляций с HTML-структурой.

- Puppeteer: Библиотека для управления браузером Chrome в headless-режиме. Она позволяет работать с сайтами, которые активно используют JavaScript для рендеринга контента, что недоступно простым HTTP-клиентам.

Помимо специализированных библиотек, для простых задач по извлечению текстовых паттернов широко применяются регулярные выражения (Regular Expressions). Это мощный, хотя и сложный в освоении, инструмент, встроенный практически во все современные языки программирования.