Веб-скрапинг с mcp server: новый уровень автоматизации сбора данных

Веб-скрапинг с mcp server представляет собой современный подход к извлечению информации с сайтов, который решает большинство проблем традиционного парсинга. Этот метод позволяет автоматизировать процесс сбора публичных данных в больших объемах, обходя блокировки и другие защитные механизмы. Для бизнеса это означает доступ к ценной информации о конкурентах, рыночных тенденциях и поведении потребителей без значительных затрат на разработку и поддержку сложной инфраструктуры.

Что такое извлечение данных и зачем оно нужно?

Если говорить просто, скрапинг — это автоматизированный сбор информации с веб-страниц. Вместо того чтобы вручную копировать текст, цены или контакты, специальная программа (парсер) делает это за вас быстро и в больших масштабах. Полученные сведения структурируются и сохраняются в удобном формате, например, в таблице Excel или базе данных. Это открывает широкие возможности для анализа и принятия взвешенных решений.

Сферы применения технологии обширны:

- Мониторинг цен: интернет-магазины отслеживают стоимость товаров у конкурентов для формирования оптимальной ценовой политики.

- Анализ рынка: компании собирают информацию о продуктах, услугах и отзывах для понимания текущей конъюнктуры.

- Генерация лидов: маркетологи находят контактные данные потенциальных клиентов из открытых источников.

- Агрегация контента: новостные порталы или сервисы сравнения собирают материалы с десятков сайтов в одном месте.

Основные трудности классического парсинга

Запуск простого скрипта для сбора информации с домашнего компьютера часто заканчивается неудачей. Современные веб-ресурсы активно защищаются от автоматизированных запросов, используя комплексные меры. Основные препятствия включают:

- Блокировка по IP-адресу: если с одного IP-адреса поступает слишком много запросов за короткое время, система безопасности сайта блокирует его.

- CAPTCHA: знаменитая проверка «я не робот», которую автоматическому скрипту пройти крайне сложно.

- Динамический контент: многие сайты подгружают информацию с помощью JavaScript уже после загрузки основной страницы. Простой парсер не увидит этих сведений.

- Заголовки и User-Agent: ресурсы анализируют техническую информацию о запросе, чтобы отличить реального пользователя от бота.

Решение этих проблем требует создания сложной системы с пулом прокси, эмуляцией браузеров и алгоритмами обхода защит. Это дорого и трудоемко.

Как работает веб-скрапинг с mcp server и в чем его сила

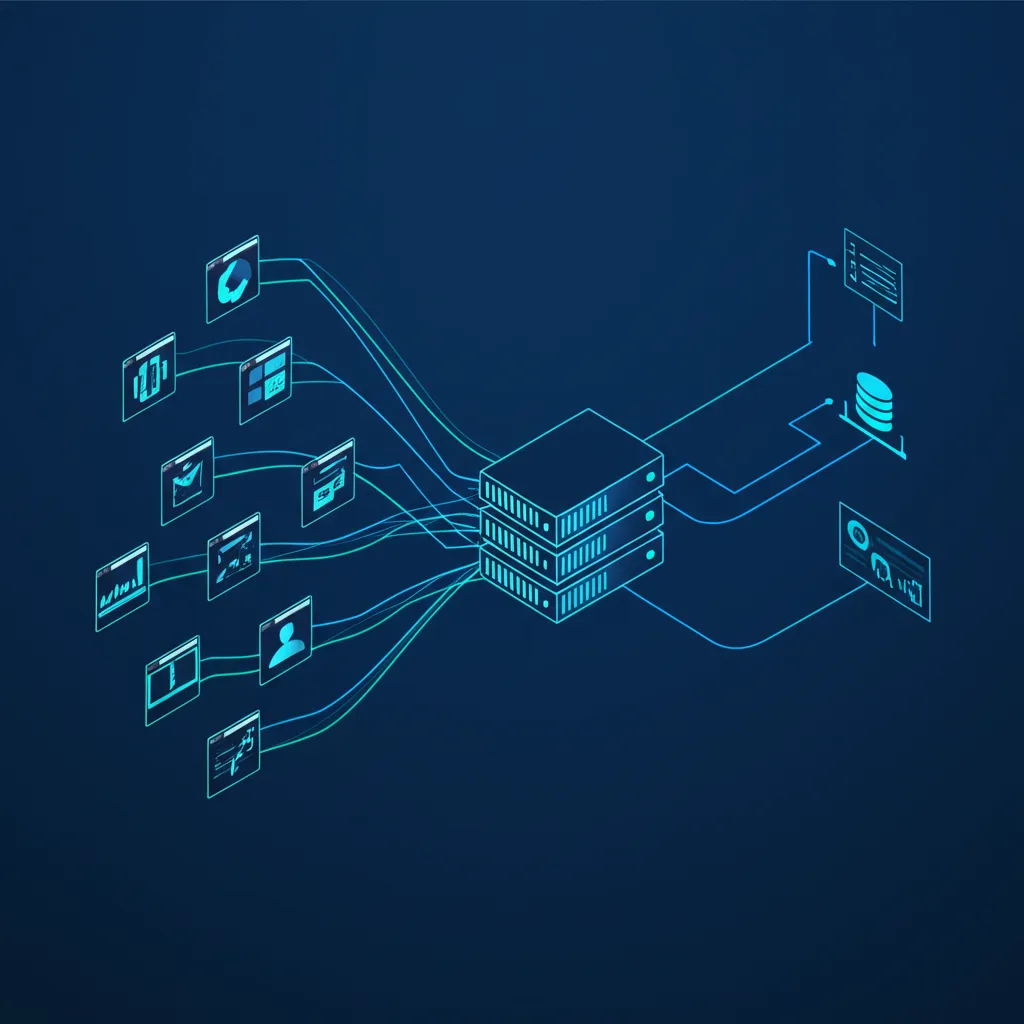

Именно здесь на помощь приходят MCP-решения (Managed Configured Proxy). Это не просто отдельный сервер, а целая инфраструктура, созданная специально для задач парсинга. Она берет на себя всю технически сложную работу по обходу блокировок, позволяя разработчику сосредоточиться на логике извлечения нужных полей со страницы. Ваш скрипт отправляет один запрос к MCP-сервису, указывая целевой URL, а платформа делает все остальное.

Использование специализированных решений позволяет сфокусироваться на логике извлечения информации, а не на борьбе с анти-бот системами.

Ключевые преимущества MCP-подхода

Применение таких платформ дает бизнесу и разработчикам ряд неоспоримых достоинств, которые напрямую влияют на эффективность и стоимость сбора сведений.

- Высокая успешность запросов. Система автоматически ротирует IP-адреса из огромного пула (включая резидентные и мобильные прокси), подбирает правильные заголовки и решает CAPTCHA. Это обеспечивает близкий к 100% показатель успешного получения контента.

- Анонимность и безопасность. Все запросы идут через защищенную инфраструктуру, скрывая ваш реальный IP-адрес и защищая от возможных контрмер со стороны целевых ресурсов.

- Масштабируемость. Вы можете отправлять тысячи одновременных запросов без необходимости самостоятельно управлять парком серверов и прокси. Платформа сама распределяет нагрузку.

- Экономия ресурсов. Отпадает необходимость содержать штат специалистов для поддержки инфраструктуры парсинга. Вы платите только за успешные запросы, что делает затраты предсказуемыми.

- Обработка JavaScript. Платформа способна исполнять JavaScript на целевой странице, как это делает обычный браузер. Это позволяет извлекать сведения с самых сложных динамических сайтов.

Сферы применения: где это действительно полезно?

Практическая польза от таких систем раскрывается в множестве отраслей. В электронной коммерции это незаменимый инструмент для динамического ценообразования и анализа ассортимента конкурентов. В маркетинге он помогает проводить глубокий анализ SERP (поисковой выдачи) и отслеживать упоминания бренда. Финансовые аналитики используют его для сбора данных с новостных сайтов и биржевых порталов для прогнозирования рыночных движений. Даже в сфере HR автоматизированный сбор вакансий помогает анализировать рынок труда и формировать кадровый резерв.

Юридические и этические аспекты сбора информации

Автоматизация сбора информации должна проводиться ответственно. Важно всегда проверять файл `robots.txt` на целевом сайте, который содержит указания для поисковых роботов и парсеров. Также необходимо соблюдать условия использования ресурса (Terms of Service) и законодательство о защите персональных данных, такое как GDPR. Скрапинг должен затрагивать только общедоступную информацию и не создавать избыточную нагрузку на серверы целевого сайта.

Данные — это ценный ресурс, но их сбор должен всегда оставаться в рамках закона и этики, не нарушая конфиденциальность пользователей и правила веб-ресурсов.

В заключение, веб-скрапинг с mcp server — это мощный и эффективный инструмент, который демократизирует доступ к большим данным. Он снимает технические барьеры, позволяя компаниям любого размера получать ценную информацию для роста и развития. Правильное использование этой технологии открывает новые горизонты для аналитики, маркетинга и стратегического планирования.