Где найти датасет

Где найти датасет — фундаментальный вопрос, с которого начинается любой проект в области анализа информации, машинного обучения или научных исследований. Качество, релевантность и полнота исходных материалов напрямую определяют успех всей работы. Без подходящего набора сведений даже самый совершенный алгоритм окажется бесполезным. Этот гид поможет сориентироваться в многообразии ресурсов и выбрать оптимальный источник для ваших задач, будь то исследование рынка, обучение нейронной сети или статистический анализ.

Что такое набор данных и для чего он нужен?

Говоря простыми словами, датасет — это структурированная коллекция информации, объединенная общей тематикой. Он может представлять собой что угодно: от таблицы в формате Excel с продажами интернет-магазина до архива с миллионами изображений кошек для обучения модели компьютерного зрения. Цель любого такого набора — служить сырьем для извлечения знаний, проверки гипотез и создания новых продуктов.

Области применения практически безграничны. Рассмотрим несколько примеров:

- Бизнес-аналитика: Анализ покупательского поведения, прогнозирование спроса, сегментация клиентов.

- Машинное обучение: Обучение моделей для распознавания образов, обработки естественного языка (NLP), создания рекомендательных систем.

- Научные исследования: Изучение климатических изменений на основе метеорологических сводок, анализ генетических последовательностей.

- Социология: Исследование общественного мнения по результатам опросов.

Правильно подобранный набор сведений позволяет не просто строить теории, а принимать решения, основанные на фактах и закономерностях.

Ключевые критерии выбора источника

Прежде чем загружать первый попавшийся архив, стоит оценить его по нескольким параметрам. Это сэкономит массу времени на этапе предварительной обработки и очистки.

- Релевантность: Соответствует ли коллекция вашей задаче? Если вы хотите предсказать цену на недвижимость, вам нужна информация о площади, районе, количестве комнат, а не статистика футбольных матчей.

- Качество и полнота: Проверьте, много ли в наборе пропущенных значений, аномалий или ошибок. Неполные или «грязные» сведения могут исказить результаты анализа.

- Актуальность: Для многих задач важна свежесть информации. Экономические показатели за 2010 год вряд ли помогут спрогнозировать рынок в текущем году.

- Формат: Наиболее распространены форматы CSV, JSON, XML. Убедитесь, что у вас есть инструменты для работы с выбранным форматом. Для изображений, аудио или видео потребуются другие подходы.

- Лицензия: Очень важный аспект, особенно для коммерческих проектов. Убедитесь, что лицензия разрешает использование материала в ваших целях. Некоторые требуют указания авторства, другие запрещают коммерческое применение.

Неправильно выбранная лицензия может привести к юридическим проблемам в будущем. Всегда внимательно читайте условия использования, прежде чем интегрировать сведения в свой продукт.

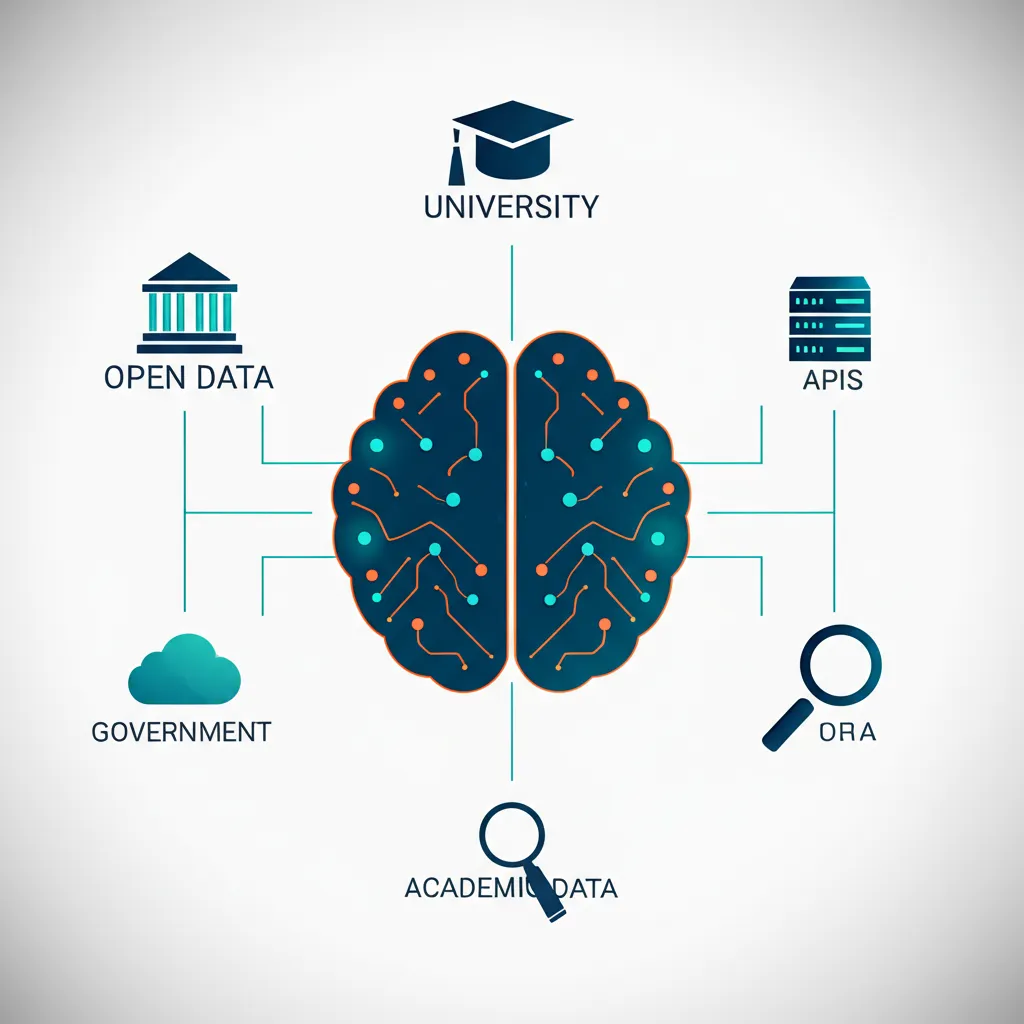

Государственные и международные порталы открытых данных

Многие правительства и международные организации по всему миру поддерживают политику открытости, публикуя огромные массивы неличной информации. Эти порталы — настоящий клад для аналитиков и исследователей.

- Data.gov: Портал открытой информации правительства США. Здесь можно найти сведения по экономике, здравоохранению, климату, сельскому хозяйству и многим другим сферам.

- European Union Open Data Portal: Центральная точка доступа к информации, публикуемой учреждениями и агентствами ЕС.

- The World Bank Open Data: Глобальные показатели развития, включая демографию, экономику, финансы, окружающую среду со всего мира.

- Портал открытых данных Российской Федерации (data.gov.ru): Агрегатор сведений от федеральных и региональных органов власти России.

Преимущество таких ресурсов — официальный статус и, как правило, высокая степень достоверности. Однако иногда они могут обновляться не так часто, как хотелось бы.

Академические и научные репозитории

Университеты и исследовательские центры являются генераторами огромного количества ценной информации. Многие из них делятся своими наработками с сообществом через специализированные хранилища.

- Kaggle Datasets: Одна из самых популярных платформ. Это не просто хранилище, а целая экосистема, где можно не только скачать коллекцию, но и изучить чужие блокноты с анализом, поучаствовать в обсуждениях и соревнованиях.

- Google Dataset Search: Специализированная поисковая система от Google, которая индексирует репозитории по всему интернету. Отличная отправная точка для любого поиска.

- UCI Machine Learning Repository: Один из старейших и самых уважаемых архивов. Здесь хранятся классические наборы, на которых тестировались многие известные алгоритмы машинного обучения.

- Hugging Face Datasets: Незаменимый ресурс для специалистов по NLP и работе с текстом. Предлагает тысячи готовых к использованию наборов с удобным API для загрузки.

Специализированные платформы и GitHub

Помимо крупных агрегаторов, существует множество нишевых ресурсов. Например, коллекции изображений для компьютерного зрения (ImageNet, COCO) или финансовые временные ряды (Quandl). Отдельного упоминания заслуживает GitHub.

На GitHub часто можно найти уникальные коллекции, собранные энтузиастами. Используйте поисковые запросы вроде "awesome public datasets", чтобы найти курируемые списки высококачественных ресурсов по самым разным темам.

GitHub хорош тем, что часто рядом с файлами лежит код для их сбора и обработки, что делает процесс работы более прозрачным.

Альтернативные методы: парсинг и API

Что делать, если готового набора не существует? В этом случае его можно создать самостоятельно. Есть два основных пути:

- API (Application Programming Interface): Многие веб-сервисы (социальные сети, новостные сайты, маркетплейсы) предоставляют структурированный доступ к своей информации через API. Это предпочтительный способ, так как он легален и технологически прост.

- Веб-скрапинг (парсинг): Программный сбор информации непосредственно с веб-страниц. Этот метод требует технических навыков и должен использоваться с осторожностью. Всегда проверяйте файл `robots.txt` сайта и его условия использования, чтобы не нарушить правила.

Создание собственного набора — трудоемкий процесс, но он дает полный контроль над содержанием и структурой. Это оправдано, когда требуется уникальная или очень специфическая информация.

Заключение: стратегия эффективного поиска

Эффективный поиск — это системный подход. Начните с четкого определения требований к информации. Затем проверьте крупные агрегаторы вроде Kaggle и Google Dataset Search. Если ничего подходящего не нашлось, переходите к государственным и академическим порталам. И только если все предыдущие шаги не дали результата, рассматривайте возможность сбора сведений самостоятельно. Такой подход сэкономит ваше время и поможет найти именно то, что нужно для вашего проекта.