Как разделить датасет на батчи с python

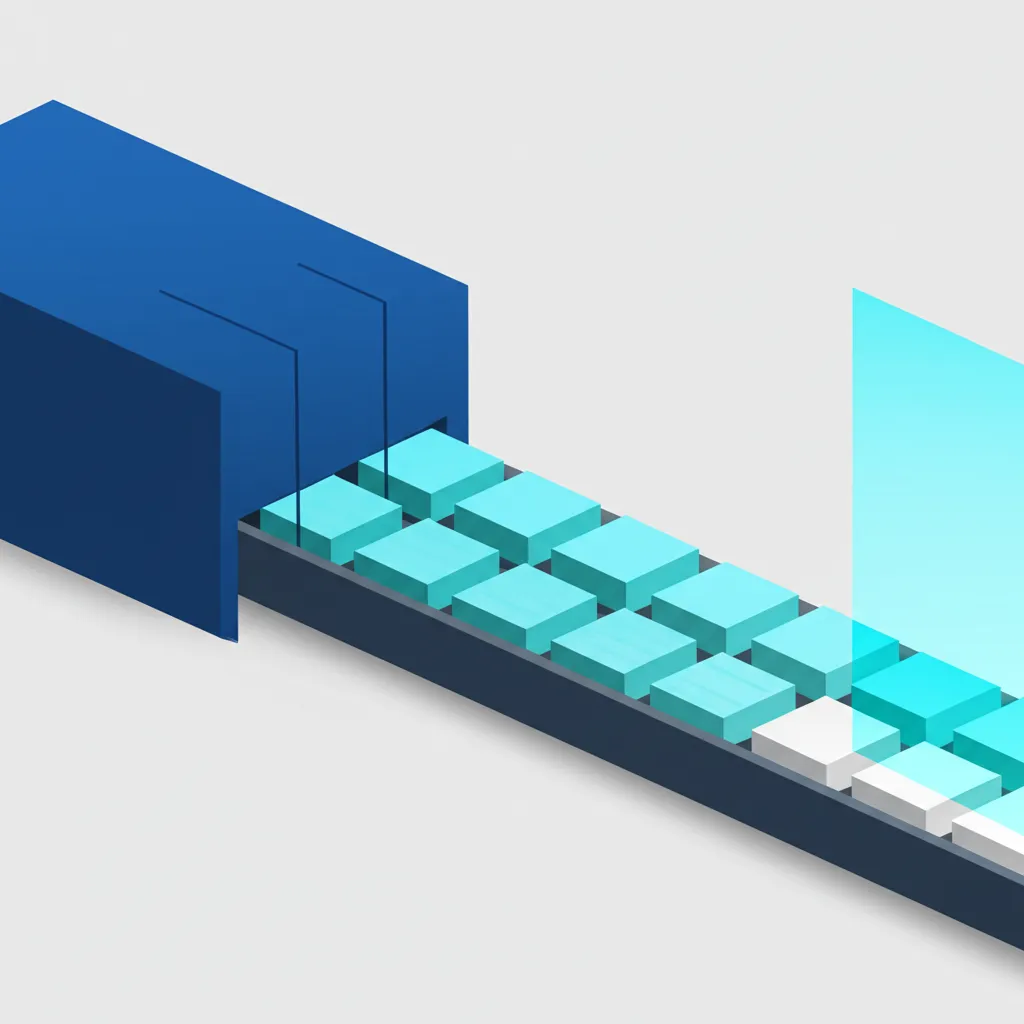

Разделить датасет на батчи с python — это фундаментальная задача при работе с большими объемами информации, особенно в машинном обучении. Пакетная обработка (batch processing) подразумевает разделение всего набора данных на небольшие, управляемые части, или пакеты. Вместо того чтобы загружать в память гигабайты информации целиком, мы обрабатываем ее порциями. Такой подход не только предотвращает сбои из-за нехватки оперативной памяти, но и значительно повышает производительность вычислений, делая процесс обучения нейронных сетей более стабильным и быстрым.

Зачем нужна пакетная обработка данных

Идея дробления больших массивов на части может показаться очевидной, но за ней стоят конкретные технические и алгоритмические преимущества. Понимание этих причин помогает более осознанно подходить к построению конвейеров обработки информации (data pipelines).

Эффективность использования памяти

Основная и самая очевидная причина — это ограничение оперативной памяти (RAM). Современные наборы данных могут достигать десятков или даже сотен гигабайт. Попытка загрузить такой объем в память целиком приведет к ошибке MemoryError и аварийному завершению программы. Разделение на батчи позволяет обрабатывать информацию последовательно, загружая в RAM только одну порцию за раз. Размер пакета подбирается таким образом, чтобы он комфортно помещался в доступной памяти, обеспечивая бесперебойную работу.

Скорость и качество обучения моделей

В машинном обучении, особенно в глубоком обучении, используется метод градиентного спуска для оптимизации параметров модели. Его вариации, такие как стохастический градиентный спуск (SGD) и его адаптивные версии (Adam, RMSprop), работают эффективнее с мини-батчами (mini-batches).

- Частые обновления весов: Обработка по одному элементу (стохастический спуск) вносит много шума в процесс обучения. Обработка всего набора (пакетный градиентный спуск) требует огромных вычислительных ресурсов для одного шага. Мини-пакеты — это золотая середина. Модель обновляет веса после каждой порции, что делает сходимость более быстрой и стабильной.

- Выход из локальных минимумов: Шум, вносимый при оценке градиента на небольшой выборке, помогает алгоритму «выпрыгивать» из локальных минимумов и находить более оптимальное решение.

Параллельные вычисления на GPU

Графические процессоры (GPU) спроектированы для выполнения множества однотипных операций одновременно. Их архитектура идеально подходит для матричных вычислений, которые лежат в основе работы нейронных сетей. Чтобы максимально загрузить GPU, необходимо передавать ему данные в виде пакетов (тензоров). Обработка элементов по одному не позволяет раскрыть весь потенциал параллелизма, в то время как правильно подобранный размер батча обеспечивает оптимальную загрузку вычислительных ядер и кратное ускорение процесса обучения.

Практические способы разделения датасета

Существует несколько подходов к реализации пакетной обработки в Python, от простых циклов до использования специализированных библиотек. Выбор метода зависит от структуры ваших данных и требований к производительности.

Простой подход с использованием циклов и срезов

Самый базовый способ, который не требует никаких внешних библиотек. Он отлично подходит для списков или других последовательностей. Идея заключается в итерации по индексам с определенным шагом, равным размеру пакета.

def split_into_batches(data, batch_size):

# Простой генератор для разделения данных

for i in range(0, len(data), batch_size):

yield data[i:i + batch_size]

# Пример использования

my_data = list(range(100)) # Исходные данные из 100 элементов

batch_size = 10

for batch in split_into_batches(my_data, batch_size):

print(f"Обработка пакета: {batch}")

Этот метод прост и понятен. Однако он создает копии частей списка (срезы), что может быть неэффективно для очень больших объемов информации.

Применение генераторов для оптимизации

Использование генераторов (с ключевым словом `yield`) является более элегантным и эффективным с точки зрения памяти решением. Генератор не создает все батчи сразу, а производит их «на лету», по мере необходимости. Приведенный выше пример уже использует этот подход. Это позволяет работать с практически бесконечными потоками информации, не беспокоясь о переполнении памяти.

Генераторы — это идиоматичный способ в Python для создания итераторов. Они идеально подходят для ленивых вычислений и обработки больших данных, так как вычисляют следующее значение только в момент запроса.

Использование возможностей библиотеки NumPy

Если вы работаете с числовыми данными, библиотека NumPy предоставляет мощные и оптимизированные инструменты. Для разделения массивов можно использовать функцию `np.array_split`.

import numpy as np

# Создаем массив NumPy

data_array = np.arange(105)

batch_size = 20

# Рассчитываем количество батчей

num_batches = int(np.ceil(len(data_array) / batch_size))

batches = np.array_split(data_array, num_batches)

for i, batch in enumerate(batches):

print(f"Пакет {i+1}: {batch}")

Функция `array_split` автоматически обрабатывает ситуацию, когда общее число элементов не делится нацело на размер пакета, делая последний батч меньше остальных. Операции в NumPy выполняются на низкоуровневом коде (C/Fortran), что обеспечивает максимальную производительность.

Дополнительные аспекты пакетной обработки

Просто разбить данные на части — это только полдела. Для качественного обучения моделей и построения надежных систем нужно учитывать еще несколько важных моментов.

Важность перемешивания данных (Shuffling)

Исходные данные часто бывают упорядочены по какому-либо признаку (например, по дате или классу). Если подавать такие упорядоченные порции в модель, она может «привыкнуть» к порядку и плохо обобщать результат на новых, случайных данных. Чтобы избежать этого, выборку необходимо тщательно перемешать перед каждой эпохой обучения.

- Перемешивание индексов: Создайте список индексов от 0 до N-1, где N — размер набора.

- Перемешайте этот список: Используйте, например, `np.random.permutation()`.

- Формируйте батчи: Используйте перемешанные индексы для доступа к элементам исходного набора.

Такой подход гарантирует, что каждый пакет будет содержать случайную и репрезентативную подвыборку из всего датасета.

Обработка последнего неполного батча

Когда общее количество элементов не делится нацело на размер пакета, последний батч будет меньше остальных. Здесь есть несколько стратегий:

- Оставить как есть: Самый простой вариант. Большинство алгоритмов нормально справятся с пакетом другого размера.

- Отбросить: Если потеря небольшого количества записей некритична, последний неполный пакет можно просто проигнорировать. Такой параметр `drop_last=True` есть во многих фреймворках.

- Дополнить (Padding): В некоторых задачах, например, при обработке последовательностей, все пакеты должны иметь одинаковый размер. В этом случае последний батч можно дополнить специальными значениями.

Интегрированные инструменты в ML-фреймворках

Современные библиотеки для машинного обучения, такие как TensorFlow и PyTorch, предоставляют высокоуровневые API для работы с данными, которые инкапсулируют всю логику пакетной обработки.

- TensorFlow: Модуль `tf.data` позволяет создавать сложные и производительные конвейеры данных. Класс `tf.data.Dataset` имеет методы `.batch()`, `.shuffle()`, `.prefetch()` и другие для эффективной подготовки информации.

- PyTorch: Классы `Dataset` и `DataLoader` являются стандартом для загрузки и обработки данных. `DataLoader` автоматически берет на себя разделение на батчи, перемешивание и даже параллельную загрузку с использованием нескольких процессорных ядер.

Использование встроенных инструментов предпочтительнее, поскольку они оптимизированы для работы с GPU и обеспечивают максимальную производительность без необходимости писать низкоуровневый код вручную. Это позволяет сосредоточиться на архитектуре модели, а не на инфраструктурных задачах.