Создать датасет для модели — это фундаментальный этап, определяющий успех всего проекта в области машинного обучения. Без качественных, релевантных и правильно структурированных сведений даже самый сложный алгоритм не сможет показать хороший результат. Представьте, что вы учите ребенка различать животных по картинкам. Если вы покажете ему только изображения кошек, он никогда не научится узнавать собак. Данные для нейросети — это её учебные материалы, её жизненный опыт. Процесс формирования такого набора информации требует внимания, methodicalности и понимания конечной цели. В этой статье мы разберем весь путь от идеи до готового к обучению набора.

Создать датасет для модели: пошаговый процесс

Формирование набора сведений для обучения алгоритма можно сравнить со строительством фундамента для дома. Любая ошибка на этом этапе может привести к тому, что вся конструкция окажется неустойчивой. Процесс состоит из нескольких логических шагов, каждый из которых важен для итогового качества.

Определение цели и требований к информации

Прежде чем приступать к сбору, необходимо четко ответить на вопрос: какую задачу будет решать ваша система? Ответ определяет тип, объем и формат требуемых материалов. Например:

- Классификация изображений: Нужны ли вам фотографии кошек и собак? Или требуется различать сотни пород? От этого зависит детализация и количество необходимых картинок.

- Анализ тональности текста: Потребуются текстовые отзывы (например, о товарах или фильмах) с метками «позитивный», «негативный», «нейтральный».

- Прогнозирование продаж: Понадобятся исторические сведения о продажах, ценах, рекламных акциях, сезонности и других факторах.

На этом этапе вы формируете «техническое задание» для будущего набора. Чем точнее вы опишете требования, тем проще будет на последующих этапах.

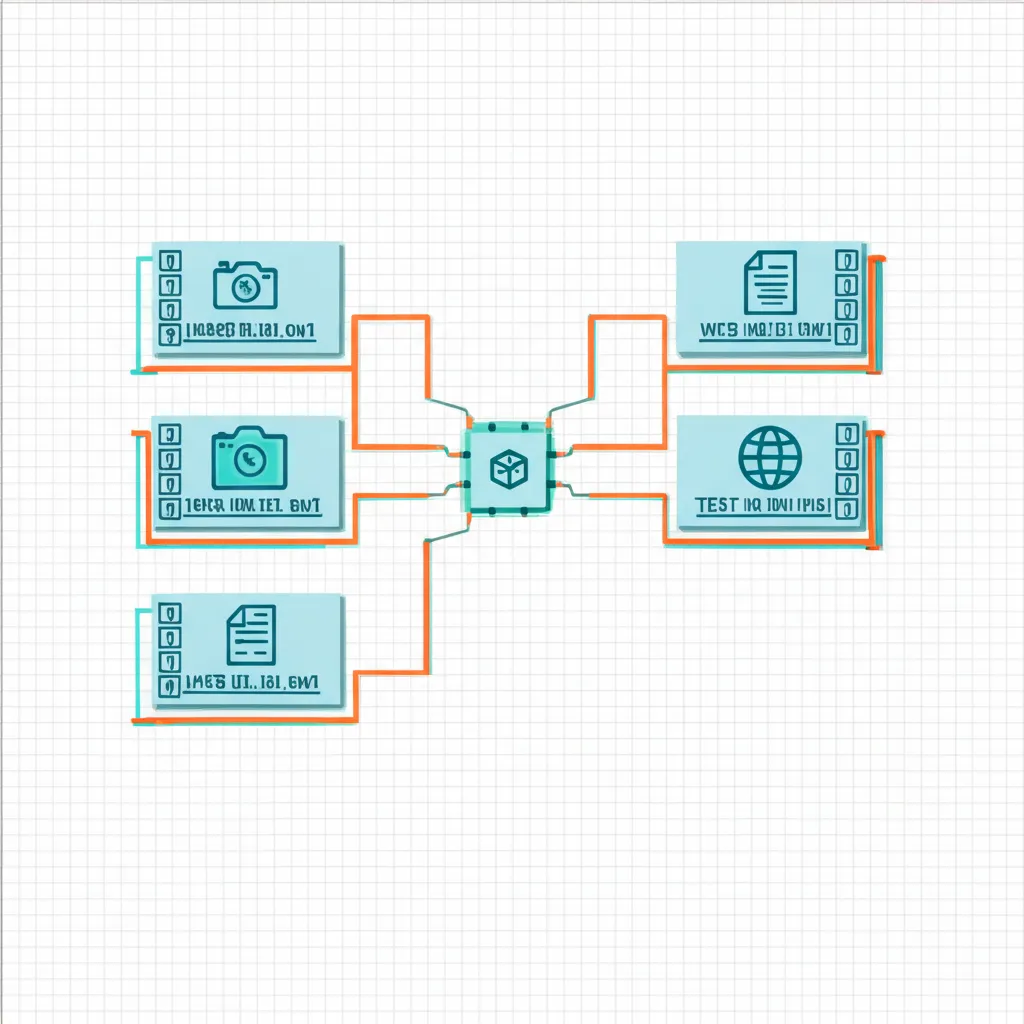

Сбор сырых материалов

Когда цель ясна, наступает время поиска и сбора исходной информации. Существует несколько основных подходов к этому процессу, и часто они комбинируются для достижения наилучшего результата.

- Открытые источники. В сети существует множество готовых наборов информации для различных задач, которые можно использовать бесплатно. Платформы вроде Kaggle, Google Dataset Search или репозитории университетов предлагают тысячи готовых решений. Это отличная отправная точка.

- Веб-скрапинг (парсинг). Если готовых наборов нет, сведения можно собрать с веб-сайтов. Например, спарсить изображения с фотостоков или отзывы с маркетплейсов. Здесь важно соблюдать политику сайтов и законодательство об авторском праве.

- Ручной сбор. Для уникальных задач информацию приходится собирать вручную. Это может быть фотографирование определенных объектов, запись аудио или проведение опросов. Этот метод наиболее трудоемкий, но обеспечивает полный контроль над качеством.

- Генерация синтетических данных. Иногда проще сгенерировать сведения искусственно. Этот подход часто используется в компьютерном зрении, где можно создавать 3D-модели объектов и рендерить их с разных ракурсов при разном освещении.

Очистка и предварительная обработка

Сырые сведения почти всегда «грязные». Они содержат ошибки, пропуски, дубликаты и аномалии. Этап очистки (препроцессинга) критически важен для подготовки качественного учебного материала.

Качество информации, а не сложность алгоритма, чаще всего определяет успех проекта в области машинного обучения.

Основные задачи на этом этапе включают:

- Удаление дубликатов. Одинаковые записи не несут новой информации и могут исказить результаты обучения.

- Обработка пропущенных значений. Пропуски можно заполнить средними или медианными значениями, предсказать с помощью другого алгоритма или просто удалить строки/столбцы с пропусками.

- Коррекция аномалий и выбросов. Значения, которые сильно выбиваются из общего распределения (например, возраст пользователя 150 лет), скорее всего, являются ошибками и требуют исправления.

- Приведение к единому формату. Все сведения должны быть унифицированы. Например, все даты должны иметь формат ГГГГ-ММ-ДД, а изображения — одинаковый размер и цветовую схему.

Разметка данных (аннотация)

Это процесс добавления к вашим сведениям целевых меток, которые и будет учиться предсказывать система. Без разметки компьютер не поймет, что от него требуется. Это самый трудоемкий и дорогостоящий этап при создании датасета для контролируемого обучения.

Примеры разметки:

- Для классификации: Каждому изображению присваивается метка класса («кошка», «собака»).

- Для детекции объектов: Вокруг каждого объекта на изображении рисуется ограничительная рамка (bounding box) и ей присваивается метка класса.

- Для семантической сегментации: Каждый пиксель изображения окрашивается в цвет, соответствующий классу объекта, к которому он принадлежит.

Разметку можно выполнять вручную с помощью специальных инструментов или привлекать краудсорсинговые платформы. Главное здесь — разработать четкую инструкцию для разметчиков, чтобы минимизировать количество ошибок и субъективных оценок.

Аугментация и разделение выборки

Когда набор очищен и размечен, его часто полезно искусственно расширить (аугментировать). Это помогает нейросети лучше обобщать и становиться более устойчивой к изменениям. Для изображений аугментация может включать повороты, отражения, изменение яркости и контрастности. Для текста — замену слов синонимами.

Финальный шаг — разделение всего набора на три части:

- Обучающая выборка (Training set). Самая большая часть (обычно 70-80%). На ней алгоритм непосредственно учится.

- Валидационная выборка (Validation set). Около 10-15% набора. Используется для настройки гиперпараметров алгоритма в процессе обучения.

- Тестовая выборка (Test set). Оставшиеся 10-15%. Эта часть «прячется» от системы до самого конца и используется только один раз для финальной, объективной оценки качества её работы.

Правильное разделение гарантирует, что вы сможете адекватно оценить, насколько хорошо ваша система справится с новыми, ранее не виданными сведениями.