Кью парсер как инструмент для глубокого анализа аудитории

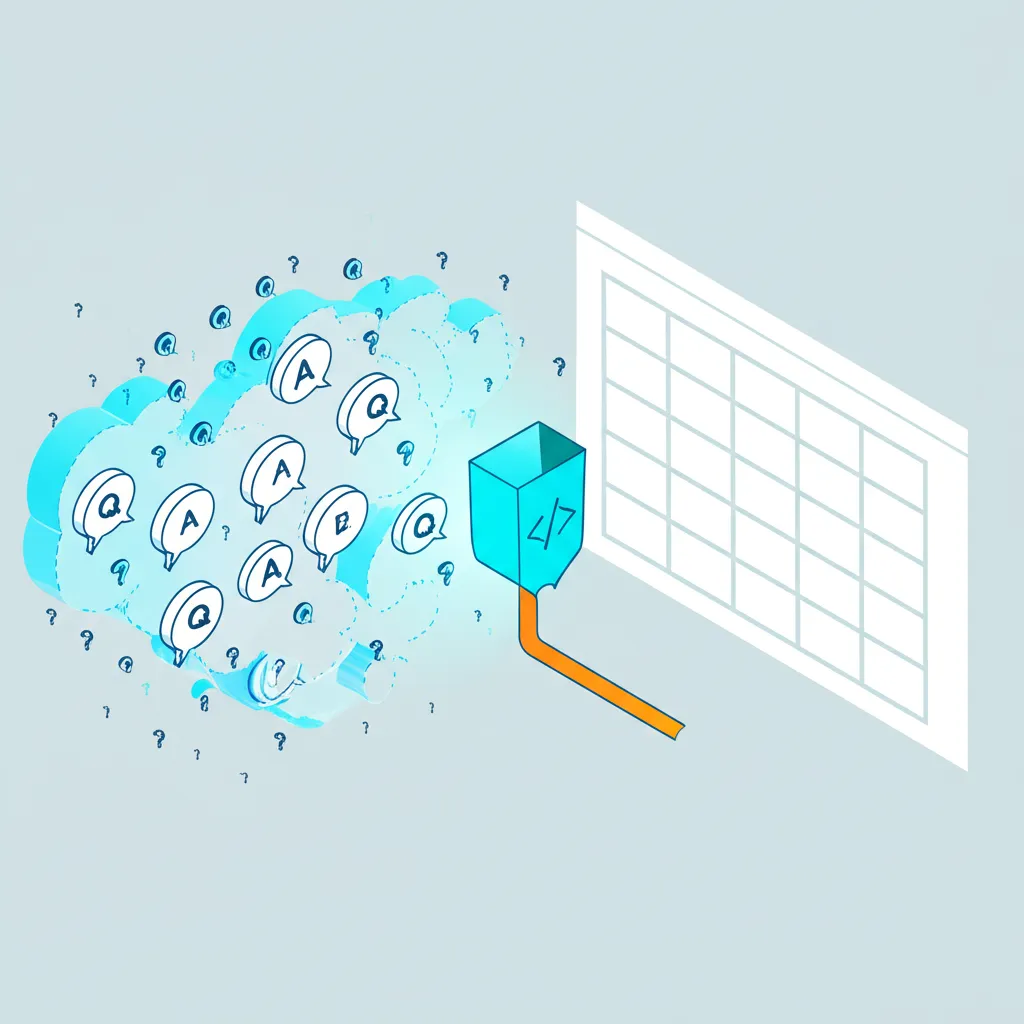

Кью парсер — это специализированная программа или скрипт, предназначенный для автоматического сбора общедоступной информации с сайтов формата «Вопросы и ответы» (Q&A). Представьте, что вам нужно вручную скопировать тысячи обсуждений с какого-либо ресурса, чтобы понять, о чем говорят ваши потенциальные клиенты. Этот процесс занял бы недели, а программа выполняет его за часы. Она методично обходит страницы, извлекает тексты вопросов, содержание ответов, данные об авторах, количество просмотров и другую полезную информацию, после чего сохраняет ее в структурированном виде, например, в таблице Excel или базе данных. Это позволяет маркетологам, аналитикам и владельцам бизнеса получать ценные инсайты прямо из первоисточника — из живых диалогов реальных людей.

Принципы работы: от запроса до структурированных сведений

Механизм работы такого инструмента основан на имитации действий пользователя, но в автоматическом режиме. Процесс можно разбить на несколько ключевых этапов, которые позволяют превратить хаотичный веб-контент в упорядоченный массив для исследования.

- Определение цели и настройка. Сначала пользователь задает параметры сбора: какие ключевые слова искать в обсуждениях, с какого раздела сайта начинать, как глубоко сканировать форум. Например, можно настроить поиск всех тем, где упоминается «выбор CRM-системы».

- Отправка HTTP-запросов. Программа отправляет запросы к серверу сайта, получая в ответ HTML-код страниц. Это то же самое, что делает ваш браузер, когда вы открываете веб-страницу.

- Извлечение контента (парсинг). На этом этапе происходит самое главное. Скрипт анализирует полученный HTML-код, находит в нем нужные блоки по определенным тегам и классам (например, `div` с классом `question-title` или `p` с классом `answer-body`) и «вытаскивает» из них текстовое содержимое.

- Обработка и сохранение. Полученные сведения очищаются от лишних HTML-тегов, пробелов и форматируются. Затем они сохраняются в удобный для дальнейшего использования формат: CSV, JSON или напрямую в базу данных. В результате у вас появляется таблица, где каждый ряд — это отдельный вопрос, а столбцы — его атрибуты.

Практическое применение для бизнеса и маркетинга

Возможности, которые открывает автоматизированный сбор информации с Q&A-платформ, весьма обширны. Это не просто техническая задача, а стратегический ресурс для принятия взвешенных решений. Вот несколько направлений, где парсинг приносит ощутимую пользу.

- Исследование потребительских болей. Анализируя вопросы пользователей, можно точно определить, с какими проблемами они сталкиваются. Сервисный центр по ремонту техники может выяснить, какие модели устройств ломаются чаще всего и по каким причинам.

- Поиск идей для контент-плана. Популярные и оставшиеся без качественного ответа темы — это золотая жила для создания полезных статей, видео или постов в блог, которые будут востребованы аудиторией.

- Мониторинг репутации бренда (ORM). Настроив отслеживание упоминаний своей компании или продуктов, можно оперативно реагировать на негативные отзывы и поддерживать положительный имидж.

- Анализ стратегий конкурентов. Можно изучить, на какие вопросы отвечают представители конкурирующих фирм, как они работают с возражениями и какие преимущества своих продуктов подсвечивают.

- Генерация SEO-семантики. Формулировки, которые люди используют в своих запросах, являются готовыми низкочастотными и среднечастотными ключевыми фразами для поисковой оптимизации сайта.

«Данные, полученные напрямую из обсуждений пользователей, — это самый честный и нефильтрованный источник информации о рынке. Никакие фокус-группы не дадут такого масштаба и такой искренности. Главное — правильно их собрать и интерпретировать».

Кью парсер: выбор подходящего решения

Когда возникает потребность в автоматизации сбора сведений, компания сталкивается с выбором одного из нескольких путей. Каждый из них имеет свои преимущества и недостатки, и оптимальный вариант зависит от технических навыков команды, бюджета и масштаба задач.

Готовые облачные сервисы и десктопные программы

На рынке существует множество готовых решений, которые предлагают интуитивно понятный интерфейс и не требуют навыков программирования. Пользователь просто вводит адрес сайта, ключевые слова и получает готовый файл с результатом.

Плюсы: простота использования, быстрая настройка, техническая поддержка.

Минусы: ежемесячная абонентская плата, ограниченная гибкость (не всегда можно настроить под нестандартный сайт), зависимость от разработчика сервиса.

Разработка собственного скрипта

Команды с собственным штатом разработчиков или достаточными техническими компетенциями могут создать парсер самостоятельно. Чаще всего для этих целей используют язык программирования Python и его библиотеки, такие как Scrapy или BeautifulSoup.

Плюсы: полная гибкость и контроль над процессом, отсутствие абонентской платы, возможность интеграции с внутренними системами компании.

Минусы: требует значительных временных и ресурсных затрат на разработку и поддержку, необходимость обходить защиту от ботов (CAPTCHA, блокировка по IP).

Юридические и этические нюансы

Приступая к сбору информации, необходимо помнить об этической стороне вопроса. Важно придерживаться нескольких правил, чтобы не нарушать законодательство и правила самих веб-ресурсов.

- Изучите файл `robots.txt` сайта-источника. В нем вебмастера указывают, какие разделы сайта запрещено сканировать автоматическим программам. Игнорирование этих правил может привести к блокировке вашего IP-адреса.

- Не создавайте чрезмерную нагрузку на сервер. Слишком частые запросы могут замедлить или даже «положить» сайт. Ответственные разработчики всегда делают паузы между запросами.

- Используйте только общедоступную информацию. Категорически запрещено парсить личные сведения, скрытые за авторизацией, если на это нет разрешения пользователя. Цель — анализ массовых трендов, а не сбор приватной информации.

«Хороший парсер — это не тот, который может обойти любую защиту, а тот, который работает эффективно, уважая при этом инфраструктуру источника и конфиденциальность его пользователей».

В конечном счете, кью парсер — это мощный аналитический инструмент. Он позволяет превратить миллионы разрозненных пользовательских реплик в структурированные сведения, на основе которых можно строить маркетинговые стратегии, улучшать продукты и лучше понимать свою аудиторию. Правильное его применение дает неоспоримое конкурентное преимущество в любой нише, где важен голос клиента.