Краулинг картинок/скриншотов из галерей, image scraping

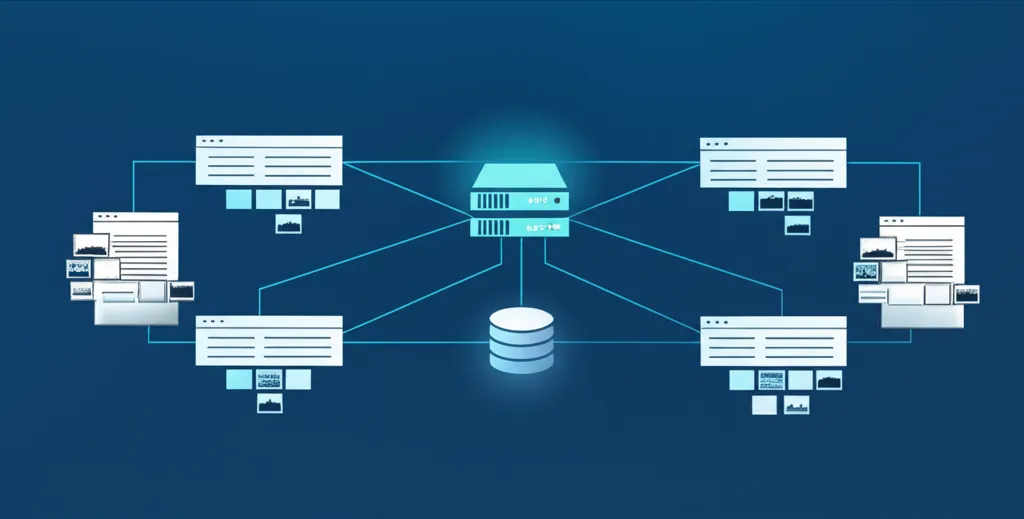

Краулинг картинок/скриншотов из галерей, image scraping — это процесс автоматизированного сбора изображений с веб-сайтов. Специальные программы, называемые скрейперами или парсерами, обходят страницы, находят графический контент и сохраняют его для дальнейшего использования. Этот метод позволяет собирать большие объемы визуальных данных для анализа, обучения моделей машинного обучения, мониторинга конкурентов в электронной коммерции или агрегации контента. Технология лежит на стыке программирования, анализа данных и автоматизации, открывая широкие возможности для бизнеса и исследований.

Что представляет собой сбор визуальных данных?

По своей сути, скрейпинг — это имитация действий человека, который вручную просматривает сайт и сохраняет нужные фотографии. Однако программа делает это в тысячи раз быстрее и эффективнее. Процесс не ограничивается простым скачиванием; он может включать извлечение сопутствующей информации (метаданных), такой как описание, дата загрузки или авторство. Автоматизация сбора позволяет обрабатывать целые каталоги товаров, фотобанки или социальные сети, получая структурированные наборы данных, которые невозможно собрать вручную в разумные сроки. Это мощный инструмент для тех, кому для работы необходимы большие массивы визуальной информации.

Как устроен процесс извлечения изображений

Технически, сбор графики с веб-ресурсов состоит из нескольких последовательных этапов. Каждый шаг требует определенных инструментов и подходов, которые зависят от сложности целевого сайта.

- Отправка запроса и получение HTML-кода. Скрейпер отправляет HTTP-запрос к целевой веб-странице, как это делает обычный браузер. В ответ сервер присылает HTML-код, который содержит всю структуру и контент страницы.

- Парсинг (анализ) HTML. Полученный код анализируется для поиска элементов, содержащих изображения. Чаще всего это теги

<img>, но картинки могут быть также заданы как фоновые изображения в CSS или загружаться динамически с помощью JavaScript. - Идентификация и извлечение ссылок. Из найденных тегов программа извлекает URL-адреса, ведущие непосредственно к файлам изображений. На этом этапе важно обрабатывать как относительные (например,

/images/photo.jpg), так и абсолютные ссылки (https://example.com/images/photo.jpg). - Загрузка и сохранение файлов. Получив прямые ссылки, скрейпер отправляет по ним новые запросы, скачивает графические файлы (JPEG, PNG, WEBP и др.) и сохраняет их на локальный диск или в облачное хранилище. Процесс можно настроить для присвоения файлам осмысленных имен, например, на основе артикула товара или ID публикации.

Ключевые инструменты и технологии

Для реализации задач по сбору визуального контента существует множество программных решений. Выбор зависит от языка программирования и специфики проекта. Наиболее популярными являются инструменты на базе Python и JavaScript.

- Python: Считается стандартом в области веб-скрейпинга благодаря богатому набору библиотек.

Requestsиспользуется для отправки HTTP-запросов,Beautiful Soupиlxml— для парсинга HTML, аScrapyпредставляет собой мощный фреймворк для создания сложных и быстрых краулеров. Для сайтов с динамической подгрузкой контента применяетсяSelenium, который управляет реальным браузером. - JavaScript (Node.js): Также набирает популярность. Библиотеки

Axiosилиnode-fetchслужат для выполнения запросов,Cheerioявляется быстрым и удобным парсером, синтаксически похожим на jQuery. Для сложных задач, требующих взаимодействия с JavaScript на странице, используютсяPuppeteerилиPlaywright, которые предоставляют полный контроль над браузером Chrome или Firefox.

Сферы практического применения

Автоматизированный сбор графики находит применение в самых разных областях, от маркетинга до научных исследований.

В электронной коммерции ритейлеры используют image scraping для мониторинга ассортимента и цен конкурентов. Сбор фотографий товаров помогает анализировать, как другие игроки рынка представляют свою продукцию, какие ракурсы используют, и на основе этого оптимизировать собственные карточки товаров. Также это позволяет быстро наполнять новые маркетплейсы контентом от поставщиков.

Для машинного обучения (ML) и искусственного интеллекта (AI) огромные наборы изображений (датасеты) являются основой для обучения нейронных сетей. Скрейпинг помогает собирать тысячи и миллионы картинок для тренировки моделей распознавания объектов, классификации изображений или генерации визуального контента.

В маркетинге и аналитике сбор скриншотов и графики из социальных сетей или рекламных кабинетов позволяет анализировать визуальные тренды, отслеживать креативы конкурентов и оценивать эффективность рекламных кампаний. Это помогает понять, какой визуальный язык находит лучший отклик у целевой аудитории.

Сбор данных — это не только техническая задача, но и большая ответственность. Всегда относитесь с уважением к ресурсам, с которых вы собираете информацию, и соблюдайте установленные ими правила.

Правовые и этические аспекты: что нужно знать

Прежде чем приступать к сбору данных, необходимо ознакомиться с юридической и этической стороной вопроса. Не все данные можно свободно собирать и использовать.

Во-первых, проверьте файл robots.txt на целевом сайте. В нем владельцы ресурса указывают, какие разделы сайта разрешено, а какие запрещено индексировать поисковым роботам и краулерам. Игнорирование этих правил является нарушением сетевого этикета.

Во-вторых, внимательно изучите Пользовательское соглашение (Terms of Service) сайта. Многие ресурсы прямо запрещают автоматизированный сбор данных. Нарушение этих условий может привести к блокировке вашего IP-адреса или даже к юридическим последствиям.

Третий важный аспект — авторское право. Большинство изображений в интернете защищены авторским правом. Их сбор для личного некоммерческого использования (например, для научного исследования) может быть допустим, но коммерческое использование без разрешения правообладателя является незаконным. Всегда проверяйте лицензию на контент.

Наконец, будьте "вежливым" парсером: не создавайте чрезмерную нагрузку на сервер. Делайте паузы между запросами (rate limiting) и представляйтесь в заголовке User-Agent, чтобы администрация сайта могла при необходимости с вами связаться.

Основные трудности и пути их решения

На практике краулинг картинок сопряжен с рядом технических сложностей.

- Динамический контент: Многие современные сайты подгружают изображения по мере прокрутки страницы (lazy loading) или с помощью JavaScript после ее первоначальной загрузки. Простые скрейперы, работающие только с исходным HTML, такой контент не увидят. Решением является использование инструментов, управляющих браузером, таких как Selenium или Puppeteer.

- Защита от скрейпинга: Сайты часто используют системы защиты, например, CAPTCHA или блокировку по IP-адресу при обнаружении подозрительной активности. Для обхода таких мер могут потребоваться сервисы ротации прокси-серверов и решения для автоматического распознавания капчи.

- Сложная структура: Изображения могут быть встроены в CSS (как

background-image) или находиться внутри сложных JavaScript-фреймворков. Это требует более глубокого анализа кода страницы и иногда даже обратного инжиниринга клиентской логики.

Краулинг картинок — это мощная технология, которая при ответственном подходе становится эффективным инструментом для решения широкого круга задач. Понимание как технических, так и этических аспектов процесса является ключом к его успешному и безопасному применению.