Лучшие инструменты для больших данных

Лучшие инструменты для больших данных — это не просто программы, а целые экосистемы, которые позволяют компаниям извлекать ценность из колоссальных информационных массивов. Когда объемы сведений превышают возможности традиционных баз и приложений, на помощь приходят специализированные технологии. Выбор подходящего решения определяет, сможет ли бизнес превратить гигабайты и терабайты сырой информации в стратегическое преимущество, оптимизировать процессы и находить новые точки роста. Разобраться в многообразии платформ бывает непросто, но понимание их ключевых функций и отличий является первым шагом к успешному внедрению.

Что скрывается за термином Big Data?

Прежде чем погружаться в мир программного обеспечения, стоит кратко определить само понятие. Big Data обычно описывают через модель «Трех V»:

- Volume (Объем). Речь идет об огромном количестве информации, измеряемой в терабайтах, петабайтах и даже эксабайтах. Это могут быть данные с миллионов сенсоров, транзакции в интернет-магазине или пользовательская активность в социальной сети.

- Velocity (Скорость). Информация поступает и требует обработки в реальном времени или с минимальной задержкой. Примером служат потоковые сведения с фондовых бирж или геолокационные сигналы от мобильных устройств.

- Variety (Многообразие). Сведения поступают в разных форматах: структурированные (числа в таблицах), полуструктурированные (JSON, XML файлы) и неструктурированные (тексты, видео, аудио, изображения).

Традиционные системы управления базами данных (СУБД) не справляются с такими характеристиками. Им на смену пришли распределенные системы, способные параллельно выполнять вычисления на десятках, сотнях или тысячах серверов.

Экосистема Hadoop: фундаментальная основа

Говоря о Big Data, нельзя не упомянуть Apache Hadoop. Долгое время эта экосистема была синонимом всей индустрии. Она состоит из двух ключевых компонентов, которые изменили подход к хранению и вычислениям:

- HDFS (Hadoop Distributed File System). Это распределенная файловая система, которая позволяет хранить огромные файлы, разбивая их на блоки и распределяя по множеству компьютеров (узлов кластера). Такой подход обеспечивает отказоустойчивость: если один узел выходит из строя, его копия остается доступной на других.

- MapReduce. Это модель программирования для параллельной обработки масштабных наборов информации. Процесс можно сравнить с работой в большой библиотеке. Задача «Map» — это когда множество библиотекарей одновременно просматривают полки и отбирают книги по определенному критерию. Задача «Reduce» — когда главный библиотекарь собирает все отобранные книги и формирует из них итоговый отчет.

Хотя сегодня MapReduce частично уступил место более быстрым технологиям, Hadoop и HDFS остаются важной частью многих корпоративных инфраструктур, особенно для пакетной обработки архивных сведений.

Apache Spark: революция скорости и универсальности

Apache Spark появился как более быстрая и гибкая альтернатива Hadoop MapReduce. Его главное преимущество — обработка информации в оперативной памяти (in-memory), что в десятки, а иногда и в сотни раз ускоряет вычисления. Spark не заменяет HDFS, а эффективно работает поверх него и других систем хранения.

Ключевые модули Spark делают его универсальным решением:

- Spark Core: ядро, предоставляющее основные функции распределенных вычислений.

- Spark SQL: позволяет выполнять SQL-запросы к распределенным данным, что упрощает работу для аналитиков, привыкших к реляционным базам.

- Spark Streaming: обеспечивает обработку потоковых сведений в режиме, близком к реальному времени.

- MLlib: библиотека машинного обучения с готовыми алгоритмами для классификации, регрессии и кластеризации.

Благодаря своей скорости и многофункциональности, Spark стал стандартом де-факто для сложных аналитических задач и проектов машинного обучения.

Проект в области больших данных — это не только о технологиях; это об умении задавать правильные вопросы. Лучшее решение — то, которое помогает находить ответы наиболее эффективно.

NoSQL базы данных: гибкость для разнообразной информации

Не вся информация укладывается в строгие таблицы с заранее определенными колонками. Для работы с неструктурированными и полуструктурированными сведениями, такими как посты в соцсетях, каталоги товаров или профили пользователей, были созданы NoSQL («не только SQL») базы. Они предлагают гибкую схему и отличную горизонтальную масштабируемость.

Среди популярных NoSQL-решений выделяют несколько типов:

- Документо-ориентированные (MongoDB): хранят информацию в виде JSON-подобных документов. Идеально подходят для веб-приложений и управления контентом.

- Колоночные (Apache Cassandra): оптимизированы для быстрой записи и чтения по колонкам, а не по строкам. Используются в системах, требующих высокой доступности и отказоустойчивости, например, в IoT-платформах.

- Ключ-значение (Redis): простейший тип, где каждому уникальному ключу соответствует определенное значение. Часто применяется для кэширования и управления сессиями.

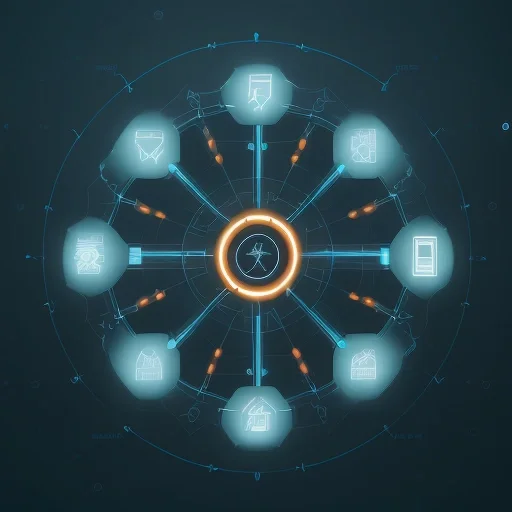

Обработка потоков в реальном времени с Apache Kafka

Многие современные системы должны реагировать на события мгновенно. Apache Kafka — это распределенная платформа для потоковой передачи событий. Ее можно представить как центральную «нервную систему» компании, по которой в реальном времени передаются сообщения от одних приложений (продюсеров) к другим (консьюмерам). Например, клики на сайте, финансовые транзакции или показания датчиков. Kafka гарантирует надежную доставку сообщений и позволяет обрабатывать миллионы событий в секунду.

Визуализация: превращаем цифры в понятные истории

Собрать и обработать информацию — это лишь половина дела. Чтобы результаты анализа были полезны для принятия бизнес-решений, их нужно представить в наглядном и понятном виде. Для этого существуют BI-системы (Business Intelligence) и платформы визуализации.

- Tableau: один из лидеров рынка, известный своим интуитивно понятным интерфейсом drag-and-drop. Позволяет быстро создавать интерактивные дашборды и графики, подключаясь к десяткам источников.

- Microsoft Power BI: мощное решение, тесно интегрированное с другими продуктами Microsoft (Excel, Azure). Предлагает широкие возможности по моделированию и визуализации, доступные даже для нетехнических специалистов.

Эти продукты демократизируют доступ к аналитике, позволяя менеджерам и маркетологам самостоятельно исследовать сведения и находить инсайты.

Облачные платформы: всё в одном

Создание и поддержка собственной инфраструктуры для Big Data — сложная и дорогостоящая задача. Облачные провайдеры, такие как Amazon Web Services (AWS), Google Cloud Platform (GCP) и Microsoft Azure, предлагают готовые управляемые сервисы для всех этапов работы.

Преимущества облачных платформ:

- Масштабируемость: можно легко увеличить или уменьшить вычислительные мощности в зависимости от нагрузки.

- Экономичность: модель оплаты по мере использования (pay-as-you-go) избавляет от капитальных затрат на оборудование.

- Интеграция: сервисы хранения (Amazon S3, Google Cloud Storage), обработки (AWS EMR, Google Dataproc) и анализа (Google BigQuery, Azure Synapse) тесно связаны друг с другом.

Для большинства компаний, особенно для стартапов и среднего бизнеса, облачные решения являются оптимальным выбором, позволяющим быстро запустить проекты без серьезных первоначальных инвестиций.

Как выбрать подходящую технологию?

Не существует одного «лучшего» инструмента для всех. Выбор зависит от конкретных задач, бюджета и экспертизы команды. При принятии решения стоит ответить на несколько вопросов:

- Каковы цели проекта? Требуется ли пакетная обработка исторических архивов, аналитика в реальном времени или запуск моделей машинного обучения?

- Какой тип информации преобладает? Структурированные таблицы, текстовые логи, видеофайлы?

- Каков бюджет и ресурсы? Есть ли команда DevOps для поддержки собственного кластера или лучше использовать управляемые облачные сервисы?

- Требуемая скорость обработки? Нужны ли результаты через несколько часов или миллисекунд?

Часто наиболее эффективной является гибридная архитектура, где разные технологии используются для решения тех задач, для которых они лучше всего подходят. Например, Kafka для сбора потоков, Spark для их обработки и Tableau для финальной визуализации.