Лучшие инструменты для работы с большими данными

Сегодня лучшие инструменты для работы с большими данными — это не просто программы, а целые экосистемы, которые позволяют компаниям извлекать ценность из огромных информационных массивов. Когда объемы сведений превышают возможности традиционных баз и приложений, на помощь приходят специализированные технологии. Речь идет о петабайтах информации, поступающей с невероятной скоростью из разных источников: социальных сетей, сенсоров, логов серверов. Давайте разберемся, какие решения существуют для управления этим потоком и как выбрать подходящее для ваших задач.

Почему стандартные подходы не работают?

Представьте, что вам нужно найти одну книгу в небольшой районной библиотеке. Это простая задача. А теперь вообразите, что вам нужно найти все книги о драконах во всех библиотеках мира одновременно. Обычный подход не сработает. Big Data — это та самая «мировая библиотека». Традиционные системы не справляются по трем причинам, известным как «три V»:

- Volume (Объем): Количество информации слишком велико для одного сервера.

- Velocity (Скорость): Сведения поступают непрерывно и требуют обработки в реальном времени.

- Variety (Многообразие): Информация разнородна — это могут быть тексты, изображения, видео, структурированные таблицы, геоданные.

Именно для решения этих проблем и были созданы специализированные платформы и программные средства.

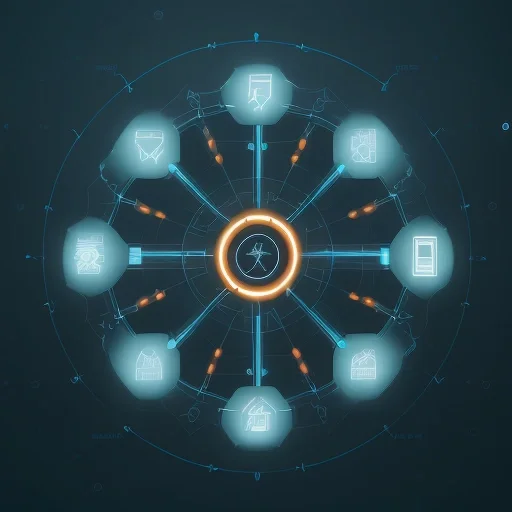

Ключевые инструменты для работы с большими данными и их классификация

Весь стек технологий для Big Data можно условно разделить на несколько уровней, каждый из которых выполняет свою функцию. Не существует одного универсального решения, которое бы закрывало все потребности. Обычно компании выстраивают конвейер (pipeline) из нескольких взаимосвязанных компонентов.

1. Системы хранения: фундамент для информации

Первая задача — надежно и эффективно сохранить гигантские объемы сведений. Здесь на помощь приходят распределенные файловые системы и облачные хранилища.

Apache Hadoop HDFS

Hadoop Distributed File System (HDFS) — это, по сути, стандарт в мире Big Data. Ее основная идея — хранить файлы не на одном мощном сервере, а распределять их по множеству более дешевых машин (кластеру). Если один из компьютеров выйдет из строя, информация не потеряется, так как система автоматически создает копии. HDFS идеально подходит для хранения очень больших файлов и последовательного доступа к ним.

Облачные хранилища: Amazon S3, Google Cloud Storage

Облачные решения, такие как Amazon S3 или GCS, стали популярной альтернативой HDFS. Их главное преимущество — эластичность и экономичность. Вам не нужно закупать и обслуживать собственное оборудование. Вы платите только за тот объем, который используете, и можете масштабировать его практически мгновенно. Эти сервисы прекрасно интегрируются с другими облачными платформами для обработки и анализа.

2. Платформы для вычислений: мозг операции

После того как сведения сохранены, их нужно обработать: отфильтровать, агрегировать, трансформировать. Для этого существуют мощные вычислительные движки.

Apache Spark

Spark — это швейцарский нож в мире обработки информации. Он невероятно быстр благодаря тому, что выполняет вычисления в оперативной памяти, а не на дисках, как его предшественники. Spark универсален и поддерживает разные задачи:

- Пакетная обработка: анализ накопленных исторических сведений.

- Обработка в реальном времени: анализ потоковых данных (например, кликов на сайте).

- Машинное обучение: содержит встроенные библиотеки для создания предиктивных моделей.

- Работа с графами: анализ связей между объектами, например, в социальных сетях.

Благодаря своей скорости и гибкости Spark стал де-факто стандартом для сложных вычислений.

Распределенные вычисления — это не о том, чтобы одна машина работала усерднее, а о том, чтобы тысячи машин работали вместе, каждая выполняя свою небольшую часть общей задачи.

Apache Hadoop MapReduce

MapReduce — это оригинальная модель вычислений, предложенная Google и реализованная в Hadoop. Концепция проста: задача делится на множество мелких подзадач (этап Map), которые параллельно выполняются на разных узлах кластера. Затем результаты этих подзадач собираются и объединяются в итоговый ответ (этап Reduce). Хотя Spark во многом вытеснил MapReduce из-за своей скорости, понимание принципов MapReduce остается важным для освоения основ Big Data.

3. Анализ и визуализация: превращаем цифры в инсайты

Конечная цель всей работы — получить полезные знания. На этом этапе в игру вступают средства для анализа и визуализации.

Tableau и Power BI

Эти системы бизнес-аналитики (BI) позволяют подключаться к различным источникам, включая хранилища Big Data, и создавать интерактивные отчеты и дашборды. Их сила в простоте. Пользователь без навыков программирования может строить сложные графики, диаграммы и карты, просто перетаскивая элементы мышкой. Это помогает быстро находить закономерности и делиться результатами с командой.

Jupyter Notebooks

Для более глубокого исследовательского анализа специалисты по данным (Data Scientists) часто используют Jupyter Notebooks. Это интерактивная среда, где можно писать код (обычно на Python или R), выполнять его и сразу видеть результат в виде таблиц, графиков или текста. Jupyter позволяет комбинировать код, визуализации и описания в одном документе, что делает его идеальным средством для экспериментов и прототипирования моделей машинного обучения.

Как выбрать оптимальный стек технологий?

Выбор конкретных решений зависит от множества факторов. Не стоит гнаться за самой модной технологией. Вместо этого ответьте на несколько вопросов:

- Каковы ваши цели? Вы хотите анализировать поведение клиентов, оптимизировать логистику или предсказывать сбои оборудования?

- Какой объем и тип информации у вас есть? Работаете ли вы с текстами, видео или структурированными таблицами?

- Насколько важна скорость? Вам нужны отчеты раз в день или анализ в реальном времени?

- Каковы технические навыки вашей команды? Есть ли у вас инженеры, способные настроить сложный кластер, или лучше использовать готовые облачные сервисы?

- Какой у вас бюджет? Готовы ли вы инвестировать в собственную инфраструктуру или предпочитаете модель операционных расходов в облаке?

Современный подход заключается в построении гибкой архитектуры, часто с использованием облачных сервисов, которые позволяют легко комбинировать различные технологии. Например, можно хранить сырые сведения в Amazon S3, обрабатывать их с помощью Apache Spark на кластере EMR и визуализировать результаты в Tableau. Такой подход обеспечивает масштабируемость и позволяет сосредоточиться на анализе, а не на поддержке инфраструктуры.