Мета-парсинг: автогенерация карт сайта, автоматизация краулинговых задач

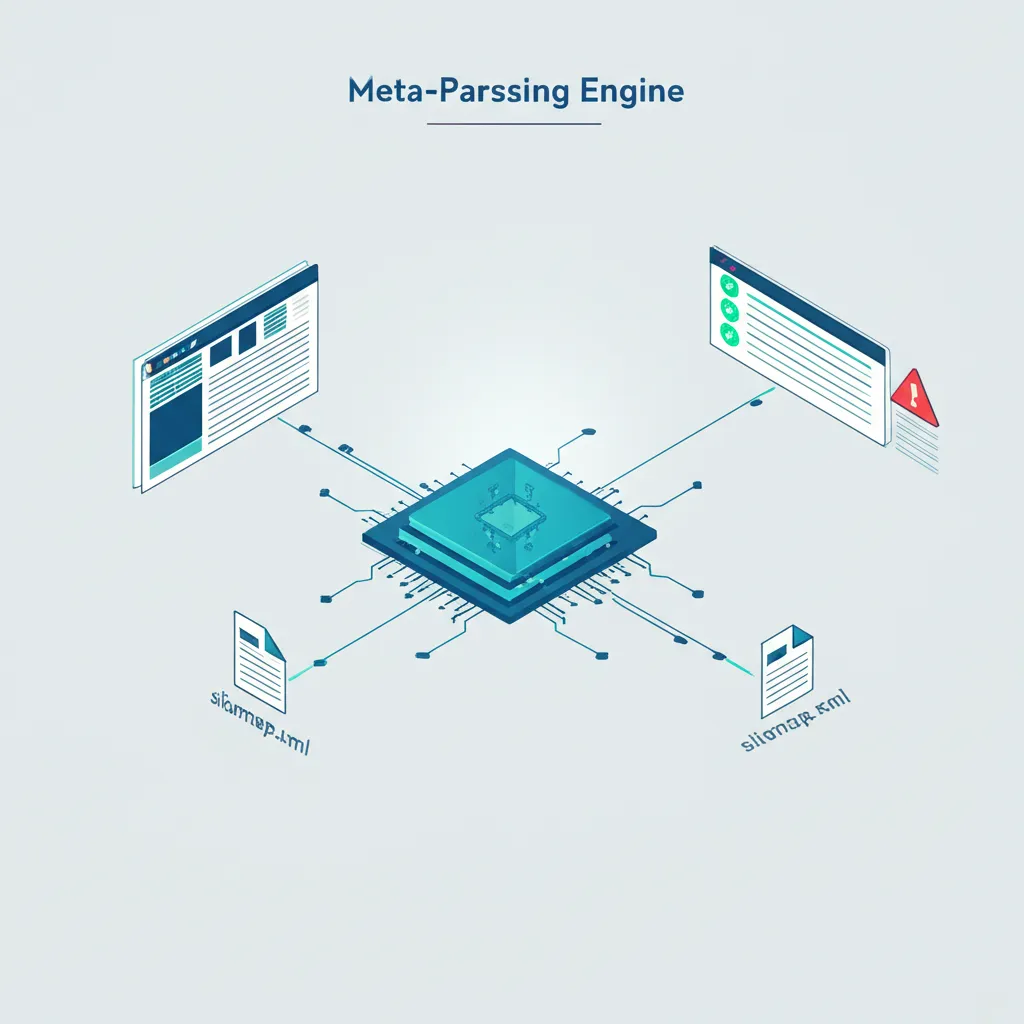

Мета-парсинг: автогенерация карт сайта, автоматизация краулинговых задач — это комплексный подход к управлению техническим состоянием веб-ресурса, который выходит за рамки простого сбора информации. В отличие от стандартного парсинга, где основной целью является извлечение сведений (URL-адресов, текстов, цен), мета-парсинг подразумевает создание интеллектуальной надстройки. Эта система не только собирает информацию, но и анализирует её, принимает решения и запускает последующие процессы без участия человека. Представьте себе не просто сборщика данных, а цифрового ассистента, который самостоятельно следит за здоровьем вашего проекта, обновляет навигационные файлы и сообщает о критических ошибках.

Что скрывается за понятием мета-парсинга?

Чтобы понять суть, проведем аналогию. Обычный краулер (парсер) похож на курьера, который доставляет вам посылки — в нашем случае, пакеты с информацией о страницах веб-портала. Он принесет вам список всех адресов, их заголовки и коды ответа сервера. Вы получаете эти сведения и дальше вручную решаете, что с ними делать: искать «битые» ссылки, проверять дубликаты мета-тегов, обновлять карту для поисковиков.

Мета-парсинг — это уже целый логистический центр. Он не просто принимает посылки, а вскрывает их, сортирует содержимое по категориям, проверяет на брак (ошибки 404), откладывает товары для специальной обработки (например, страницы с `noindex`), а затем формирует новые отправления (генерирует `sitemap.xml`) и отправляет отчеты о проделанной работе. Таким образом, это второй, аналитический уровень, который работает с результатами первичного сбора сведений. Этот механизм превращает необработанный поток информации в конкретные действия.

Автоматическая генерация Sitemap.xml: от теории к практике

Карта сайта (`sitemap.xml`) — один из ключевых файлов для поисковой оптимизации, особенно для крупных проектов с тысячами страниц. Ручное обновление этого файла — неблагодарный и неэффективный труд. Именно здесь мета-парсинг раскрывает свой потенциал. Процесс выглядит следующим образом:

- Первичное сканирование (краулинг). Специальный скрипт или программа обходит все доступные страницы ресурса, собирая их URL. На этом этапе формируется полный список адресов, существующих на проекте в данный момент.

- Анализ и фильтрация. Это ядро мета-парсинга. Система анализирует полученный список URL и применяет к нему набор правил:

- Исключение страниц с кодом ответа, отличным от 200 OK (например, 404, 500).

- Удаление адресов, закрытых от индексации в файле `robots.txt` или мета-тегом `robots` со значением `noindex`.

- Проверка на каноничность. Если у страницы указан `rel="canonical"` на другой URL, она не включается в карту.

- Исключение дубликатов и технических страниц (например, страниц пагинации, если это предусмотрено стратегией).

- Формирование файла. На основе отфильтрованного, «чистого» списка URL система генерирует валидный `sitemap.xml` файл. Она может также добавлять дополнительные атрибуты, такие как `lastmod` (дата последнего изменения) или `priority`.

- Регулярный запуск. Весь цикл настраивается на автоматическое выполнение по расписанию, например, раз в сутки. Это гарантирует, что поисковые системы всегда имеют доступ к актуальной структуре вашего веб-портала.

Продуманный механизм мета-парсинга для генерации sitemap.xml позволяет не только экономить десятки часов работы специалиста, но и минимизировать риск человеческой ошибки, обеспечивая поисковым роботам всегда свежую и корректную информацию о структуре проекта.

Расширяем горизонты: какие еще краулинговые задачи можно автоматизировать?

Автогенерация карты — лишь одна из множества функций, которые можно реализовать с помощью этого подхода. Возможности ограничены только вашей фантазией и потребностями проекта. Вот несколько примеров других автоматизированных операций:

- Мониторинг «битых» ссылок. Система регулярно сканирует ресурс и при обнаружении ссылок, ведущих на страницы с ошибкой 404, автоматически формирует отчет и отправляет его на почту ответственному сотруднику. Это позволяет оперативно исправлять ошибки и улучшать пользовательский опыт.

- Аудит мета-тегов. Краулер собирает `title` и `description` со всех страниц. Аналитический модуль проверяет их на соответствие заданным критериям: отсутствие, дублирование, превышение или недостаточная длина. Результаты выводятся в удобном дашборде.

- Контроль за изменениями на страницах. Система может делать «снимки» контента страниц и сравнивать их с предыдущими версиями. Это помогает отслеживать несанкционированные изменения, контролировать работу контент-менеджеров или фиксировать дату обновления для атрибута `lastmod`.

- Анализ внутренней перелинковки. Механизм мета-парсинга способен строить граф внутренних ссылок, выявляя «осиротевшие» страницы (на которые нет ссылок), находить страницы с избыточным количеством исходящих линков или определять наиболее весомые разделы ресурса.

- Проверка скорости загрузки. Интегрировав парсер с инструментами вроде Lighthouse API, можно настроить регулярную проверку ключевых страниц на скорость загрузки и получать уведомления при падении производительности.

Инструменты и технологии для внедрения

Реализация такого решения может идти двумя путями: использование готовых облачных сервисов или разработка собственного инструмента. Для кастомной разработки чаще всего применяют языки программирования с развитыми библиотеками для веб-скрапинга. Безусловным лидером здесь является Python с фреймворком Scrapy, а также библиотеками BeautifulSoup и Requests. Они позволяют относительно просто настроить сборщик сведений. Аналитическая часть (мета-уровень) может быть написана на том же Python. Для хранения результатов сканирования используют базы данных, от простых SQLite до более мощных PostgreSQL или MongoDB. Запуск по расписанию обеспечивается стандартными планировщиками задач, такими как Cron в Linux.

Готовые решения, в свою очередь, предлагают удобный интерфейс и не требуют навыков программирования, но могут быть менее гибкими в настройке специфической логики. Выбор зависит от масштаба проекта, бюджета и компетенций команды.

Внедрение мета-парсинга — это инвестиция в стабильность и масштабируемость вашей SEO-стратегии. Переход от ручного аудита к автоматизированному мониторингу освобождает время для решения более сложных аналитических и стратегических целей, позволяя поддерживать техническое состояние даже очень крупных веб-проектов на высочайшем уровне.