Обработка датасета

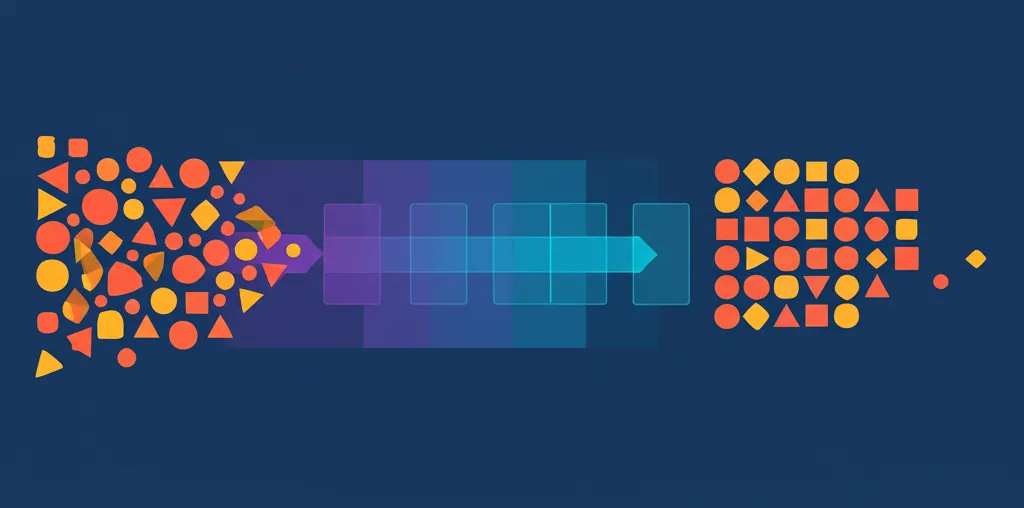

Обработка датасета — это фундаментальный этап в работе с информацией, который предшествует любому анализу, построению моделей или визуализации. Представьте, что вы шеф-повар, а данные — это ваши ингредиенты. Прежде чем приготовить изысканное блюдо, вы тщательно моете овощи, чистите их, удаляете всё лишнее и нарезаете нужным образом. Точно так же и с данными: их нужно привести в идеальный порядок. Без этого этапа результаты любого исследования будут неточными, а выводы — ошибочными. Существует золотое правило в науке о данных: "мусор на входе — мусор на выходе" (Garbage In, Garbage Out). Это означает, что даже самый совершенный алгоритм машинного обучения не сможет дать хороший результат, если его "кормить" грязными, неполными или некорректными сведениями. Качество конечного продукта напрямую зависит от качества исходного сырья.

Зачем вообще нужна подготовка данных?

Многие новички в сфере аналитики стремятся сразу перейти к построению сложных нейронных сетей или запуску алгоритмов, упуская из виду подготовительную фазу. Это стратегическая ошибка. Качественно подготовленный набор сведений позволяет решить сразу несколько ключевых задач:

- Повышение точности моделей. Большинство алгоритмов чувствительны к качеству входной информации. Аномалии, пропуски и ошибки могут сильно исказить результат, направив обучение по ложному пути.

- Улучшение производительности. Работа с очищенными, структурированными и оптимизированными наборами информации происходит значительно быстрее и требует меньше вычислительных ресурсов.

- Получение достоверных инсайтов. Только на основе чистых и корректных данных можно делать правильные выводы, находить скрытые закономерности и принимать взвешенные бизнес-решения.

- Обеспечение совместимости. Данные из разных источников часто имеют разный формат, структуру и наименования. Приведение их к единому стандарту — обязательное условие для совместного анализа.

По сути, этот процесс превращает сырой, хаотичный набор информации в структурированный и пригодный для использования бизнес-актив. Затраты времени на этом этапе всегда окупаются качеством и надежностью итогового результата.

Ключевые этапы: обработка датасета от А до Я

Процесс подготовки данных можно условно разделить на несколько последовательных шагов. В реальных проектах эти шаги могут пересекаться и повторяться в итеративном режиме, но их базовое понимание помогает выстроить четкий и логичный план работы.

- Сбор и первичное исследование (Data Exploration). На этом этапе данные собираются из различных источников: баз данных, API, файлов (CSV, Excel). После сбора необходимо провести первичный осмотр: узнать размер набора (количество строк и столбцов), изучить типы данных в каждом столбце (число, текст, дата), проверить наличие пропусков, построить базовые гистограммы для числовых признаков. Это как первое знакомство с материалом, позволяющее оценить его общее состояние.

- Очистка данных (Data Cleaning). Самый трудоемкий, но и самый важный шаг. Здесь мы избавляемся от "мусора": заполняем пропуски, исправляем ошибки, удаляем дубликаты и работаем с аномальными значениями.

- Трансформация и обогащение (Data Transformation & Feature Engineering). После очистки данные нужно привести к формату, удобному для анализа и моделей. Это включает масштабирование, кодирование категорий и создание новых, более информативных признаков из уже существующих.

Глубокое погружение в очистку данных

Очистка — это сердце всего процесса. Рассмотрим её основные компоненты подробнее, чтобы понять, с какими типичными проблемами сталкиваются аналитики.

Работа с пропущенными значениями

Редко какой реальный набор данных бывает полным. Пропуски могут возникать из-за технических сбоев при сборе, ошибок при ручном вводе или просто потому, что какая-то информация не была зафиксирована. Что с ними делать?

- Удаление. Самый простой способ — удалить строки (объекты) или целые столбцы (признаки) с пропусками. Этот метод подходит, если пропусков очень мало. В противном случае есть риск потерять ценную информацию. Удаление столбца оправдано, если он пуст более чем на 60-70%.

- Заполнение (Imputation). Более предпочтительный подход. Пропуски можно заполнить средним (для нормально распределенных данных), медианным (если есть выбросы) или модальным (для категорий) значением по столбцу.

- Продвинутые методы. Существуют алгоритмы (например, KNN Imputer), которые могут предсказать пропущенные значения на основе "соседних" данных.

Выбор метода зависит от контекста. Например, заполнять пропуск в столбце "доход клиента" нулем — плохая идея, так как это будет воспринято моделью как реальный нулевой доход. Лучше использовать медианное значение, чтобы не искажать общую картину.

Устранение дубликатов

Дубликаты — это полностью идентичные строки в таблице. Они могут появиться из-за ошибок при объединении нескольких источников или повторной отправки формы пользователем. Дубликаты искусственно завышают значимость некоторых наблюдений и могут привести к переобучению модели. Их следует находить и удалять.

Борьба с выбросами (Anomalies)

Выбросы — это значения, которые сильно отличаются от большинства других в наборе. Например, возраст клиента 150 лет или сумма покупки -1000 рублей. Это может быть как опечатка, так и реальное, но очень редкое явление. Выбросы могут сильно влиять на статистические показатели (особенно на среднее) и искажать результаты. Их можно либо удалять, либо заменять на более реалистичные (например, на границу 99-го перцентиля).

Трансформация и создание новых признаков

Даже после очистки данные могут быть непригодны для некоторых алгоритмов. Трансформация помогает это исправить, а создание признаков — извлечь из данных максимум пользы.

Нормализация и стандартизация

Представьте, что у вас есть два столбца: "возраст" (значения от 18 до 70) и "зарплата" (значения от 50 000 до 500 000). Алгоритмы, основанные на вычислении расстояний, будут считать признак "зарплата" гораздо более важным просто из-за большего масштаба чисел. Чтобы этого избежать, применяют масштабирование:

- Нормализация (Min-Max Scaling) приводит все значения к заданному диапазону, чаще всего от 0 до 1.

- Стандартизация (Z-score Standardization) преобразует данные так, чтобы среднее значение стало равно 0, а стандартное отклонение — 1. Этот метод менее чувствителен к выбросам.

Инжиниринг признаков (Feature Engineering)

Это творческий процесс создания новых, более информативных столбцов на основе существующих. Качественные признаки — залог успеха модели. Примеры:

- Из столбца с датой и временем покупки можно извлечь час дня, день недели, месяц, является ли день выходным. Это может помочь выявить временные паттерны.

- Имея рост и вес человека, можно вычислить новый признак — индекс массы тела (ИМТ).

- Из текстового описания товара можно извлечь его длину в символах или количество ключевых слов.

Кодирование категориальных данных

Модели машинного обучения не умеют работать с текстом напрямую. Если у вас есть столбец "отдел" со значениями "Продажи", "Маркетинг", "Разработка", их нужно преобразовать в числа. Популярный метод — One-Hot Encoding. Он создает новые бинарные столбцы для каждого уникального значения ("is_Sales", "is_Marketing"), где ставится 1 или 0.

Инструменты для специалиста

Для всех описанных выше задач существуют удобные инструменты, которые значительно упрощают жизнь аналитика. Ручная обработка датасета в современных реалиях практически невозможна.

- Python. Язык программирования, ставший стандартом в Data Science. Библиотеки Pandas и NumPy предоставляют мощнейший функционал для манипуляций с данными. Scikit-learn содержит готовые решения для масштабирования, кодирования и заполнения пропусков.

- R. Еще один популярный язык в статистике и анализе данных. Пакеты dplyr и tidyr делают процесс очистки и трансформации интуитивно понятным.

- SQL. Язык запросов к базам данных. Многие первичные операции, такие как фильтрация, агрегация и удаление дубликатов, можно эффективно выполнить еще на этапе извлечения информации из хранилища.

Начинающему специалисту стоит сосредоточиться на изучении Python и библиотеки Pandas. Это наиболее универсальный и востребованный навык на рынке труда, открывающий двери в мир анализа данных. В конечном счете, качественная обработка датасета — это не просто техническая процедура, а сочетание научного подхода и искусства, требующее понимания предметной области, внимания к деталям и критического мышления. Это прочный фундамент, на котором строятся все дальнейшие открытия и инсайты, скрытые в сырых данных.