Оптимизация конвейеров данных: выявление сбоев в реальном времени

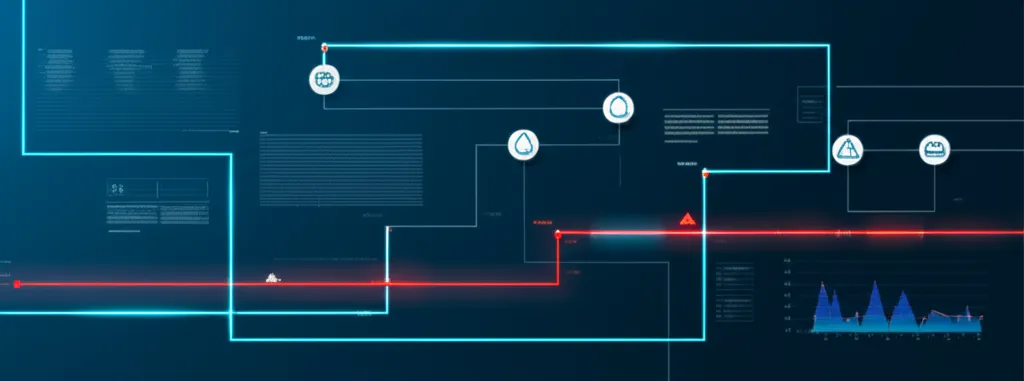

Оптимизация конвейеров данных: выявление сбоев в реальном времени — это не техническая прихоть, а фундаментальная необходимость для любого бизнеса, который полагается на информацию для принятия решений. Представьте себе систему водоснабжения города: если в одной из труб происходит утечка, важно узнать об этом не через неделю, когда подвал затоплен, а мгновенно. Конвейеры данных (data pipelines) — это такие же артерии для информации в компании. Они собирают сведения из разных источников (сайты, приложения, CRM-системы), преобразуют их и доставляют в хранилища или аналитические инструменты. Когда этот поток прерывается или искажается, последствия могут быть катастрофическими: от неверных финансовых отчетов до провальных маркетинговых кампаний.

Проблема в том, что эти процессы часто работают в фоновом режиме, и их сбои могут оставаться незамеченными часами, днями или даже неделями. Данные либо перестают поступать, либо приходят в искаженном виде, подтачивая доверие к аналитике во всей организации. Эффективная стратегия обнаружения аномалий в реальном времени позволяет превратить реактивную борьбу с «пожарами» в проактивное управление здоровьем информационной инфраструктуры.

Почему конвейеры данных ломаются? Распространенные причины

Сбои в пайплайнах редко бывают случайными. Обычно они являются следствием предсказуемых событий, которые можно и нужно отслеживать. Понимание корневых причин — первый шаг к построению надежной системы мониторинга.

- Изменения в источниках. Внешние API, с которых вы собираете информацию, могут изменить свою структуру без предупреждения. Например, поле `user_id` переименовали в `customer_id`. Ваш код, ожидающий старое название, не сможет обработать новые поступления, что приведет к остановке потока.

- Проблемы качества информации. Источник может начать присылать записи с пустыми значениями в ключевых полях, некорректными форматами дат или текстовыми строками там, где ожидаются числа. Такие «отравленные» записи могут сломать весь последующий этап обработки.

- Инфраструктурные неполадки. Сервер, на котором выполняется скрипт обработки, может выйти из строя. Сетевое соединение с базой данных может прерваться. Место на диске может закончиться. Эти базовые проблемы часто упускаются из виду, но являются частой причиной инцидентов.

- Человеческий фактор и ошибки в коде. Баг, допущенный разработчиком в коде трансформации, может приводить к неверным расчетам или потере части записей. Развертывание нового кода без достаточного тестирования — прямой путь к инциденту.

- Резкие скачки объема. Пайплайн, рассчитанный на обработку 10 000 событий в час, может не справиться с внезапным наплывом 100 000 событий после успешной рекламной акции. Это приводит к перегрузкам и потере информации.

Последствия несвоевременного обнаружения проблем

Чем дольше сбой остается незамеченным, тем серьезнее его влияние на бизнес. Это как снежный ком: маленькая ошибка на входе порождает лавину проблем на выходе, затрагивая множество систем и команд.

- Коррозия данных. Некорректные или неполные сведения попадают в аналитическое хранилище (DWH) и начинают распространяться по всем зависимым отчетам и моделям машинного обучения. Очистка хранилища от «зараженных» записей — сложная и трудоемкая задача.

- Принятие неверных решений. Руководство, глядя на отчет, построенный на ошибочных цифрах, может принять стратегически неверное решение: вложить бюджет в неэффективный канал или, наоборот, урезать финансирование перспективного направления.

- Потеря доверия к аналитике. Когда бизнес-пользователи несколько раз сталкиваются с неверными отчетами, они перестают доверять данным в принципе. Это обесценивает работу всего аналитического отдела и возвращает компанию к принятию решений на основе интуиции.

- Прямые финансовые и репутационные потери. Ошибки в биллинговых системах, неверно рассчитанные скидки для клиентов, сбои в рекомендательных системах — все это напрямую влияет на доход и лояльность аудитории.

«Нет ничего хуже, чем потратить два дня на поиск причины аномалии в отчете, чтобы в итоге обнаружить, что пайплайн обработки данных был сломан уже неделю. Ты не просто чинишь код, ты пытаешься восстановить доверие коллег к твоей работе и к цифрам, которые ты им предоставляешь».

Стратегии мониторинга и обнаружения аномалий

Переход от реактивного подхода («чиним, когда сломалось и кто-то пожаловался») к проактивному («получаем оповещение в момент возникновения аномалии») требует внедрения концепции наблюдаемости данных (Data Observability). Это комплексный подход к мониторингу, который фокусируется не только на работе инфраструктуры, но и на здоровье самого информационного потока.

Ключевые метрики для отслеживания

Чтобы понять, что с пайплайном что-то не так, нужно измерять его состояние по нескольким ключевым параметрам. Наблюдение за этими метриками в динамике позволяет выявлять аномалии, указывающие на потенциальные проблемы.

- Свежесть (Freshness): Как давно обновлялись записи в целевой таблице? Если отчет должен обновляться каждый час, а последнее обновление было 5 часов назад, это явный признак сбоя.

- Объем (Volume): Соответствует ли количество поступающих записей историческим средним значениям? Резкое падение (например, 0 записей вместо обычных 1000) или аномальный всплеск могут сигнализировать о проблеме.

- Распределение (Distribution): Каковы статистические характеристики данных в числовых полях (среднее, медиана, процентили)? Если средняя сумма чека в таблице заказов внезапно выросла в 10 раз, возможно, в систему попали тестовые записи.

- Схема (Schema): Не изменилась ли структура источника? Система мониторинга должна автоматически отслеживать добавление, удаление или переименование полей в таблицах.

- Происхождение (Lineage): Понимание того, как таблицы и отчеты связаны друг с другом, помогает быстро локализовать источник проблемы и оценить масштаб ее влияния на зависимые системы.

Инструменты и подходы для немедленного реагирования

Сбор метрик — это только половина дела. Необходимо выстроить систему, которая будет анализировать эти показатели и немедленно уведомлять ответственных сотрудников о любых отклонениях.

Структурированное логирование. Каждый этап конвейера должен генерировать подробные и стандартизированные логи: сколько записей получено, сколько обработано, сколько отброшено из-за ошибок. Анализ логов — первый шаг в расследовании любого инцидента.

Системы мониторинга и визуализации. Инструменты вроде Prometheus и Grafana или коммерческие аналоги (Datadog) позволяют собирать метрики, хранить их и строить дашборды. Визуализация помогает наглядно отслеживать состояние всех пайплайнов и замечать отклонения от нормы.

Автоматизированные оповещения (Alerting). На основе собранных метрик настраиваются правила для оповещений. Критически важно настроить их так, чтобы они срабатывали только на реальные проблемы, избегая «шума» и усталости от алертов. Оповещения могут приходить в Slack, Telegram, на почту или в системы управления инцидентами, такие как PagerDuty.

Практические шаги по внедрению системы обнаружения сбоев

Построение надежной системы мониторинга — это итеративный процесс. Не нужно пытаться охватить все и сразу. Лучше начать с самых критичных конвейеров и постепенно расширять покрытие.

Аудит существующих процессов

Прежде чем что-то внедрять, проведите инвентаризацию. Составьте карту ваших ключевых пайплайнов. Определите, какие из них наиболее важны для бизнеса. Где находятся самые уязвимые места? Какие сбои в прошлом вызывали больше всего проблем? Этот анализ поможет сфокусировать усилия там, где они принесут максимальную пользу.

Внедрение автоматизированных проверок качества

Используйте инструменты для автоматического тестирования данных непосредственно внутри пайплайна. Фреймворки, такие как Great Expectations или тесты в dbt (Data Build Tool), позволяют задавать правила, которым должны соответствовать ваши записи. Например, можно настроить проверку на то, что:

- Колонка с идентификатором пользователя не содержит пустых значений.

- Значения в колонке `status` могут быть только из определенного списка ('created', 'paid', 'shipped').

- Количество записей в таблице не уменьшилось по сравнению со вчерашним днем.

Если проверка не проходит, пайплайн может быть автоматически остановлен, а ответственная команда получит оповещение.

Эффективная система выявления сбоев — это не просто набор инструментов, а изменение культуры работы с информацией. Ответственность за качество распределяется между инженерами, аналитиками и владельцами продуктов, создавая общую заинтересованность в надежности и достоверности аналитики.

Заключение: от хаоса к контролю

Оптимизация конвейеров данных через внедрение систем выявления сбоев в реальном времени — это инвестиция в стабильность и предсказуемость бизнеса. Она позволяет перейти от постоянного тушения пожаров к планомерному развитию аналитической инфраструктуры. Вместо того чтобы тратить время на поиск причин расхождений в отчетах, команды могут сосредоточиться на извлечении ценности из информации, будучи уверенными в ее качестве и своевременности. В мире, где скорость и точность принятия решений определяют конкурентное преимущество, надежные данные — это не роскошь, а необходимое условие выживания.