Пагинация в веб-скрапинге: как извлечь все данные, а не только первую страницу

Пагинация в веб-скрапинге представляет собой одну из фундаментальных задач, с которой сталкивается каждый специалист по сбору информации. Большинство сайтов, от интернет-магазинов до новостных порталов, не отображают весь контент на одном экране. Они разбивают его на части — страницы, чтобы улучшить производительность и удобство для пользователя. Для скрапера это означает, что простой запрос к одному URL вернет лишь малую долю доступной информации. Эффективная обработка постраничной навигации — ключ к получению полного набора сведений.

Почему стандартный подход к скрапингу не работает

Новички в извлечении веб-данных часто создают скрипт, который успешно парсит одну страницу. Он находит нужные товары, статьи или контакты, но только те, что видны при первой загрузке. Когда выясняется, что на сайте тысячи таких элементов, расположенных на сотнях экранов, возникает проблема. Скрипт нужно научить «переключаться» между ними, имитируя поведение человека, который нажимает на номера 1, 2, 3... или кнопку «Далее». Без этого механизма собранная информация будет неполной и практически бесполезной для анализа.

Идентификация типа пагинации: первый шаг к успеху

Прежде чем писать код, необходимо провести разведку. Способ организации постраничной навигации может сильно отличаться от ресурса к ресурсу. Ключевая задача — понять логику, по которой сайт загружает новые порции контента. Для этого нужно внимательно изучить несколько аспектов:

- URL-адрес: Меняется ли он при переходе на следующую страницу? Если да, то как? Часто в нем появляются параметры вроде

?page=2или&offset=20. - HTML-код кнопок навигации: Необходимо исследовать ссылки, скрытые за кнопками «Вперед», «Назад» и номерами. Это поможет найти шаблоны для генерации URL или селекторы для поиска нужных ссылок.

- Сетевая активность: Если URL не меняется, скорее всего, контент подгружается динамически с помощью JavaScript. В этом случае нужно открыть инструменты разработчика в браузере (F12) и на вкладке «Сеть» (Network) отследить запросы, которые отправляются при клике на кнопку «Показать еще» или при прокрутке.

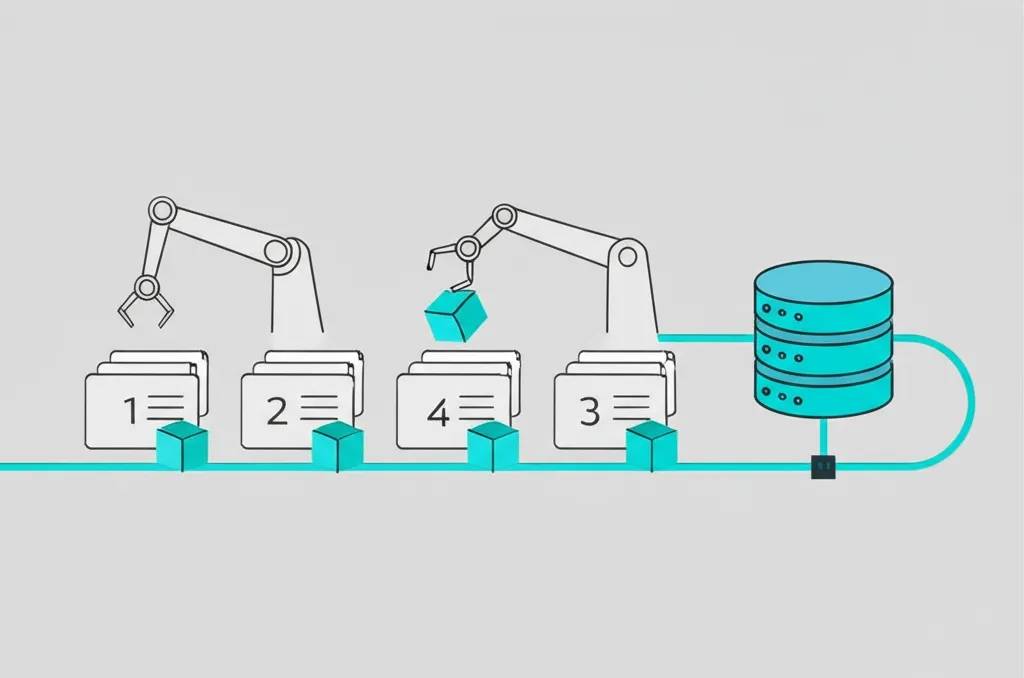

Основные механизмы пагинации и методы их обхода

Все многообразие постраничной навигации можно свести к нескольким основным типам. Поняв, с каким из них вы имеете дело, можно выбрать наиболее подходящую стратегию для сбора информации.

Классическая нумерация страниц (Offset-based)

Это самый распространенный и простой для обработки тип. При переходе на следующую страницу в URL меняется числовой параметр. Например, example.com/products?page=1, example.com/products?page=2 и так далее. Иногда вместо `page` используются другие слова: `p`, `n`, `start`, `offset`.

Алгоритм действий в этом случае следующий:

- Определить базовый URL и параметр, отвечающий за номер страницы.

- Найти общее количество страниц. Обычно эта информация есть на сайте (например, «Показано 1-20 из 1000»). Если ее нет, можно парсить до тех пор, пока не встретится пустая страница или сервер не вернет ошибку 404.

- Сгенерировать в цикле все необходимые URL-адреса и последовательно их обработать.

При работе с таким типом навигации всегда проверяйте, что происходит при запросе несуществующей страницы (например, 1000-й, если всего их 50). Ваш скрипт должен корректно обрабатывать такие ситуации, а не завершаться с ошибкой.

Кнопки «Вперед» и «Назад» (Sequential)

Некоторые сайты не показывают номера всех страниц, а предлагают только кнопки для перехода к следующей или предыдущей. URL при этом может меняться, но его структуру не всегда легко предсказать. В этом случае стратегия меняется: скрипт должен работать как настоящий пользователь.

Логика такова: на текущей странице нужно найти элемент (обычно тег <a>), который ведет на следующую. Затем извлечь из него атрибут `href`, перейти по этой ссылке, собрать сведения и повторить процесс. Цикл продолжается до тех пор, пока на странице присутствует активная кнопка «Вперед». Когда она исчезает или становится неактивной — это сигнал, что достигнут конец списка.

Бесконечная прокрутка (Infinite Scroll)

Современный и популярный метод, при котором новые элементы подгружаются автоматически, когда пользователь добирается до низа экрана. Здесь URL-адрес остается неизменным, а контент добавляется с помощью JavaScript, который в фоновом режиме отправляет запросы к серверу. Стандартные HTTP-библиотеки вроде `requests` здесь бессильны, так как они не исполняют JS.

Решение — изучить сетевую активность во вкладке Network инструментов разработчика. При прокрутке вы увидите запросы (часто XHR/Fetch), которые уходят на некий API-эндпоинт. Обычно эти запросы возвращают информацию в структурированном виде, например, JSON. Ваша задача — понять структуру этого запроса (URL, параметры, заголовки) и научить свой скрипт напрямую обращаться к этому API. Это самый эффективный и быстрый способ сбора сведений с таких ресурсов.

Кнопка «Показать еще» (Load More)

Этот механизм очень похож на бесконечную прокрутку, но требует активного действия от пользователя — нажатия на кнопку. Контент также подгружается динамически через JavaScript. Подходы к решению аналогичны:

- Анализ API: Предпочтительный метод. Нужно отследить сетевой запрос, который отправляется при клике на кнопку, и имитировать его в своем коде.

- Браузерная автоматизация: Если анализ API затруднен, можно использовать инструменты вроде Selenium или Playwright. Они запускают полноценный браузер, в котором ваш скрипт может программно прокручивать страницу и нажимать на кнопку «Показать еще», дожидаясь загрузки нового контента перед его парсингом.

Практические аспекты и подводные камни

Реализация обхода пагинации требует внимания к деталям. Существуют общие проблемы, которые могут остановить даже хорошо написанный парсер.

Динамическое определение последней страницы

Как скрипту понять, что пора остановиться? Есть несколько надежных способов:

- Проверка наличия элемента навигации: Цикл продолжается, пока на странице есть кнопка «Следующая».

- Анализ контента: Если после перехода на новую страницу на ней не оказывается искомых элементов (например, карточек товаров), это означает конец списка.

- Сравнение содержимого: Иногда при запросе несуществующей страницы сайт отдает ту же информацию, что и на последней. Необходимо сравнивать хэш или содержимое текущей и предыдущей страниц, чтобы избежать бесконечного цикла.

Уважение к серверу: задержки и User-Agent

Агрессивный скрапинг, отправляющий сотни запросов в секунду, создает высокую нагрузку на сервер и может привести к временной или постоянной блокировке вашего IP-адреса. Чтобы избежать этого, следует придерживаться этичных практик:

- Устанавливайте задержки: Добавляйте паузу (например, `time.sleep(2)`) между запросами. Это снижает нагрузку и делает поведение вашего скрипта более похожим на человеческое.

- Используйте User-Agent: Представляйтесь реальным браузером, указывая соответствующий заголовок в запросе. Это повышает доверие со стороны сервера.

- Соблюдайте правила `robots.txt`: Всегда проверяйте файл `robots.txt` на целевом ресурсе, чтобы убедиться, что вы не нарушаете установленные им правила сканирования.

В заключение, пагинация — это не препятствие, а стандартный элемент веб-архитектуры. Правильный анализ ее механизма и выбор соответствующей стратегии позволяют создавать надежные и эффективные скраперы, способные собрать полный объем необходимых сведений для любого аналитического проекта.