Парсер СП: детальный разбор инструмента для бизнеса и покупателей

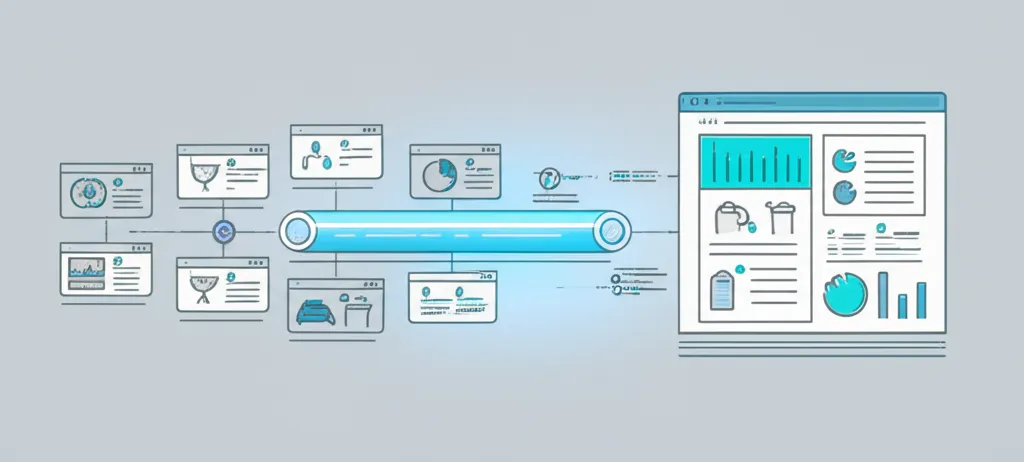

Парсер СП представляет собой специализированную программу или сервис, предназначенный для автоматического сбора информации с веб-сайтов, посвященных совместным покупкам. Если говорить проще, это цифровой помощник, который вместо человека заходит на нужные интернет-ресурсы, находит там конкретные сведения (например, о товарах, ценах, размерах) и сохраняет их в удобном структурированном виде, например, в таблицу Excel. Этот процесс, называемый парсингом, позволяет обрабатывать огромные объемы информации за считанные минуты, что вручную заняло бы дни или даже недели. Главная ценность такого инструмента заключается в колоссальной экономии времени и снижении вероятности ошибок, связанных с человеческим фактором.

Что скрывается за этим термином?

Слово «парсер» происходит от английского «to parse», что означает «анализировать, разбирать». В контексте совместных покупок (СП) этот инструмент выполняет именно такую функцию: он «разбирает» код веб-страницы, чтобы извлечь из него полезные сведения. Представьте, что вы зашли на страницу с каталогом платьев. Вы видите фотографии, названия, описания, стоимость. Программа видит не картинки, а HTML-код, в котором вся эта информация размечена специальными тегами. Задача скрипта — найти нужные теги (например, тег с ценой или описанием) и скопировать их содержимое. Таким образом, он может систематически обходить тысячи страниц, собирая структурированные данные для дальнейшего анализа или использования.

Ключевые задачи, решаемые с помощью парсинга

Применение подобных технологий не ограничивается одной сферой. Они полезны разным категориям пользователей, от организаторов закупок до рядовых участников и аналитиков рынка. Вот основные направления, где парсинг приносит максимальную пользу:

- Для организаторов совместных покупок. Это основная аудитория. Сборщик помогает автоматизировать наполнение каталогов. Вместо ручного копирования каждого товара с сайта поставщика, организатор запускает программу, которая делает это за него. Это позволяет оперативно обновлять ассортимент, отслеживать наличие товаров и актуальные цены у поставщиков.

- Для участников закупок. Покупатели могут использовать результаты парсинга для сравнения условий у разных организаторов. Например, найти, у кого самая низкая комиссия на интересующий продукт или где быстрее собирается минимальная партия для выкупа.

- Для анализа рынка. Предприниматели и маркетологи используют собранные сведения для анализа конкурентов, изучения спроса на определенные категории товаров, мониторинга ценовой политики и выявления рыночных трендов. Это позволяет принимать взвешенные бизнес-решения.

Важно понимать, что грамотное использование технологий сбора информации открывает новые возможности для оптимизации рутинных операций и получения конкурентного преимущества. Автоматизация — это не будущее, а настоящее эффективного ведения дел в электронной коммерции.

Принцип работы: как извлекается информация

Механизм работы большинства парсеров можно условно разделить на несколько этапов. Хотя для конечного пользователя процесс выглядит как нажатие одной кнопки, внутри происходит сложная последовательность действий. Давайте разберем ее по шагам, чтобы понять внутреннюю кухню.

- Отправка запроса. Программа обращается к целевому сайту так же, как это делает ваш браузер, когда вы вводите адрес в строку. Она отправляет HTTP-запрос на сервер, где хранится ресурс.

- Получение ответа. Сервер в ответ присылает HTML-код страницы. Это текстовый документ, содержащий всю структуру и контент, который вы видите на экране: тексты, ссылки на изображения, скрипты.

- Анализ и извлечение. На этом этапе скрипт начинает «читать» полученный код. Он ищет заранее определенные элементы — классы, идентификаторы, теги, в которых заключена нужная информация. Например, он знает, что название продукта всегда находится внутри тега

<h1>с классомproduct-title. - Структурирование и сохранение. Все извлеченные фрагменты (название, цена, артикул, описание) раскладываются по полочкам и сохраняются в файл нужного формата: CSV, Excel, JSON или напрямую в базу данных. В итоге пользователь получает готовую таблицу с чистыми и упорядоченными сведениями.

Какие сведения можно получить?

Спектр собираемых данных очень широк и зависит от конкретной задачи и структуры сайта-источника. Фактически, можно извлечь любую информацию, которая отображается на странице. Чаще всего собирают следующие показатели:

- Наименование товара и его артикул;

- Розничная и оптовая стоимость;

- Размер организационного сбора;

- Ссылки на фотографии и видео;

- Полное описание и технические характеристики;

- Доступные размеры, цвета и другие модификации;

- Отзывы покупателей и рейтинги;

- Информация о наличии на складе.

Выбор подходящего решения: готовый сервис или своя разработка?

Когда возникает потребность в парсинге, встает вопрос: купить готовый продукт или заказать разработку под свои нужды? Оба варианта имеют свои плюсы и минусы. Готовые облачные сервисы или десктопные программы обычно предлагают интуитивно понятный интерфейс и не требуют навыков программирования. Они работают по подписке и отлично подходят для типовых задач. Однако их функциональность может быть ограничена, и они не всегда справляются со сложными или нестандартными сайтами. Заказная разработка — это создание инструмента, идеально заточенного под ваши цели. Такой скрипт будет учитывать все особенности нужных вам ресурсов. Это более гибкое, но и более дорогое решение, требующее времени и технических компетенций.

Юридические и этические аспекты сбора сведений

Автоматизированный сбор контента — тема, которая находится на стыке технологий и права. Перед тем как запускать парсер, стоит ознакомиться с правилами пользования сайта-донора. Многие ресурсы прописывают в них запрет на автоматический сбор информации. Также существует файл robots.txt, в котором владельцы сайтов указывают, какие разделы можно, а какие нельзя сканировать роботам. Игнорирование этих правил может привести к блокировке вашего IP-адреса. Кроме того, слишком частые и агрессивные запросы могут создавать избыточную нагрузку на сервер, мешая его работе. Поэтому важно подходить к процессу ответственно: настраивать задержки между запросами и не нарушать установленные владельцами ресурсов правила. Ответственный подход обеспечит долгосрочную и беспроблемную работу.