Парсинг и скрапинг отличия

Парсинг и скрапинг отличия часто вызывают путаницу у тех, кто только начинает знакомиться с автоматизированным сбором информации из интернета. Эти термины нередко используют как синонимы, хотя они описывают два разных, хотя и тесно связанных, этапа одного большого процесса. Понимание их разницы — ключ к эффективной работе с веб-данными, будь то для маркетингового анализа, научных исследований или автоматизации бизнес-задач. Эта статья поможет разграничить эти понятия, объяснить их суть простым языком и показать, как они взаимодействуют на практике.

Скрапинг: извлечение сырых материалов с веб-страниц

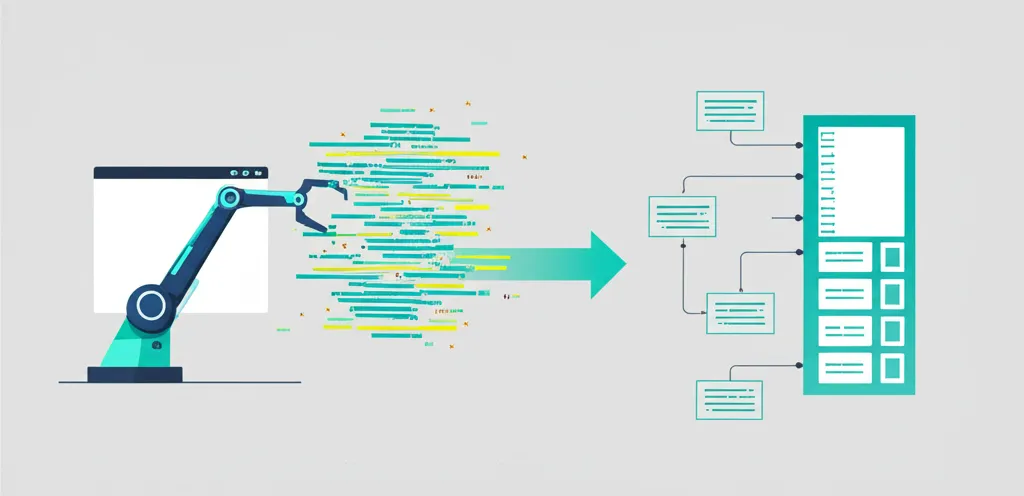

Представьте, что вы пришли в огромную библиотеку с заданием собрать все книги по определённой теме. Вы не читаете их на месте, а просто берёте с полок и складываете в тележку. Это и есть аналогия скрапинга. Веб-скрапинг (web scraping) — это процесс автоматического извлечения информации с сайтов. Его основная задача — получить «сырой» материал, то есть полный HTML-код веб-страницы, со всеми тегами, скриптами и стилями. Скребок, или краулер, — это программа-робот, которая заходит на указанный URL-адрес и скачивает всё его содержимое, как если бы вы нажали «Сохранить страницу как...» в браузере. На этом этапе программа не анализирует, что именно она скачала. Её цель — просто получить доступ к исходному коду.

- Основная функция: Загрузка HTML-кода веб-документа.

- Инструменты: Часто используются библиотеки, такие как Requests в Python, или более сложные фреймворки типа Scrapy, которые умеют обходить целые сайты по ссылкам.

- Результат: Один или множество файлов, содержащих неструктурированный HTML-код.

Скрапинг является первым и необходимым шагом. Без получения исходного кода страницы дальнейшая обработка сведений невозможна. Это фундамент, на котором строится весь процесс сбора веб-информации.

Парсинг: структурирование и осмысление информации

Теперь вернёмся к нашей библиотечной аналогии. Вы привезли тележку книг домой. Следующий шаг — открыть каждую книгу, найти нужные главы, выписать конкретные факты, имена, даты и занести их в аккуратную таблицу. Этот процесс и есть парсинг. Парсинг (parsing) — это анализ уже полученного «сырого» материала (HTML-кода) с целью извлечения из него конкретных, нужных сведений и их преобразования в структурированный формат. Парсер — это программа, которая «читает» HTML-код, находит в нём определённые элементы по заданным правилам (например, по тегам, классам или идентификаторам) и извлекает их содержимое.

Например, если вы спарсили страницу товара в интернет-магазине, ваша задача — извлечь из неё только название товара, его цену, артикул и описание. Парсер будет искать в коде теги, в которых заключена эта информация (скажем, <h1> для названия, <span class="price"> для цены) и доставать оттуда текстовое содержимое.

Проще говоря, скрапинг — это «добыча руды», а парсинг — это «извлечение из руды чистого металла». Один процесс не может существовать без другого, если конечная цель — получить полезные, готовые к использованию сведения.

Ключевые парсинг и скрапинг отличия

Хотя эти два процесса неразрывны, их фундаментальные различия лежат в целях, методах и результатах. Понимание этих нюансов позволяет точнее ставить задачи разработчикам и выбирать правильные инструменты для работы. Давайте разберём основные моменты, которые их разделяют.

Цель и последовательность выполнения

Основное различие кроется в их назначении и очерёдности. Скрапинг всегда предшествует парсингу.

- Скрапинг: Его единственная цель — получить доступ к данным в их первозданном виде. Это процесс «вытягивания» всего содержимого веб-страницы с сервера. Он отвечает на вопрос: «Как получить информацию с этого сайта?».

- Парсинг: Его цель — проанализировать полученный контент и извлечь из него конкретные элементы. Он отвечает на вопрос: «Что именно мне нужно из этой массы информации и как это упорядочить?».

Нельзя спарсить то, что ещё не было скраплено. Сначала мы получаем HTML-документ, и только потом начинаем его разбирать на составные части. В некоторых фреймворках, как Scrapy, эти два этапа объединены и происходят почти одновременно, но логически они остаются раздельными.

Результат работы

Конечный продукт каждого процесса также кардинально отличается. Это помогает лучше понять их роли.

- Итог скрапинга: Файл (или строка в памяти программы) с полным HTML-кодом страницы. Это большой, хаотичный текстовый документ, непригодный для прямого анализа. Он содержит не только полезный контент, но и навигационные элементы, рекламу, скрипты и стили.

- Итог парсинга: Структурированный набор сведений. Это может быть таблица в формате CSV, файл JSON с чёткой иерархией, запись в базе данных или просто Python-словарь. Эти сведения уже готовы для дальнейшего использования: анализа, визуализации или импорта в другие системы.

Практическое применение и примеры

Рассмотрим конкретный пример. Допустим, вам нужно собрать информацию о ценах на ноутбуки в популярном интернет-магазине. Процесс будет выглядеть так:

- Этап 1: Скрапинг. Вы пишете или используете скрипт, который заходит на страницу категории «Ноутбуки», а затем переходит по ссылкам на каждую карточку товара и скачивает HTML-код всех этих страниц. В результате у вас есть папка с десятками HTML-файлов.

- Этап 2: Парсинг. Вы пишете второй скрипт (парсер), который последовательно открывает каждый из этих файлов. В нём вы задаёте правила: «Найди элемент с тегом

h1— это будет название модели. Найди элемент с классомproduct-price— это будет цена. Найди элемент с артикулом — это будет SKU». Скрипт извлекает эти три фрагмента из каждого файла и сохраняет их в таблицу с колонками «Название», «Цена», «SKU».

В итоге вместо хаоса HTML-кода вы получаете аккуратную и полезную таблицу для анализа цен. Скрапинг дал вам «сырьё», а парсинг превратил его в готовый продукт.

Юридические и этические моменты

Как скрапинг, так и последующий парсинг информации с сайтов находятся в «серой» юридической зоне. Важно соблюдать несколько правил:

- Изучайте robots.txt: Это файл на сайте, в котором его владелец указывает, какие разделы можно, а какие нельзя сканировать роботам. Игнорирование этих правил — дурной тон.

- Не создавайте нагрузку: Ваши скрипты не должны отправлять сотни запросов в секунду, иначе это может быть воспринято как DDoS-атака и привести к блокировке вашего IP-адреса. Делайте паузы между запросами.

- Уважайте пользовательское соглашение: Некоторые ресурсы прямо запрещают автоматический сбор сведений в своих правилах.

Сбор общедоступной информации обычно не является нарушением, но использование её в коммерческих целях может вызвать вопросы. Всегда действуйте этично и с уважением к ресурсу, который является источником сведений.

В заключение, скрапинг и парсинг — это две стороны одной медали в мире автоматизированного сбора веб-данных. Скрапинг — это грубая сила, доставляющая необработанный материал, а парсинг — это интеллект, превращающий этот материал в ценный актив. Понимание их отличий и взаимодействия позволяет эффективно решать задачи от простого мониторинга до сложного анализа рынка.