Парсинг на пайтон представляет собой процесс автоматизированного извлечения информации с веб-страниц. Этот метод позволяет собирать большие объемы сведений, которые находятся в открытом доступе, и преобразовывать их в структурированный формат для дальнейшего анализа или использования. Технология находит применение в маркетинге, электронной коммерции, научных исследованиях и многих других областях, где требуется оперативно получать и обрабатывать информацию из интернета. Язык программирования Python стал стандартом для таких задач благодаря своей простоте, мощным библиотекам и активному сообществу разработчиков. Суть веб-скрапинга заключается в имитации действий пользователя, который заходит на сайт, просматривает его содержимое и копирует нужные фрагменты. Только вместо человека это делает специально написанная программа — скрапер или парсер. Она отправляет запрос к серверу, получает в ответ HTML-код страницы, а затем «просеивает» его, находя и вытаскивая конкретные элементы: заголовки, цены, тексты статей, контактные данные или ссылки. Этот процесс значительно ускоряет сбор сведений и устраняет ручной труд.

Парсинг на пайтон: как это работает

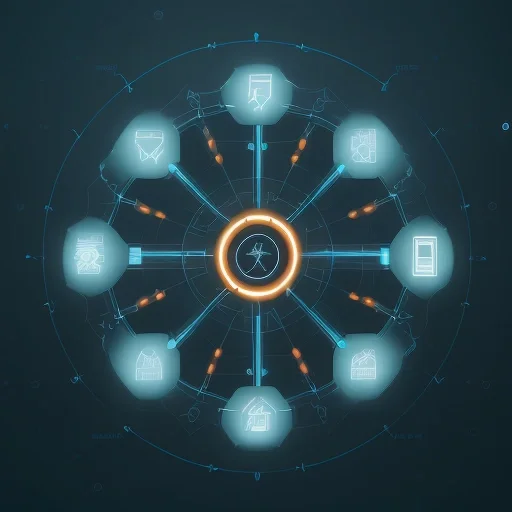

Процесс извлечения информации с помощью скрипта можно разбить на несколько логических этапов. Понимание этой последовательности помогает лучше спроектировать и реализовать задачу по сбору сведений с любого веб-ресурса. Независимо от сложности проекта, фундаментальный алгоритм остается практически неизменным.

- Отправка HTTP-запроса. Скрипт обращается к целевому URL-адресу, чтобы получить содержимое страницы. Это аналогично тому, как браузер запрашивает сайт, когда вы вводите адрес в строку поиска. Специализированные библиотеки позволяют настраивать заголовки запроса, чтобы имитировать поведение реального пользователя и обходить простые защитные механизмы.

- Получение HTML-ответа. Сервер, на котором расположен сайт, обрабатывает запрос и отправляет в ответ HTML-код. Этот код содержит всю структуру и контент веб-страницы: тексты, теги, атрибуты, ссылки на изображения и стили. На данном этапе мы имеем «сырой» текстовый документ.

- Анализ (parsing) HTML-структуры. Полученный код необходимо обработать, чтобы найти в нем нужные элементы. Для этого используются специальные инструменты, которые преобразуют текстовый HTML в древовидную структуру объектов (DOM). По этому дереву удобно перемещаться, выбирая элементы по их тегам, классам, идентификаторам или другим признакам.

- Извлечение нужной информации. После навигации по DOM-дереву программа извлекает конкретное содержимое: текст из абзаца, значение атрибута `href` из ссылки, цену товара из определенного блока. На этом шаге происходит непосредственный сбор целевых сведений.

- Сохранение результатов. Собранную информацию необходимо сохранить в удобном формате для последующей работы. Чаще всего для этого используют файлы CSV (таблицы), JSON (структурированные объекты) или напрямую записывают сведения в базу данных.

Этот цикл повторяется для каждой страницы, с которой необходимо собрать контент. Для масштабных проектов создаются «пауки» (crawlers), которые автоматически переходят по ссылкам на сайте и применяют описанный алгоритм ко всем найденным страницам.

Ключевые инструменты и библиотеки

Экосистема Python предлагает богатый выбор библиотек, которые упрощают каждый этап веб-скрапинга. Новичку достаточно освоить несколько основных, чтобы начать решать практические задачи.

- Requests. Фундаментальная библиотека для отправки HTTP-запросов. Она позволяет легко получать содержимое страниц, передавать параметры, работать с cookies и заголовками. Её синтаксис интуитивно понятен и прост. Например, чтобы получить HTML-код страницы, достаточно одной строки: `response = requests.get('URL-адрес')`.

- BeautifulSoup. Самый популярный инструмент для разбора HTML и XML документов. BeautifulSoup создает из HTML-кода объектное дерево, по которому можно легко осуществлять поиск нужных тегов и извлекать из них информацию. Библиотека отлично справляется с «неидеальной» разметкой, которую часто можно встретить на реальных сайтах.

- Scrapy. Это не просто библиотека, а полноценный фреймворк для создания сложных и быстрых «пауков». Scrapy берет на себя управление запросами, обработку ошибок, сохранение результатов и многое другое. Он работает асинхронно, что позволяет обрабатывать множество страниц одновременно, и идеально подходит для крупных проектов по сбору информации.

- Selenium. Этот инструмент нужен для работы с динамическими сайтами, контент которых загружается с помощью JavaScript после первоначальной загрузки страницы. Selenium управляет реальным браузером (Chrome, Firefox), имитируя действия пользователя: клики, прокрутку, заполнение форм. Это замедляет процесс, но позволяет извлекать сведения с самых сложных веб-ресурсов.

Простой пример: извлекаем заголовки новостей

Представим, что нам нужно собрать заголовки статей с вымышленного новостного портала. HTML-структура страницы может выглядеть примерно так, где каждая новость обернута в тег `article` с классом `news-item`, а заголовок находится внутри тега `h3`.

Для решения этой задачи мы будем использовать связку библиотек `requests` и `BeautifulSoup`. Сначала установим их, если они отсутствуют в системе, с помощью менеджера пакетов pip:

pip install requests beautifulsoup4

Далее напишем небольшой скрипт. Он отправит запрос на страницу, разберет HTML и выведет все найденные заголовки в консоль.

import requests

from bs4 import BeautifulSoup

URL = 'http://example-news-site.com'

# Отправляем запрос и получаем HTML

response = requests.get(URL)

# Создаем объект BeautifulSoup для парсинга

soup = BeautifulSoup(response.text, 'html.parser')

# Находим все элементы с тегом 'h3' и классом 'news-title'

all_titles = soup.find_all('h3', class_='news-title')

# Проходимся по списку найденных элементов и выводим их текст

for title in all_titles:

print(title.get_text(strip=True))

Этот простой пример демонстрирует базовую логику работы. Скрипт находит все элементы, соответствующие заданным критериям, и извлекает из них текстовое содержимое, очищая его от лишних пробелов. Результатом будет аккуратный список заголовков.

Юридические и этические аспекты сбора информации

Автоматизированный сбор сведений — мощный инструмент, но его использование требует ответственности. Некорректное применение парсеров может привести к блокировке вашего IP-адреса, а в некоторых случаях — к юридическим последствиям. Важно соблюдать цифровой этикет.

Прежде чем запускать скрапер, всегда проверяйте файл `robots.txt` на целевом сайте (например, `example.com/robots.txt`). В нем владельцы ресурса указывают, какие разделы сайта разрешено или запрещено индексировать автоматизированным программам. Уважение к этим правилам — основа этичного скрапинга.

Другой важный аспект — нагрузка на сервер. Слишком частые запросы от вашего скрипта могут замедлить работу сайта для других пользователей или даже вызвать его сбой. Чтобы этого избежать, делайте паузы между запросами (например, с помощью `time.sleep()`). Не будьте агрессивны в своих действиях. Также стоит обратить внимание на условия использования (Terms of Service) ресурса, где может быть прямо указан запрет на автоматизированный сбор контента. Персональные сведения (имена, телефоны, email) требуют особого обращения в соответствии с законодательством о защите персональных данных.

Где применяется автоматизированный сбор информации

Возможности веб-скрапинга ограничены лишь фантазией. Вот несколько популярных направлений, где эта технология приносит ощутимую пользу:

- Электронная коммерция. Компании отслеживают цены конкурентов, анализируют ассортимент товаров, собирают отзывы покупателей для улучшения собственных продуктов и ценовой стратегии.

- Маркетинг и SEO. Специалисты собирают ключевые слова, анализируют контент конкурентов, отслеживают позиции сайтов в поисковой выдаче и ищут площадки для размещения ссылок.

- Аналитика данных и исследования. Ученые и аналитики агрегируют новости, собирают статистические показатели с государственных порталов, анализируют мнения в социальных сетях для социологических исследований.

- Недвижимость и финансы. Агрегаторы собирают объявления о продаже или аренде жилья с разных площадок. Финансовые аналитики парсят котировки акций и новости для прогнозирования рыночных трендов.

Освоение навыков скрапинга открывает доступ к огромному массиву мировых сведений, превращая интернет в вашу личную базу знаний. Python делает этот процесс доступным, эффективным и масштабируемым, позволяя решать как небольшие личные задачи, так и сложные промышленные проекты. Главное — подходить к процессу вдумчиво и с уважением к ресурсам, которые вы анализируете.