Парсинг строки с чего начать и как применять на практике

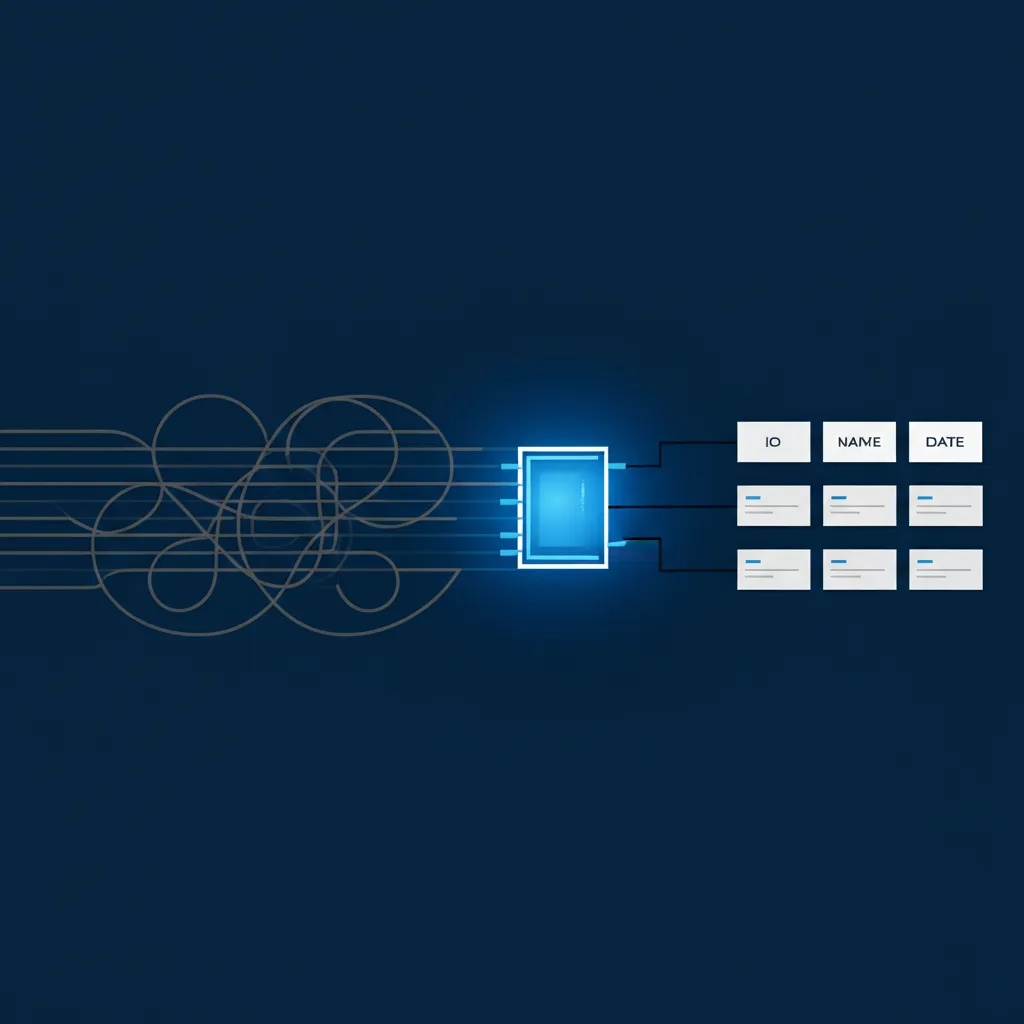

Парсинг строки с — это фундаментальный процесс в программировании, представляющий собой анализ текстовой последовательности символов для извлечения из нее структурированной информации. Представьте, что у вас есть длинное письмо, а вам нужны только номер телефона и имя отправителя. Процедура, которую вы мысленно выполняете для поиска этих сведений, и есть, по сути, парсинг. В цифровом мире эта операция автоматизирована и лежит в основе работы многих систем: от поисковых движков до сложных аналитических платформ. Компьютер получает на вход сплошной массив символов, а на выходе выдает упорядоченные и готовые к использованию фрагменты.

Зачем нужен разбор текстовых данных и где он встречается?

Умение извлекать нужные фрагменты из сплошного потока символов — ключевой навык для автоматизации множества задач. Без этого механизма большая часть цифровой информации оставалась бы бесполезным набором букв и цифр. Преобразование хаоса в порядок позволяет программам понимать и обрабатывать сведения, которые изначально не были для них предназначены. Вот лишь несколько областей, где этот подход незаменим:

- Веб-скрапинг. Автоматический сбор сведений с веб-сайтов — классический пример. Программы-скраперы загружают HTML-код страницы (который является одной большой строкой) и извлекают из него конкретные элементы: цены товаров, заголовки новостей, контактные данные.

- Анализ лог-файлов. Системные администраторы и разработчики ежедневно сталкиваются с логами — текстовыми файлами, куда записываются все события в системе. Чтобы найти причину сбоя, нужно вычленить из тысяч записей сообщения об ошибках, IP-адреса или временные метки.

- Обработка пользовательского ввода. Когда вы вводите команду в терминале или пишете сообщение чат-боту, система анализирует ваше сообщение, чтобы понять, какое действие необходимо выполнить и с какими параметрами.

- Финансовые технологии. Банковские системы часто обрабатывают транзакции, представленные в виде текстовых выписок. Разбор таких записей позволяет автоматически категоризировать расходы и доходы.

- Научные исследования. В биоинформатике, например, анализируются геномные последовательности, которые представляют собой гигантские строки из букв (A, T, G, C), для поиска определённых генов или мутаций.

Основные методы и инструменты для анализа

Существует несколько базовых подходов к извлечению информации. Выбор конкретного метода зависит от сложности структуры исходного текста и конечной цели. Начинающим стоит ознакомиться с самыми распространенными из них.

Одним из простейших способов является разделение по разделителю (delimiter). Этот способ отлично работает, когда данные четко структурированы и элементы отделены друг от друга постоянным символом. Например, в строке "яблоко,банан,апельсин" запятая служит разделителем. Применив операцию разделения, мы получим массив из трех отдельных элементов: ["яблоко", "банан", "апельсин"].

«Превращение неструктурированных данных в структурированные — это не магия, а алгоритм. И парсинг является первым и самым важным шагом в этом алгоритме».

Более мощный и гибкий инструмент — это регулярные выражения (Regular Expressions, или RegEx). Это специальный язык для описания шаблонов поиска в тексте. С помощью RegEx можно найти все email-адреса, номера телефонов определенного формата или любые другие фрагменты, соответствующие заданному правилу. Освоение регулярных выражений требует времени, но значительно расширяет возможности по обработке даже самого запутанного текстового контента.

Кроме того, почти все языки программирования предлагают встроенные функции и сторонние библиотеки, которые упрощают эту задачу. Для работы с HTML и XML существуют специализированные парсеры (например, BeautifulSoup в Python), которые понимают древовидную структуру таких документов и позволяют легко перемещаться по тегам и извлекать их содержимое.

Практический пример: парсинг строки с данными о пользователе

Теория становится понятнее на практике. Давайте разберем конкретный случай. Предположим, у нас есть текстовая запись с информацией о пользователе в нестандартном формате: user_id:951-name:Peter Jones-role:editor. Наша задача — извлечь отсюда идентификатор, имя и роль, чтобы затем использовать эти сведения в программе, например, для отображения в профиле.

- Определение общей структуры. Мы видим, что запись состоит из пар «ключ:значение», которые отделены друг от друга дефисом. Это наша первая зацепка.

- Первичное разделение. Используя дефис как разделитель, мы можем разбить исходную строку на три части: ["user_id:951", "name:Peter Jones", "role:editor"]. Уже стало лучше, но работа еще не закончена.

- Извлечение ключа и значения. Теперь нужно обработать каждый элемент полученного массива. Мы видим, что в каждом из них ключ и значение разделены двоеточием. Применим операцию разделения еще раз для каждого фрагмента. Например, "user_id:951" превратится в ["user_id", "951"].

- Формирование итогового объекта. Проделав это со всеми частями, мы можем собрать результат в удобную структуру, например, в словарь или объект:

{

"id": "951",

"name": "Peter Jones",

"role": "editor"

}

В результате из непонятного набора символов мы получили структурированные сведения, к которым легко обращаться. Теперь программа может запросить имя пользователя (user.name) или его роль (user.role) без необходимости повторного анализа всей последовательности.

Распространенные сложности и пути их решения

На пути автоматического анализа текста часто возникают трудности. Одна из главных проблем — неконсистентность формата. Источник может внезапно поменять разделители, добавить лишние пробелы или изменить порядок полей. Чтобы защититься от этого, следует писать более гибкие алгоритмы, которые предусматривают возможные вариации, и всегда проверять (валидировать) полученный результат.

«Принцип "Garbage in, garbage out" (Мусор на входе — мусор на выходе) особенно актуален при работе с данными. Качество парсинга напрямую определяет качество всей последующей аналитики».

Еще одна сложность — специальные символы и кодировки. Неправильная обработка кодировок (например, UTF-8) может привести к тому, что кириллические символы или эмодзи превратятся в нечитаемые знаки. Важно с самого начала убедиться, что ваша программа корректно работает с нужной кодировкой. Наконец, при работе с большими объемами информации встает вопрос производительности. Неэффективный алгоритм может обрабатывать гигабайты логов часами. В таких случаях оптимизируют код и используют специализированные инструменты, рассчитанные на высокую нагрузку.

Будущее анализа текста и роль искусственного интеллекта

Традиционные методы отлично справляются с относительно структурированным текстом. Однако для анализа естественного языка — отзывов, электронных писем, статей — требуются более продвинутые технологии. Здесь на сцену выходят обработка естественного языка (NLP) и машинное обучение. Современные нейросетевые модели способны понимать контекст, выделять сущности (имена, организации, даты), определять тональность высказывания и даже извлекать сложные взаимосвязи из сплошного повествования. Это уже не просто механическое разделение по символам, а осмысленный анализ контента, открывающий новые горизонты в аналитике и автоматизации.