Парсинг текста

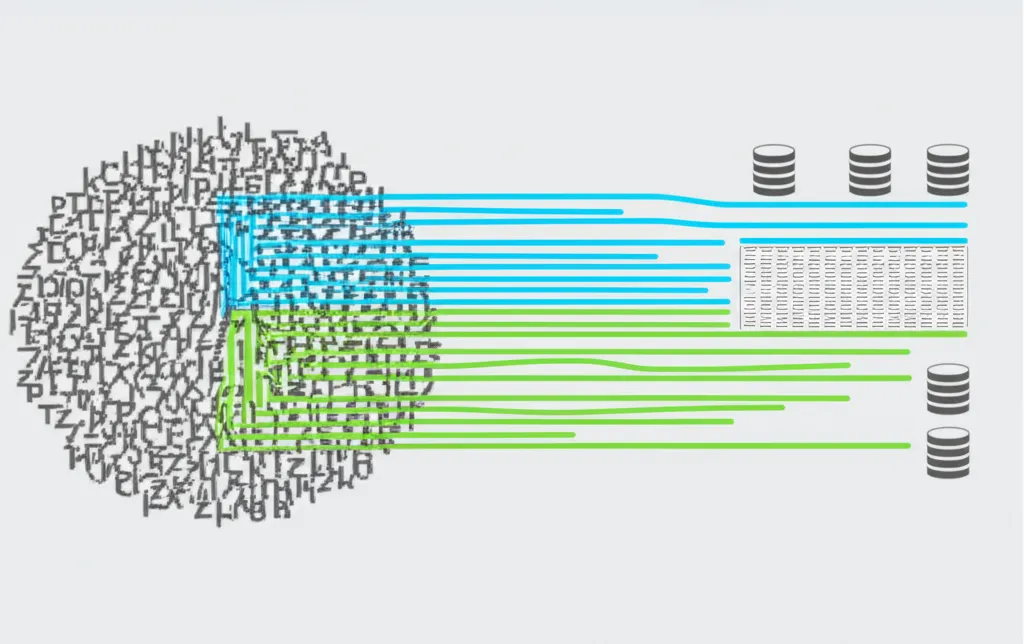

Парсинг текста — это автоматизированный процесс анализа и извлечения структурированных данных из неструктурированного текстового контента. Представьте, что у вас есть огромная библиотека, а вам нужно найти все книги по астрофизике, написанные в XXI веке. Вы можете просмотреть каждую книгу вручную, а можете поручить эту задачу роботу, который мгновенно просканирует весь каталог и выдаст готовый список. В цифровом мире именно эту функцию выполняет разбор информации: он превращает хаотичный набор символов в упорядоченные и полезные сведения.

Эта технология лежит в основе многих современных сервисов. Когда вы ищете товар по самой низкой цене в агрегаторе, он использует методы извлечения, чтобы собрать информацию с десятков сайтов. Когда поисковая система анализирует миллионы страниц, чтобы выдать вам релевантный ответ, она также применяет сложнейшие алгоритмы анализа контента. Понимание этого процесса открывает огромные возможности для бизнеса, аналитики и исследований.

Ключевые этапы извлечения данных

Процесс преобразования сырого набора символов в структурированную информацию можно условно разделить на несколько последовательных шагов. Хотя конкретная реализация зависит от задачи и используемых инструментов, общая логика остается схожей.

Лексический анализ (токенизация)

Первый и фундаментальный этап — это разделение сплошного потока символов на минимальные смысловые единицы, называемые токенами. Токенами могут быть слова, числа, знаки препинания или даже отдельные символы. Этот шаг подобен тому, как мы при чтении неосознанно разделяем строку на отдельные слова.

Например, предложение «Цена товара: 499.99 рублей.» после токенизации превратится в следующий набор элементов:

- Цена

- товара

- :

- 499.99

- рублей

- .

Качественная токенизация — основа для дальнейшего успешного анализа. Ошибки на этом этапе, например, неправильное разделение составных слов или дат, могут привести к некорректному извлечению сведений на последующих стадиях.

Синтаксический анализ

После того как текст разбит на токены, необходимо понять, как они связаны друг с другом. Синтаксический анализ определяет грамматическую структуру предложения. Он выстраивает иерархические связи между словами, определяя подлежащее, сказуемое, дополнения и другие члены предложения. Результатом этого этапа часто является так называемое «дерево разбора», которое наглядно показывает структуру фразы.

Этот этап позволяет программе понять контекст. Например, в предложении «Компания X купила стартап Y» синтаксический анализатор определит, что «Компания X» является субъектом действия, а «стартап Y» — объектом. Это критически важно для точного извлечения фактов.

Семантический анализ и извлечение сущностей

Финальный этап — это придание смысла разобранной структуре. Здесь программа определяет конкретные сущности (Named-entity recognition, NER) и связи между ними. Сущностями могут быть:

- Имена людей и названия организаций.

- Географические локации (города, страны).

- Даты и время.

- Числовые значения (цены, количество, проценты).

- Контактные данные (email, телефоны).

Возвращаясь к нашему примеру о покупке стартапа, семантический анализ не просто поймет структуру, но и классифицирует «Компания X» и «стартап Y» как организации, а глагол «купила» определит как отношение «приобретения». В результате мы получаем структурированный факт: {покупатель: 'Компания X', объект: 'стартап Y', действие: 'покупка'}.

Информация — это нефть XXI века, а аналитика — это двигатель внутреннего сгорания. – Питер Сондергаард

Инструменты и подходы к реализации

Существует множество способов реализовать извлечение информации, от написания простых скриптов до использования сложных систем машинного обучения. Выбор зависит от сложности задачи, объема данных и требуемой точности.

Регулярные выражения (Regular Expressions)

Это мощный инструмент для поиска и извлечения данных по шаблону. Регулярные выражения идеально подходят для работы с хорошо структурированными форматами, где нужная информация всегда имеет одинаковый вид. Например, с их помощью легко найти в документе все email-адреса, номера телефонов или почтовые индексы.

Однако их возможности ограничены при работе со сложным, вариативным естественным языком. Попытка описать все возможные грамматические конструкции с помощью «регулярок» быстро становится невыполнимой задачей.

Специализированные библиотеки и фреймворки

Для более сложных задач разработчики используют готовые программные библиотеки. В экосистеме языка Python, например, есть множество популярных решений:

- BeautifulSoup и lxml: Идеальны для разбора HTML и XML документов. Они позволяют легко навигироваться по структуре веб-страницы и извлекать содержимое конкретных тегов.

- Scrapy: Полноценный фреймворк для веб-скрапинга, который не только парсит страницы, но и управляет процессом обхода сайтов, очередью запросов и сохранением результатов.

- NLTK и spaCy: Мощные библиотеки для обработки естественного языка (NLP), которые содержат готовые модели для токенизации, синтаксического анализа и извлечения именованных сущностей на разных языках.

Готовые сервисы и платформы

Для компаний, не имеющих ресурсов на собственную разработку, существуют облачные сервисы (Parser-as-a-Service). Такие платформы предоставляют визуальный интерфейс, где можно настроить правила извлечения данных без написания кода, или предлагают API для интеграции в свои продукты. Это ускоряет процесс сбора данных, но может быть менее гибким и более затратным решением в долгосрочной перспективе.

Практическое применение в бизнесе и науке

Сферы, где автоматизированный сбор сведений приносит пользу, практически безграничны. Он позволяет превратить огромные объемы неструктурированной информации в ценные инсайты.

Маркетинг и конкурентный анализ

Маркетологи используют парсеры для мониторинга цен конкурентов, сбора отзывов о продуктах с различных площадок, анализа контент-стратегий и отслеживания упоминаний бренда в социальных сетях и новостях. Это дает возможность оперативно реагировать на изменения рынка.

Электронная коммерция

Владельцы интернет-магазинов автоматизируют наполнение каталогов товаров, собирая описания и характеристики с сайтов производителей. Также скрапинг помогает отслеживать наличие товаров у поставщиков и поддерживать актуальность ассортимента.

Научные исследования

Ученые применяют анализ контента для обработки больших корпусов научных статей, исторических документов или литературных произведений. Это помогает выявлять закономерности, отслеживать эволюцию терминологии и проводить масштабные мета-анализы, недоступные при ручной обработке.

Финансовая аналитика

В финансовом секторе парсеры используются для анализа новостных лент, отчетов компаний и настроений в социальных сетях для прогнозирования движения котировок. Алгоритмический трейдинг часто опирается на данные, полученные путем автоматического разбора текстовых источников в реальном времени.

Этические и правовые вопросы

Несмотря на всю пользу, сбор данных с чужих ресурсов требует ответственного подхода. Перед запуском любого парсера необходимо учитывать несколько важных моментов.

Во-первых, всегда проверяйте файл `robots.txt` на целевом сайте. В нем владельцы ресурса указывают, какие разделы сайта можно сканировать роботам, а какие — нельзя. Игнорирование этих правил является нарушением сетевого этикета.

Во-вторых, уважайте условия использования (Terms of Service) сайта. Многие ресурсы прямо запрещают автоматизированный сбор информации. Нарушение этих правил может привести к блокировке вашего IP-адреса или даже к юридическим последствиям.

И, наконец, избегайте создания чрезмерной нагрузки на сервер. Настройте задержки между запросами, чтобы ваш парсер не мешал работе сайта для обычных пользователей. Чрезмерная активность может быть расценена как DDoS-атака. Ответственный подход к сбору данных — ключ к долгосрочной и продуктивной работе.