Q парсер: что это и как он автоматизирует сбор данных

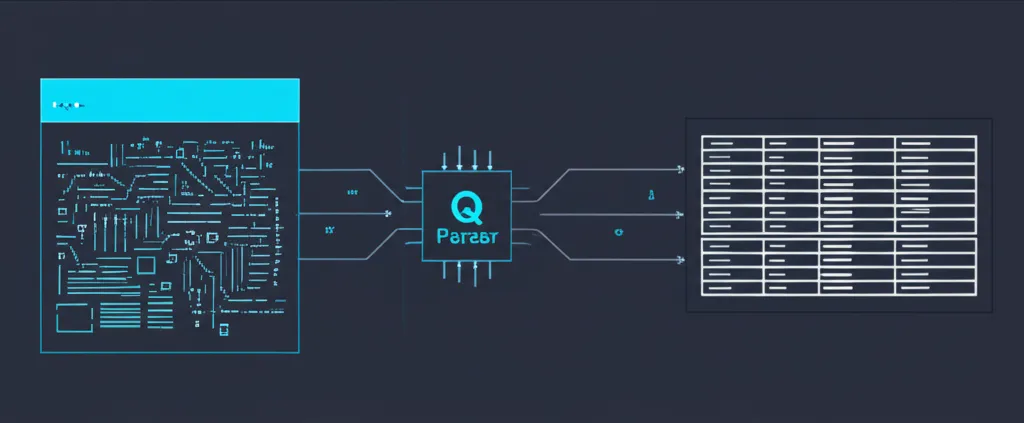

Q парсер представляет собой инструмент для автоматического извлечения информации с веб-страниц и других источников. Если говорить проще, это программа, которая заходит на указанный сайт, находит нужные сведения (например, названия товаров, цены, описания) и сохраняет их в удобном формате, таком как таблица Excel или база данных. Этот процесс, известный как парсинг или веб-скрейпинг, позволяет за минуты получать объемы информации, на ручной сбор которых ушли бы недели. Основная задача такого решения — трансформация хаотичного веб-контента в структурированные и готовые к анализу материалы.

Представьте, что вам нужно составить список всех ноутбуков с определенного маркетплейса с их ценами и характеристиками. Вручную вы бы открывали каждую карточку товара, копировали информацию и вставляли ее в таблицу. Q парсер делает то же самое, но автоматически и с огромной скоростью, следуя заданным правилам. Это открывает широкие возможности для анализа рынка, мониторинга конкурентов и автоматизации множества бизнес-процессов, ранее требовавших монотонного человеческого труда.

Принцип работы: от запроса до структурированных сведений

Чтобы понять ценность парсинга, полезно разобраться в его механике. Процесс извлечения информации можно условно разделить на несколько ключевых этапов, которые выполняет любая подобная программа. Каждый шаг логически вытекает из предыдущего, создавая конвейер по обработке веб-страниц.

- Отправка запроса. Программа обращается к целевому веб-ресурсу по его URL-адресу, имитируя запрос обычного браузера. В ответ сервер сайта отдает исходный код страницы в формате HTML.

- Получение и обработка кода. Полученный HTML-код содержит всю структуру и контент страницы: тексты, ссылки, изображения. Инструмент анализирует эту структуру, чтобы найти нужные элементы.

- Извлечение элементов. На этом этапе программа, используя специальные селекторы (например, XPath или CSS-селекторы), находит в коде конкретные блоки. Это могут быть заголовок статьи, стоимость продукта, контактный телефон или любой другой фрагмент.

- Структурирование и сохранение. Извлеченные фрагменты очищаются от лишних тегов и организуются в логическую структуру. Например, название товара помещается в колонку «Название», а его цена — в колонку «Цена». Готовые сведения сохраняются в выбранном формате: CSV, JSON, XLSX или напрямую в базу данных для дальнейшего использования.

Весь этот цикл может повторяться для тысяч страниц, обеспечивая непрерывный поток актуальной информации без ручного вмешательства. Современные решения также умеют обходить базовые защиты от парсинга, работать с динамическими сайтами и распределять нагрузку.

Сферы применения: где парсинг приносит пользу

Автоматизированный сбор информации находит применение практически в любой отрасли, где решения принимаются на основе анализа больших объемов сведений. Эффективность инструмента напрямую зависит от поставленной задачи.

- Электронная коммерция. Владельцы интернет-магазинов используют парсинг для мониторинга цен конкурентов, отслеживания появления новых товаров в их ассортименте, сбора отзывов о продуктах для анализа потребительского мнения и наполнения собственных каталогов контентом.

- Маркетинг и SEO. Маркетологи собирают контактные данные для расширения клиентской базы, анализируют контент-стратегии конкурентов, отслеживают упоминания бренда в сети и собирают ключевые слова для поисковой оптимизации.

- Финансы и инвестиции. Аналитики парсят новостные порталы для отслеживания событий, влияющих на фондовый рынок, собирают финансовые отчеты компаний и котировки акций в реальном времени.

- Рынок труда (HR). Рекрутеры автоматизируют поиск резюме на работных сайтах по заданным критериям, чтобы быстрее находить подходящих кандидатов на открытые вакансии.

- Научные исследования. Ученые и исследователи используют парсинг для сбора больших наборов данных из открытых источников для проведения статистического анализа, например, в социологии или лингвистике.

«Без данных вы просто еще один человек с мнением». Эта цитата, приписываемая Эдвардсу Демингу, идеально описывает современный подход к ведению бизнеса. Автоматизированный сбор информации — это первый шаг к принятию обоснованных, а не интуитивных решений.

Виды парсеров: от простых скриптов до комплексных платформ

Инструменты для извлечения веб-информации сильно различаются по сложности, функциональности и требованиям к пользователю. Выбор конкретного решения зависит от масштаба задачи и технических навыков специалиста.

Десктопные программы — это приложения, которые устанавливаются на компьютер. Они часто имеют графический интерфейс, что упрощает настройку. Пользователь в визуальном режиме указывает, какие элементы на странице нужно извлечь. Такие программы хорошо подходят для небольших и средних задач.

Облачные сервисы — это веб-платформы, которые работают через браузер. Вся инфраструктура для парсинга находится на стороне провайдера. Это избавляет от необходимости использовать мощности своего компьютера, позволяет настраивать сбор по расписанию и легко масштабировать процесс. Идеальный вариант для регулярного мониторинга и обработки больших объемов сайтов.

Самописные скрипты — это код, написанный разработчиком на языках программирования вроде Python с использованием библиотек (например, BeautifulSoup или Scrapy). Такой подход дает максимальную гибкость в настройке, но требует глубоких технических знаний. Он используется для решения нестандартных и сложных задач.

Юридические и этические аспекты

При использовании парсеров важно помнить о правовой и этической стороне вопроса. Не всю информацию можно собирать и использовать свободно. Прежде чем запускать сбор, необходимо обратить внимание на несколько моментов.

- Файл robots.txt. Это текстовый файл в корневом каталоге сайта, в котором веб-мастера указывают, какие разделы сайта не следует индексировать и парсить автоматическим программам. Игнорирование этих правил считается плохим тоном.

- Пользовательское соглашение. Многие ресурсы в своих правилах (Terms of Service) прямо запрещают автоматизированный сбор сведений. Нарушение этих условий может привести к блокировке вашего IP-адреса.

- Персональные данные. Сбор и обработка личной информации (имена, телефоны, email) регулируются законодательством, например, ФЗ-152 в России или GDPR в Европе. Использование таких сведений без согласия владельцев незаконно.

- Нагрузка на сервер. Слишком частые и агрессивные запросы могут создавать избыточную нагрузку на сервер сайта, замедляя его работу или даже приводя к сбою. Ответственный парсинг подразумевает установку пауз между запросами, чтобы не вредить целевому ресурсу.

Таким образом, ключ к успешному и безопасному парсингу — это соблюдение баланса между получением нужных материалов и уважением к правилам и ресурсам веб-сайтов.