Руководство по распределенному веб-краулингу: масштабируем сбор данных

Это подробное руководство по распределенному веб-краулингу предназначено для разработчиков и аналитиков, столкнувшихся с ограничениями обычных парсеров. Когда требуется эффективно собирать информацию с тысяч или миллионов веб-ресурсов, стандартные подходы перестают работать. Веб-скрапинг, или сканирование страниц, является процессом автоматического обхода сайтов для извлечения сведений. Когда объемы исчисляются терабайтами, одиночный скрипт не справляется. Здесь на помощь приходит распределенная архитектура, позволяющая параллельно обрабатывать задачи на множестве машин и преодолевать технические барьеры.

Что такое веб-краулинг и зачем он нужен?

Веб-краулер, также известный как паук или бот, — это программа, которая систематически обходит веб-страницы, переходит по ссылкам и собирает контент. Самый известный пример — поисковые системы. Их роботы постоянно сканируют интернет, чтобы индексировать новые материалы и обновлять информацию о существующих. Однако область применения технологии гораздо шире. Компании используют скрапинг для решения множества бизнес-задач:

- Мониторинг цен конкурентов в электронной коммерции для динамического ценообразования.

- Сбор больших наборов сведений для обучения моделей машинного обучения (ML).

- Анализ упоминаний бренда в новостных изданиях и социальных сетях.

- Агрегация вакансий, объявлений о недвижимости или новостей с различных порталов.

- Исследование рынка и выявление трендов на основе публичной информации.

Простой парсер может отлично справиться с задачей сбора информации с одного или нескольких порталов. Но что делать, когда нужно обойти целый сегмент сети, посвященный определенной тематике, и делать это постоянно?

Ограничения централизованного подхода

Одиночный скрипт, запущенный на одном сервере, имеет несколько фундаментальных ограничений, которые делают его непригодным для масштабных проектов. Во-первых, это низкая скорость. Пропускная способность сети и вычислительная мощность машины конечны. Вы не сможете отправлять миллионы запросов в секунду. Во-вторых, низкая надежность. Если сервер выйдет из строя или потеряет сетевое подключение, весь процесс сбора остановится, и часть прогресса может быть утеряна. В-третьих, высокая вероятность блокировки. Веб-ресурсы активно защищаются от агрессивного парсинга и блокируют IP-адреса, с которых поступает слишком много обращений за короткий промежуток времени.

Ключевые принципы распределенной архитектуры

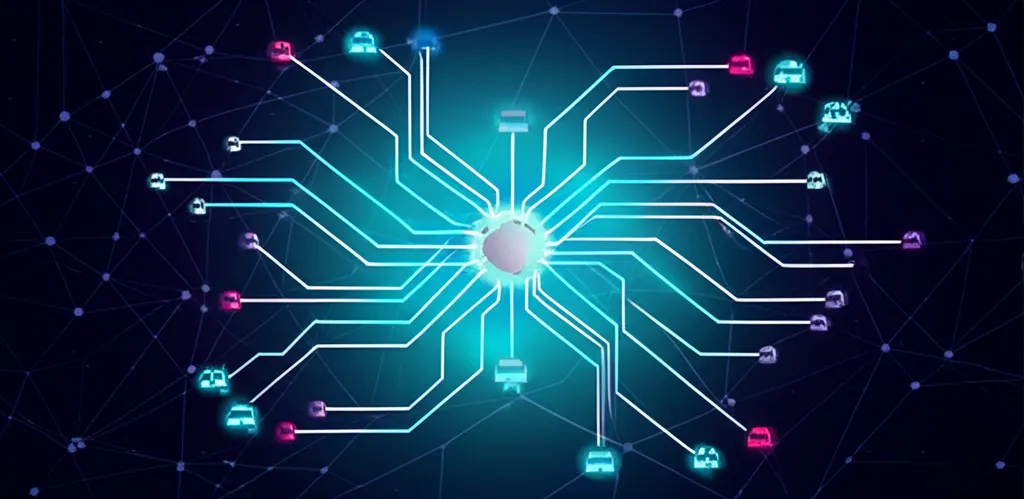

Распределенный подход решает перечисленные проблемы, разделяя одну огромную задачу на тысячи маленьких, которые выполняются параллельно на разных машинах (воркерах). Это позволяет горизонтально масштабировать систему, просто добавляя новые вычислительные узлы. Типичная архитектура распределенного краулера состоит из нескольких ключевых компонентов:

- Менеджер очередей (URL Frontier). Это центральный элемент, который хранит список URL-адресов, ожидающих сканирования. Он отвечает за приоритизацию ссылок, фильтрацию дубликатов и предотвращение повторного обхода одних и тех же страниц. В качестве менеджера часто выступают брокеры сообщений, такие как RabbitMQ или Apache Kafka.

- Пул воркеров (Workers). Это независимые процессы или машины, которые получают URL из очереди, загружают страницу, извлекают нужную информацию и находят новые ссылки для добавления в очередь. Каждый воркер работает автономно, что обеспечивает высокую степень параллелизма.

- Хранилище данных (Data Storage). Место, куда воркеры складывают извлеченные сведения. Это может быть реляционная база (PostgreSQL), NoSQL-хранилище (MongoDB), полнотекстовый поисковый движок (Elasticsearch) или файловая система для хранения HTML-копий страниц.

- Координатор (Scheduler/Coordinator). Опциональный компонент, который управляет всем процессом: запускает и останавливает воркеры, отслеживает их состояние, ведет статистику и обрабатывает ошибки.

Такая модульная структура обеспечивает гибкость и отказоустойчивость. Если один из воркеров выходит из строя, остальные продолжают работу, а его задача будет переназначена другому свободному исполнителю.

Технологический стек для реализации

Для создания распределенного краулера можно использовать различные комбинации технологий. Одним из самых популярных стеков является связка на основе Python благодаря его богатой экосистеме библиотек для веб-скрапинга и сетевого взаимодействия.

- Язык программирования: Python — стандарт де-факто для задач сбора информации.

- Фреймворк для краулинга: Scrapy предоставляет мощную асинхронную основу для написания пауков. Его можно интегрировать с другими компонентами для создания распределенного решения (например, с помощью `scrapy-cluster` или `scrapy-redis`).

- Брокер сообщений: RabbitMQ (проще в настройке) или Apache Kafka (более производительный для очень больших объемов) для организации очереди URL.

- Фреймворк для распределенных задач: Celery отлично интегрируется с Python и брокерами сообщений, позволяя легко управлять пулом воркеров.

- База данных: Выбор зависит от структуры извлекаемых сведений. MongoDB подходит для гибких, слабоструктурированных документов, а PostgreSQL — для реляционных данных, требующих строгой схемы.

Основные вызовы и методы их решения

Создание масштабируемой системы сбора информации сопряжено с рядом сложностей. Просто запустить сотни воркеров недостаточно — нужно продумать стратегию их работы.

Борьба с блокировками

Это одна из главных проблем. Сайты используют различные механизмы для обнаружения и блокировки ботов. Чтобы обходить защиту, применяют следующие техники:

- Использование прокси-серверов. Ротация IP-адресов через пул прокси (резидентных, мобильных или серверных) позволяет каждому воркеру отправлять запросы с уникального адреса, маскируя активность.

- Управление User-Agent. Необходимо использовать реалистичные заголовки User-Agent, имитирующие популярные браузеры, и периодически их менять.

- Контроль скорости. Важно соблюдать «вежливость»: ограничивать частоту обращений к одному домену, чтобы не создавать избыточную нагрузку на сервер. Это также помогает избежать блокировок по поведенческому фактору.

Соблюдение правил и этики

Перед сканированием любого ресурса необходимо изучить его файл `robots.txt`. В нем владельцы сайтов указывают, какие разделы можно и нельзя индексировать автоматическим программам. Игнорирование этих правил не только неэтично, но и может привести к юридическим последствиям. Всегда старайтесь минимизировать нагрузку на целевые серверы.

Обработка ошибок и отказоустойчивость

Сеть — нестабильная среда. Серверы могут быть недоступны, соединения могут обрываться. Ваша система должна быть готова к этому. Задачи, завершившиеся ошибкой (например, из-за тайм-аута), следует возвращать в очередь для повторного выполнения через некоторое время. Это обеспечивает полноту сбора даже при временных сбоях.

Анализ производительности и масштабирование

Для оценки эффективности распределенного краулера используются метрики, такие как количество загруженных страниц в секунду (PPS) и объем извлеченной информации за единицу времени. Если производительность недостаточна, архитектура позволяет легко ее увеличить. Горизонтальное масштабирование достигается добавлением новых машин-воркеров в пул. Благодаря брокеру сообщений, новые исполнители автоматически начнут получать задачи из общей очереди, пропорционально увеличивая общую скорость работы. Мониторинг загрузки CPU, использования памяти и пропускной способности сети на каждом узле поможет выявить узкие места и оптимизировать распределение ресурсов для дальнейшего роста.