Серверный скрапинг с Scrapy и AWS

Серверный скрапинг с Scrapy и AWS представляет собой мощную комбинацию для автоматизации сбора больших объемов информации из интернета. Когда локальных ресурсов компьютера становится недостаточно, а задачи требуют стабильности и масштабируемости, перенос процессов в облачную инфраструктуру становится логичным шагом. Этот подход позволяет обойти ограничения, связанные с IP-адресами, производительностью и необходимостью круглосуточной работы оборудования. Использование фреймворка Scrapy на виртуальных машинах Amazon Web Services открывает практически безграничные возможности для извлечения ценных сведений.

Основы веб-скрапинга: зачем это нужно бизнесу?

Веб-скрапинг (или парсинг) — это технология автоматического извлечения информации с веб-страниц. Вместо ручного копирования контента специальная программа, называемая «пауком» или «краулером», обходит сайты и собирает нужные элементы в структурированном виде, например, в таблицу или базу. Сферы применения огромны:

- Мониторинг цен: интернет-магазины отслеживают стоимость товаров у конкурентов, чтобы формировать конкурентоспособные предложения.

- Анализ рынка: компании собирают отзывы о продуктах, анализируют ассортимент конкурентов или отслеживают упоминания бренда.

- Генерация лидов: сбор контактной информации с тематических порталов и каталогов для отделов продаж.

- Агрегация контента: новостные агрегаторы, сайты с вакансиями или площадки по недвижимости собирают объявления с множества источников в одном месте.

Автоматизированный сбор позволяет получать актуальную информацию быстро и в больших объемах, что дает серьезное конкурентное преимущество.

Ключевые инструменты: краткий обзор

Успешная реализация проекта зависит от правильного выбора технологий. В нашей связке два главных компонента — Scrapy и AWS, каждый из которых выполняет свою уникальную роль.

Что такое Scrapy?

Scrapy — это высокоуровневый фреймворк для веб-скрапинга и веб-краулинга, написанный на Python. Он предоставляет разработчикам готовую архитектуру для создания «пауков». Его главные преимущества:

- Асинхронность: Scrapy построен на асинхронной библиотеке Twisted, что позволяет ему отправлять множество запросов одновременно, не дожидаясь ответа на каждый из них. Это кардинально ускоряет процесс сбора.

- Расширяемость: Фреймворк имеет модульную структуру. Можно легко добавлять собственные компоненты (middlewares, pipelines) для обработки запросов, ответов и собранных элементов.

- Встроенные механизмы: Он включает инструменты для работы с cookies, сессиями, user-agents, а также позволяет легко извлекать информацию с помощью CSS-селекторов и XPath.

Возможности облака AWS

Amazon Web Services (AWS) — это глобальная облачная платформа, предоставляющая широкий спектр сервисов. Для задач скрапинга наиболее актуальны следующие:

- EC2 (Elastic Compute Cloud): Виртуальные серверы, на которых будет работать наш код. Можно выбрать конфигурацию машины под любые требования к производительности.

- S3 (Simple Storage Service): Объектное хранилище для собранной информации. Оно отличается высокой надежностью, низкой стоимостью и практически бесконечной масштабируемостью.

- IAM (Identity and Access Management): Сервис для безопасного управления доступом к ресурсам AWS.

- CloudWatch: Система мониторинга, которая позволяет отслеживать работу серверов и настраивать оповещения.

Перенос скрапинга в облако — это не просто смена локации. Это переход к совершенно новому уровню надежности, гибкости и производительности, недостижимому на локальной машине.

Практическая реализация: Серверный скрапинг с Scrapy и AWS

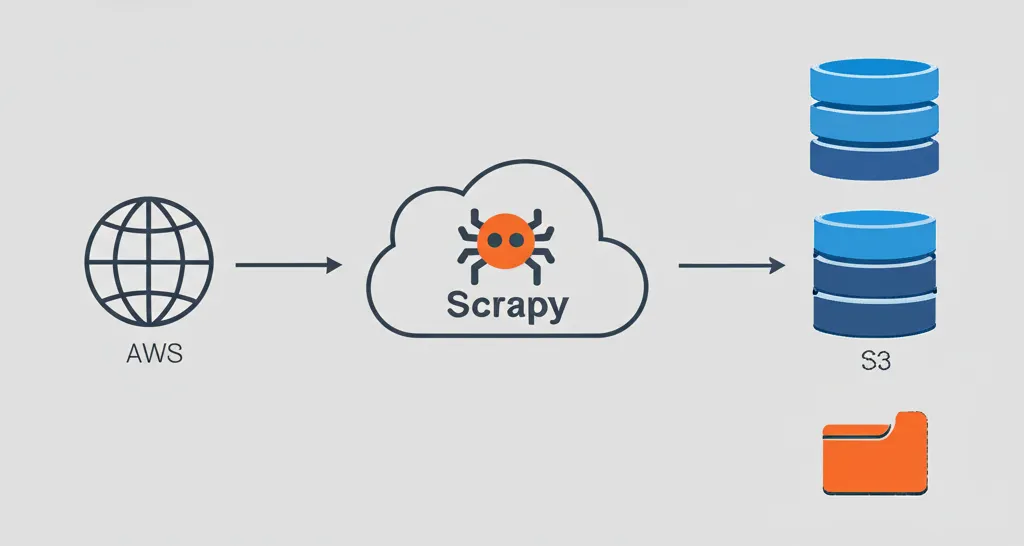

Рассмотрим, как выглядит типичная архитектура и процесс развертывания проекта по сбору информации в облаке Amazon. Этот процесс решает ключевые проблемы локального подхода: блокировки по IP, нехватку ресурсов и сложности с круглосуточной работой.

Архитектура облачного решения

Простая, но эффективная схема работы может выглядеть так:

- Виртуальный сервер EC2: На инстансе (виртуальной машине) EC2 устанавливается операционная система (например, Ubuntu), Python и все необходимые библиотеки, включая Scrapy. Здесь будет размещен и запущен код нашего «паука».

- Запуск по расписанию: С помощью стандартного планировщика Cron задача по запуску скрапера настраивается на регулярное выполнение — например, раз в сутки или каждый час.

- Процесс сбора: «Паук» Scrapy отправляет запросы к целевым сайтам. Чтобы избежать блокировок, часто используются ротируемые прокси-серверы, которые подменяют IP-адрес для каждого запроса.

- Хранение результатов: Собранные сведения не сохраняются на диске виртуальной машины. Вместо этого они напрямую отправляются в хранилище AWS S3. Это делает систему отказоустойчивой: даже если сервер EC2 выйдет из строя, информация останется в сохранности.

Настройка окружения на сервере EC2

Первый шаг — создание и настройка виртуального сервера. В консоли AWS нужно запустить новый инстанс EC2, выбрав подходящий образ ОС (например, Ubuntu Server). После подключения к серверу по SSH необходимо выполнить базовую настройку: обновить пакеты, установить Python, менеджер пакетов pip и Git. Затем устанавливается сам фреймворк и библиотека Boto3 для взаимодействия с сервисами Amazon из кода Python.

Важным этапом является настройка прав доступа. Вместо того чтобы хранить ключи доступа AWS в коде, создается IAM-роль с политикой, разрешающей запись в нужный S3-бакет, и эта роль присваивается инстансу EC2. Такой подход гораздо безопаснее.

Масштабирование и отказоустойчивость

Прелесть облачного подхода в его гибкости. Если объемы информации растут, можно легко улучшить систему.

- Вертикальное масштабирование: Не хватает мощности одного сервера? В любой момент можно изменить тип инстанса EC2 на более производительный с большим количеством ядер процессора и оперативной памяти.

- Горизонтальное масштабирование: Для очень больших задач можно запустить несколько инстансов EC2, которые будут работать параллельно. В этом случае для координации их работы используют системы очередей, например, Scrapy-Redis или AWS SQS.

- Надежные прокси: Использование пула качественных ротируемых прокси-серверов — обязательное условие для стабильного сбора информации с хорошо защищенных ресурсов.

Этические и юридические аспекты

Автоматизированный сбор информации требует ответственного подхода. Несоблюдение правил может привести к блокировке IP-адреса, а в некоторых случаях — к юридическим последствиям. Ключевые принципы этичного скрапинга:

- Изучите файл `robots.txt`: Большинство сайтов размещают этот файл в корне, указывая, какие разделы можно и нельзя сканировать ботам. Всегда следуйте этим правилам.

- Не создавайте избыточную нагрузку: Настройте задержки между запросами в Scrapy (параметр `DOWNLOAD_DELAY`), чтобы не перегружать сервер целевого сайта. Ведите себя как вежливый гость.

- Уважайте условия использования: Ознакомьтесь с Terms of Service сайта. Некоторые ресурсы прямо запрещают автоматизированный сбор информации.

- Не собирайте персональные сведения: Сбор и обработка персональной информации регулируются законодательством (например, GDPR). Избегайте этого без явного разрешения.

Комбинация Scrapy и AWS предоставляет разработчикам и бизнесу надежный инструмент для решения задач по сбору информации любого масштаба. Гибкость облачной платформы позволяет начать с малого и расти по мере увеличения потребностей, оплачивая только те ресурсы, которые действительно используются. Это делает технологию доступной не только для крупных корпораций, но и для небольших стартапов.