Тестовые датасеты

Тестовые датасеты представляют собой наборы информации, которые используются на заключительном этапе разработки модели машинного обучения или программного обеспечения. Представьте, что вы готовите ученика к экзамену. Сначала он изучает учебники (обучающая выборка), затем решает пробные тесты (валидационная выборка), чтобы настроить процесс запоминания. А тестовый набор — это и есть тот самый финальный экзамен, который он видит впервые. Его результаты объективно показывают, насколько хорошо ученик усвоил материал и готов ли он применять знания в реальных условиях. Основная цель — получить беспристрастную оценку производительности алгоритма на совершенно новых, ранее не виданных им примерах.

Зачем нужны наборы информации для тестирования?

Главная задача тестовой выборки — имитация реального мира. Когда модель обучается, она может просто «зазубрить» ответы из учебных материалов, но оказаться бесполезной при столкновении с новыми задачами. Это явление называется переобучением (overfitting). Использование отдельного, «неприкосновенного» набора для проверки помогает выявить эту проблему. Если алгоритм показывает высокую точность на обучающих примерах, но проваливается на тестовых, это явный сигнал о переобучении. Таким образом, финальная проверка гарантирует, что созданный продукт будет надежно работать не только в лабораторных условиях, но и после запуска.

Качество предсказания напрямую зависит от качества информации, на которой оно основано. Мусор на входе — мусор на выходе. Тестовый набор является последним рубежом контроля перед тем, как модель столкнется с реальностью.

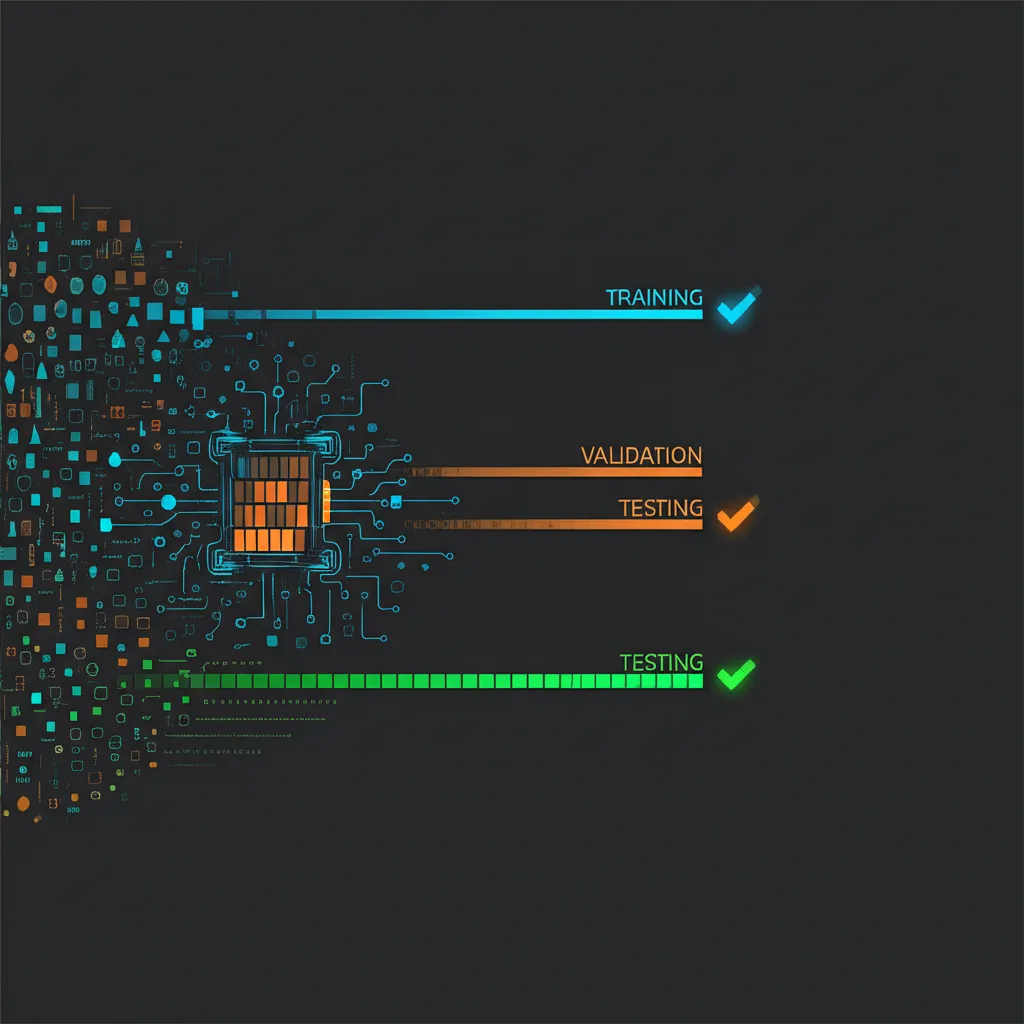

Ключевые отличия: обучающая, валидационная и тестовая выборки

Весь исходный массив информации принято разделять на три части, каждая из которых выполняет свою уникальную функцию. Понимание их ролей критически важно для корректного построения и оценки моделей.

- Обучающая выборка (Training Set). Это самая большая часть, обычно около 60-80% от всего объема. На этих примерах алгоритм учится находить закономерности, выстраивать внутренние связи и подбирать веса. Это его «учебник» и «конспекты».

- Валидационная выборка (Validation Set). Составляет примерно 10-20% от общего массива. Она используется в процессе обучения для тонкой настройки параметров модели (гиперпараметров). Алгоритм периодически проверяется на валидационных примерах, чтобы разработчик мог скорректировать его работу, не «подглядывая» в финальный экзамен. Это «пробные тесты».

- Тестовая выборка (Test Set). Оставшиеся 10-20%. Этот набор используется всего один раз — в самом конце, когда модель полностью обучена и настроена. Он не должен пересекаться с первыми двумя и служит для получения итоговой, независимой оценки качества. Это «государственный экзамен», результаты которого и идут в отчет.

Смешивать эти наборы или использовать тестовый для настройки — грубейшая ошибка, которая приводит к созданию неработоспособных решений. Модель просто запомнит «правильные ответы» и не сможет обобщать.

Как правильно формировать тестовые датасеты

Качество финальной оценки напрямую зависит от того, насколько грамотно составлен тестовый набор. Существует несколько фундаментальных принципов, которым необходимо следовать при его формировании. Несоблюдение этих правил может привести к ложному чувству уверенности в продукте, который на самом деле не готов к работе с реальными задачами. Рассмотрим основные критерии качества.

Критерии качества для набора проверки

Чтобы оценка была объективной, тестовый материал должен обладать определенными свойствами. Эти характеристики гарантируют, что полученные метрики (например, точность) будут отражать реальную производительность алгоритма.

- Репрезентативность. Выборка должна отражать общую популяцию, с которой модели предстоит работать. Если вы создаете систему распознавания кошек, а в тестовом наборе будут только рыжие коты, то на черных или белых она может работать плохо. В наборе должны быть представлены все классы и типы примеров в тех же пропорциях, что и в реальном мире.

- Независимость. Ни один пример из тестового набора не должен присутствовать в обучающей или валидационной выборках. Любое пересечение — это «утечка» информации, которая искусственно завышает итоговые метрики.

- Достаточный объем. Слишком маленький набор не даст статистически значимой оценки. Результат может оказаться случайным. Размер должен быть достаточным, чтобы минимизировать влияние случайных колебаний на итоговую метрику.

- Разнообразие. Кроме пропорционального представления классов, важно включить пограничные и нетипичные случаи (edge cases). Это помогает понять, как система поведет себя в стрессовых или редких ситуациях.

Где искать готовые наборы информации?

Не всегда нужно собирать материалы с нуля. Существует множество открытых и проверенных источников, которые специалисты по всему миру используют для обучения и сравнения своих алгоритмов. Использование публичных датасетов также позволяет сопоставить свои результаты с результатами других исследователей.

- Kaggle: одна из крупнейших платформ для соревнований по машинному обучению с огромной коллекцией наборов на любую тематику.

- Google Dataset Search: поисковая система от Google, которая индексирует открытые наборы из тысяч источников по всему интернету.

- UCI Machine Learning Repository: один из старейших и самых уважаемых архивов, содержащий классические датасеты, которые часто используются в научных статьях.

- Hugging Face Datasets: популярная библиотека и платформа, ориентированная в первую очередь на задачи обработки естественного языка (NLP), но содержащая и много других полезных коллекций.

Практические ошибки при работе с тестовыми данными

Самая распространенная ошибка — это «подглядывание» в тестовый набор. Это происходит, когда разработчик многократно прогоняет модель на тестовой выборке и на основе результатов меняет ее параметры. Так делать нельзя. Тестовый набор должен оставаться «черным ящиком» до самого финала. Любое решение, принятое на основе производительности на нем, фактически превращает его в часть процесса обучения, и для объективной оценки потребуется уже новый, четвертый набор. Помните: один тест — одна финальная оценка. Это золотое правило обеспечивает честность и объективность при оценке создаваемого продукта.