Визуальные средства парсинга

Визуальные средства парсинга — это категория программного обеспечения, которая позволяет извлекать структурированную информацию с веб-страниц через графический интерфейс, без необходимости писать код. Этот подход демократизирует процесс сбора сведений, делая его доступным для маркетологов, аналитиков, предпринимателей и всех, кому нужны структурированные материалы из интернета, но кто не обладает навыками программирования. Вместо написания скриптов, пользователь взаимодействует с веб-страницей напрямую в окне приложения, указывая, какие элементы нужно собрать.

Принцип работы: магия "point-and-click"

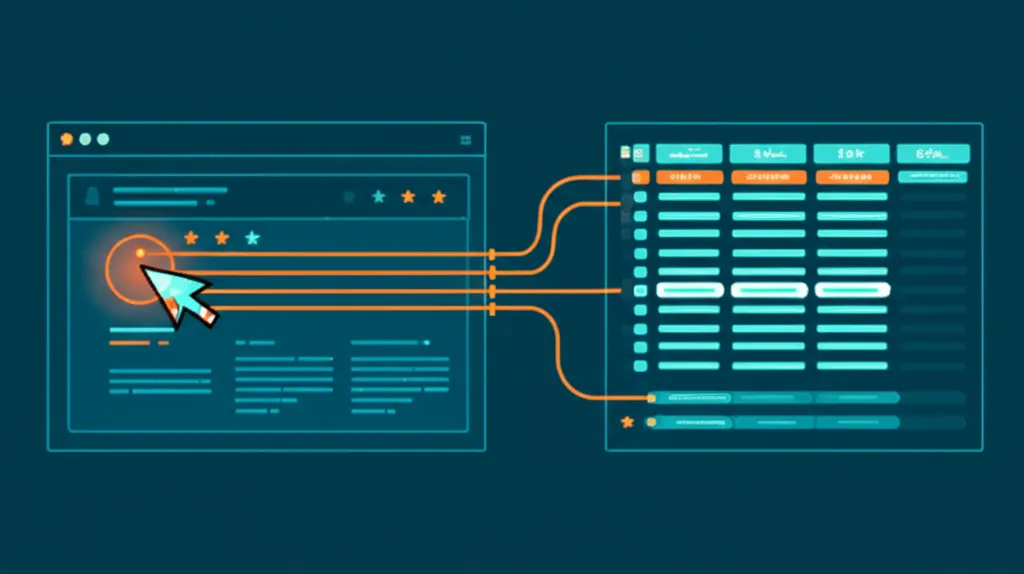

Основа функционирования таких решений — интуитивно понятный механизм "укажи и кликни" (point-and-click). Процедура выглядит просто: вы открываете целевой веб-ресурс внутри специального браузера, встроенного в программу, и мышкой выделяете нужные фрагменты: заголовки товаров, цены, описания, контактные телефоны или отзывы. Программа анализирует HTML-структуру выделенных элементов и автоматически создает правило для их извлечения. Далее, этот алгоритм применяется ко всем однотипным страницам, например, ко всем карточкам товаров в категории интернет-магазина.

Этот механизм можно сравнить с обучением ассистента. Вы один раз показываете ему, какую информацию нужно скопировать со страницы и в какую колонку таблицы вставить. После этого ассистент сможет самостоятельно обработать сотни похожих страниц. Визуальный парсер действует аналогично, но делает это в тысячи раз быстрее и без ошибок, свойственных человеку. Он может следовать по ссылкам, обрабатывать пагинацию (переключение страниц) и даже взаимодействовать с интерактивными элементами вроде выпадающих списков.

Кому и зачем нужны визуальные экстракторы?

Сфера применения подобных инструментов чрезвычайно широка. Они становятся незаменимыми помощниками для специалистов из разных областей, которым требуется оперативно получать сведения для анализа и принятия решений.

- Электронная коммерция. Владельцы интернет-магазинов используют их для мониторинга цен конкурентов, отслеживания ассортимента и наличия товаров, а также для автоматического наполнения собственных каталогов контентом с сайтов поставщиков.

- Маркетинг и PR. Маркетологи собирают упоминания бренда в сети, отзывы клиентов о продуктах, анализируют контент-стратегии конкурентов и формируют базы потенциальных клиентов (лидогенерация) из открытых источников.

- Аналитика и исследования. Аналитики могут быстро агрегировать статистические показатели, финансовые отчеты, результаты спортивных матчей или любую другую информацию для рыночных исследований без привлечения разработчиков.

- Рынок труда. HR-специалисты и рекрутеры могут парсить порталы по трудоустройству для сбора актуальных вакансий, анализа требований к кандидатам и мониторинга средних зарплат по отрасли.

Визуальный парсер — это не замена квалифицированному программисту, а скорее мощный инструмент в руках специалиста, которому нужно быстро получить структурированные сведения для конкретной бизнес-задачи.

Преимущества и ограничения подхода

Как и любая технология, no-code скрейпинг имеет свои сильные и слабые стороны. Понимание этих аспектов помогает выбрать правильное решение для конкретной задачи.

Основные плюсы

- Доступность. Главное достоинство — отсутствие необходимости в знаниях языков программирования (Python, JavaScript) и понимании тонкостей веб-разработки.

- Скорость. Настройка проекта по сбору информации занимает минуты, а не часы или дни, которые могли бы уйти на написание и отладку скрипта.

- Наглядность. Весь процесс настройки происходит в визуальном режиме. Вы сразу видите, какие элементы выбираете и какой результат получите.

- Экономия ресурсов. Снижаются затраты на разработку, поскольку не требуется нанимать программиста или отвлекать штатных IT-специалистов.

Сложности и подводные камни

Несмотря на очевидные преимущества, существуют и ограничения. Визуальные решения могут не справиться с некоторыми сложными сценариями, где требуется гибкость кастомного кода.

- Динамические сайты. Ресурсы, активно использующие JavaScript для подгрузки контента (бесконечная прокрутка, всплывающие окна), могут стать серьезным препятствием для простых парсеров.

- Защита от ботов. Современные веб-порталы часто используют системы защиты, такие как CAPTCHA или Cloudflare, которые блокируют автоматизированную активность. Продвинутые платформы предлагают встроенные решения для обхода, но они не всегда эффективны.

- Нестандартная структура. Если структура страниц на одном ресурсе сильно отличается, настроить универсальное правило для сбора становится сложно или невозможно.

- Зависимость от платформы. Вы привязаны к функционалу, тарифам и ограничениям конкретного сервиса. Если его возможностей перестанет хватать, придется искать альтернативу.

Популярные платформы на рынке

На рынке существует множество сервисов для визуального скрейпинга, от простых браузерных расширений до мощных облачных платформ. Среди наиболее известных можно выделить Octoparse, предлагающий сложные сценарии и облачное исполнение; ParseHub, известный своей гибкостью при работе с динамическими веб-ресурсами; и Import.io, который позиционирует себя как комплексное решение для интеграции веб-контента в бизнес-процессы. Также популярны такие программы, как Web Scraper (расширение для Chrome) и Scrapinghub (Zyte), предоставляющий более продвинутые корпоративные решения.

Выбор конкретной программы зависит от сложности задач, объемов необходимой информации и бюджета. Для простых разовых операций может быть достаточно бесплатного браузерного расширения, тогда как для регулярного мониторинга сотен страниц потребуется надежная облачная платформа с возможностью запуска по расписанию и ротацией IP-адресов.